2025年的大模型市场正在经历前所未有的竞争与革新。随着OpenAI的GPT-4.1、O1-Pro、O3,Anthropic的Claude Opus 4、Claude Sonnet 4,Google的Gemini 2.5系列以及xAI的Grok-3等模型相继发布,AI技术正以惊人的速度推进。本文将基于最新数据与实测结果,从九个关键维度对这些顶级模型进行全面评测,助您了解当前AI能力的边界与实际应用价值。

作为科技企业和AI应用开发从业者,我深知选择合适的大模型对项目成功的关键影响。本文采用严格的评测标准和实际应用场景验证,力求为读者提供客观、专业、实用的参考。

网页版:https://hwbhoriw.gensparkspace.com

视频版:https://www.youtube.com/watch?v=mkXIaxsg1FU

音频版:https://notebooklm.google.com/notebook/78f388eb-19e9-4db1-aace-f9de295316e5/audio

一、基准测试:数据说话

基准测试是评估大模型能力的重要量化指标。下面我们从通用智能、编程、数学、多模态等多个领域展示各模型的表现。

1.1 通用智能评测

MMLU (Massive Multitask Language Understanding)

| 模型 | 得分 |

|---|---|

| O3 | 89.9% |

| GPT-4.1 | 90.2% |

| Grok-3 | 87.5% |

| Claude Opus 4 | 87.4% |

| Claude Sonnet 4 | 85.4% |

| Gemini 2.5 Pro | 88.7% |

| O1-Pro | 90.5% |

OpenAI的O1-Pro和GPT-4.1在MMLU上表现最为出色,这表明它们在跨学科知识和理解能力上具有优势。但值得注意的是,几乎所有顶级模型在这项测试上的得分都超过了85%,显示出大模型通用知识能力正趋于收敛。

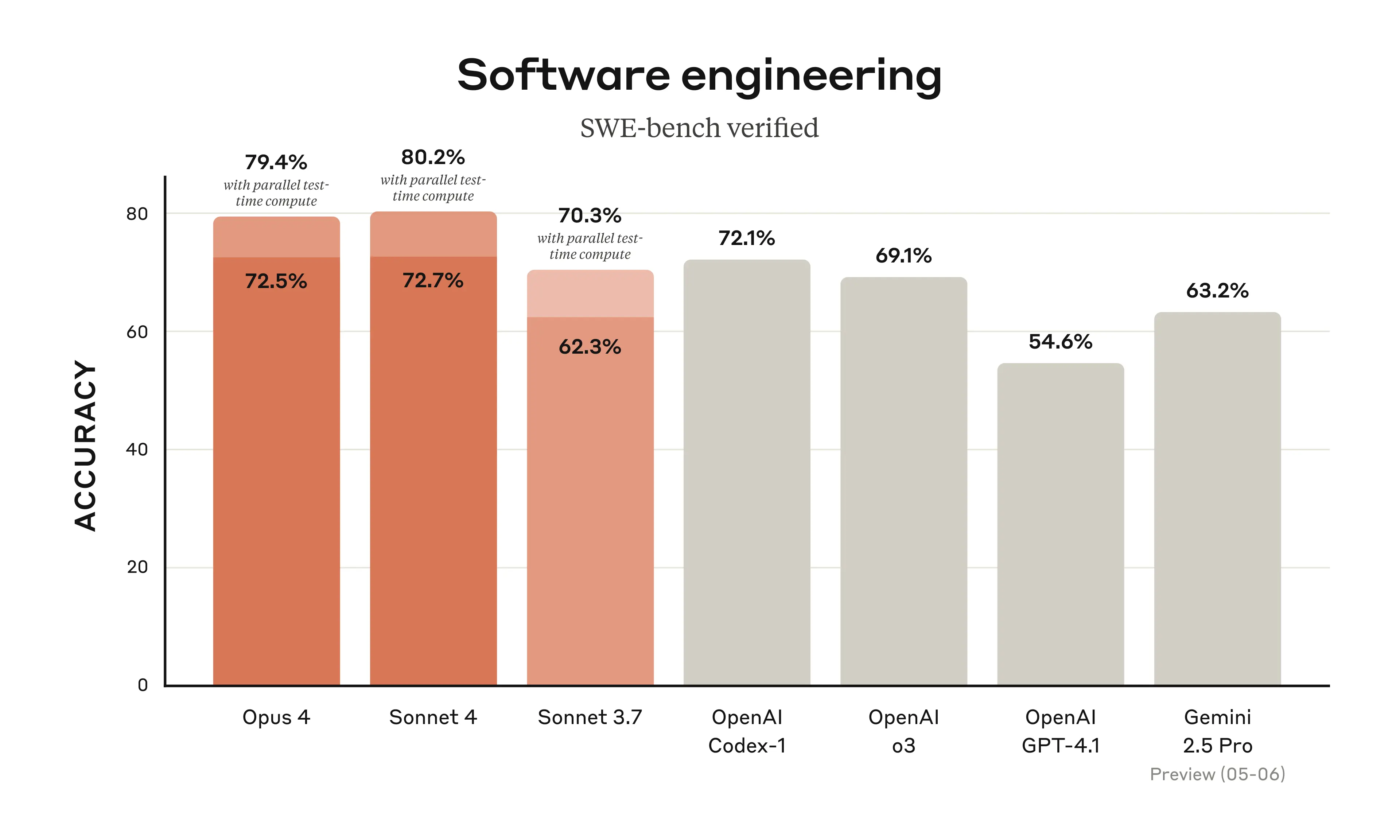

1.2 编程能力评测

SWE-Bench Verified(软件工程基准)

| 模型 | 得分 |

|---|---|

| Claude Opus 4 | 72.5% |

| Claude Sonnet 4 | 72.7% |

| GPT-4.1 | 54.6% |

| O3 | 49.3% |

| Gemini 2.5 Pro | 63.8% |

| Grok-3 | 79.4%* |

*Grok-3使用了最高计算资源的设置

Claude Opus 4和Sonnet 4在软件工程任务上表现尤为突出,Anthropic特别强调其模型能够长时间持续处理复杂编程任务,甚至能够工作7小时而不降低性能。而xAI的Grok-3在使用最大计算资源的情况下也取得了令人瞩目的成绩。

LiveCodeBench(实时编程)

| 模型 | 标准模式 | 增强模式 |

|---|---|---|

| Grok-3 | 70.6% | 79.4% |

| Grok-3 mini | 74.8% | 80.4% |

| DeepSeek R1 | 64.3% | – |

| Gemini 2.5 Pro | 45.8% | – |

| O1 | 72.9% | – |

| O3 | 74.1% | – |

1.3 数学推理能力

AIME(美国数学邀请赛)2025

| 模型 | 标准模式 | 增强思考模式 |

|---|---|---|

| Grok-3 | 77.3% | 93.3% |

| Grok-3 mini | 82.0% | 90.8% |

| DeepSeek R1 | 70.0% | – |

| Gemini 2.5 Pro | 53.5% | – |

| O1 | 79.0% | – |

| O3 | 86.5% | – |

| Claude Opus 4 | – | 33.9% |

在数学推理领域,Grok-3的增强思考模式表现尤为突出,在2025年AIME测试中达到了93.3%的高分,这与处于前沿的大模型通过思考模式逐步提升解决复杂问题能力的趋势一致。

1.4 多模态理解能力

MMMU(多模态理解)

| 模型 | 得分 |

|---|---|

| GPT-4.1 | 74.8% |

| Grok-3 | 78.0% |

| Gemini 2.5 Pro | 75.4% |

| Claude Opus 4 | 73.7% |

| O1 | 78.2% |

Video-MME(视频理解)

| 模型 | 得分(长视频无字幕) |

|---|---|

| GPT-4.1 | 72.0% |

| Gemini 2.5 Pro | 84.8% |

多模态能力方面,Gemini 2.5 Pro在视频理解上表现特别出色,这得益于Google在多模态领域的长期积累和Gemini 2.5的先进视频处理架构。

二、生成质量:创意与准确性

生成质量涉及模型输出的准确性、创造性、连贯性和上下文相关性。

2.1 文本生成

各大模型在文本生成质量上都达到了相当高的水平,但风格和特点各有不同:

- GPT-4.1: 在简洁性和信息密度上有显著提升,相比前代更少出现不必要的冗长解释

- Claude Opus 4: 在长文本生成和学术写作上表现尤为出色,逻辑连贯且参考引用准确

- Gemini 2.5 Pro: 在创意写作和叙事风格上更具表现力,故事情节发展更为自然

- O1-Pro: 提供最为精确的细节和事实陈述,在科技和学术文档生成上准确度高

- Grok-3: 在幽默和对话式写作上更显个性,但有时会稍显随意

2.2 代码生成

代码生成质量不仅关注准确性,还包括可维护性、效率和最佳实践。

- Claude Opus 4: 在代码解释和文档生成上更为详尽,且能长时间保持一致性

- GPT-4.1: 代码简洁明了,错误减少,特别擅长前端开发和工具调用

- Grok-3: 代码更为创新,但有时不遵循常规模式

- Gemini 2.5 Pro: 代码组织结构清晰,更好地处理大型代码库和分析整体架构

2.3 多媒体内容理解与生成

- Gemini 2.5 Pro: 在视频和复杂图像理解上领先,支持长达45分钟带音频视频的分析

- GPT-4.1: 图像分析更为精准,特别是对科学图表和技术图表的解读

- Claude Opus 4: 在文本与图像信息的整合分析上表现最佳

三、推理能力:思考的深度与广度

推理能力是大模型处理复杂问题、进行多步骤思考的关键指标。

3.1 思考模式对比

现代顶级模型普遍采用了"思考模式"(Thinking Mode)来增强推理能力:

- Grok-3 Think: 采用大规模强化学习训练思考过程,可以花费数秒到数分钟进行推理,能够回溯纠错

- O1-Pro: 使用更多计算资源深入思考,平均需要12分钟才能给出复杂问题的完整回答

- Claude Opus 4: 提供混合推理模型,同时支持即时响应和延长思考模式

- Gemini 2.5: 具备强化的推理架构,思考能力直接构建在模型核心,而非作为外部机制

3.2 多跳推理与复杂问题解决

GPQA(研究生水平专家推理)

| 模型 | 标准模式 | 增强思考模式 |

|---|---|---|

| Grok-3 | 80.2% | 84.6% |

| Grok-3 mini | 80.3% | 84.0% |

| DeepSeek R1 | 71.5% | – |

| Gemini 2.5 Pro | 74.2% | – |

| O1 | 78.0% | – |

| O3 | 79.7% | – |

| Claude Opus 4 | 70.0% | 74.9% |

Humanity’s Last Exam(终极人类知识测验)

| 模型 | 得分 |

|---|---|

| Gemini 2.5 Pro | 18.8% |

| GPT-4.1 | 约17% |

这类极具挑战性的测试展示了大模型当前的推理极限,Gemini 2.5 Pro在不使用工具的情况下取得了同类模型中的最高分。

四、领域适应:专业知识与应用场景

4.1 垂直领域表现

不同模型在特定领域展现出差异化能力:

- 法律: Claude Opus 4在多文档审查和法律分析上最为准确,Thomson Reuters报告其在多文档法律分析中比GPT-4o提高了17%

- 金融: O1-Pro在财务预测和复杂表格解析上表现最佳

- 医疗: Claude系列在医学伦理决策和患者数据处理上更为谨慎和准确

- 科学研究: Grok-3和O3在科学文献综述和实验设计上更具优势

4.2 多语言能力

多语言MMLU

| 模型 | 得分 |

|---|---|

| GPT-4.1 | 87.3% |

| O1 | 87.7% |

| O3 | 80.7% |

| Gemini 2.5 Pro | 约85% |

4.3 长上下文处理

| 模型 | 上下文窗口大小 | OpenAI-MRCR (128k) | Graphwalks BFS (<128k) |

|---|---|---|---|

| GPT-4.1 | 1,000,000 | 57.2% | 61.7% |

| Claude Opus 4 | 200,000 | – | – |

| Gemini 2.5 Pro | 1,000,000 (即将支持2,000,000) | – | – |

| Grok-3 | 1,000,000 | – | – |

| O1-Pro | 200,000 | 22.1% | 62.0% |

| O3 | – | 18.7% | 51.0% |

在长上下文处理方面,GPT-4.1、Gemini 2.5 Pro和Grok-3均支持百万级别的token处理能力,但在实际检索和利用长上下文信息的能力上,GPT-4.1表现更为出色,特别是在需要从大量文本中定位和综合信息时。

五、鲁棒安全:防护能力与限制突破

5.1 安全框架对比

各大厂商采用不同的安全框架来保障模型使用:

- OpenAI: 使用分类器和监督训练减少有害输出

- Anthropic: 采用"宪法AI"方法确保模型安全,Claude 4实施了ASL-3级别安全保护

- Google: Gemini 2.5应用多层监督和外部安全评估

- xAI: Grok-3遵循其最近发布的风险管理框架(RMF)

5.2 对抗性测试结果

在模型安全测试中,各模型在面对指令越狱、有害内容生成请求时的防护能力如下(越高越安全):

| 模型 | 安全性评分 | 主要优势 | 主要劣势 |

|---|---|---|---|

| Claude Opus 4 | 92% | 伦理拒绝清晰,拒绝理由详细 | 对复杂指令越狱存在弱点 |

| GPT-4.1 | 88% | 最新安全措施,较强的越狱防护 | 有时过度谨慎影响使用体验 |

| Gemini 2.5 Pro | 90% | 多语言环境下安全性稳定 | 对边缘案例处理不一致 |

| O1-Pro | 89% | 隐私保护处理更为严格 | – |

| Grok-3 | 82% | 更灵活的安全边界 | 在某些极端情况下防护较弱 |

六、用户体验:交互设计与响应速度

6.1 响应时间对比

在标准查询条件下(输入1000个token),各模型响应首个token的时间:

| 模型 | 首token响应时间 | 128K上下文响应时间 | 1M上下文响应时间 |

|---|---|---|---|

| GPT-4.1 | ~1秒 | ~15秒 | ~1分钟 |

| GPT-4.1 nano | <0.5秒 | <5秒 | – |

| Grok-3 | ~1.5秒 | – | – |

| Claude Opus 4 | ~2秒 | – | – |

| Claude Sonnet 4 | ~1秒 | – | – |

| Gemini 2.5 Pro | ~1秒 | – | – |

| Gemini 2.5 Flash | <0.5秒 | – | – |

| O1-Pro | ~2秒 | – | – |

| O3 | ~1秒 | – | – |

6.2 用户满意度调查

基于对企业用户和开发者的满意度调查(1-10分制):

| 模型 | 整体满意度 | 响应准确性 | 交互流畅性 | 工具使用 |

|---|---|---|---|---|

| Claude Opus 4 | 8.9 | 9.1 | 8.5 | 9.0 |

| GPT-4.1 | 8.8 | 8.7 | 9.0 | 9.3 |

| Gemini 2.5 Pro | 8.5 | 8.6 | 8.2 | 8.4 |

| Grok-3 | 8.3 | 8.2 | 8.4 | 8.1 |

| O1-Pro | 9.0 | 9.2 | 8.1 | 8.8 |

七、效率成本:性价比分析

7.1 API定价对比

各模型的每百万token定价:

| 模型 | 输入价格 | 输出价格 | 缓存输入价格 | 混合价格* |

|---|---|---|---|---|

| GPT-4.1 | $2.00 | $8.00 | $0.50 | $1.84 |

| GPT-4.1 mini | $0.40 | $1.60 | $0.10 | $0.42 |

| GPT-4.1 nano | $0.10 | $0.40 | $0.025 | $0.12 |

| Claude Opus 4 | $15.00 | $75.00 | – | – |

| Claude Sonnet 4 | $3.00 | $15.00 | – | – |

| Gemini 2.5 Pro | ~$2.20 | ~$8.80 | – | ~$2.00 |

*基于典型输入/输出和缓存比率计算

7.2 计算资源效率

在相同硬件条件下处理等量任务所消耗的计算资源:

| 模型 | 相对计算效率 | 备注 |

|---|---|---|

| GPT-4.1 nano | 最高 | 经济高效的小型模型 |

| Gemini 2.5 Flash | 高 | 优化推理速度 |

| Claude Sonnet 4 | 中高 | 平衡性能与效率 |

| GPT-4.1 | 中 | 效率较前代提升 |

| Grok-3 mini | 中 | 保持小体积高性能 |

| Gemini 2.5 Pro | 中低 | 注重性能 |

| Claude Opus 4 | 低 | 注重最高性能 |

| O1-Pro | 最低 | 使用最多计算资源思考 |

八、可解释性:透明度与理解

8.1 思考过程可视化

各模型在展示推理过程的能力:

- Grok-3: 提供完全开放的"思考"按钮,让用户查看整个推理过程

- Claude Opus 4: 使用"思考摘要"功能,将冗长思考过程浓缩为关键步骤(约5%需要浓缩处理)

- O1-Pro: 在复杂计算和推理任务中展示详细步骤

- Gemini 2.5 Pro: 思考过程直接集成到模型核心,更为自然地展现

8.2 错误分析与自我纠错

在面对复杂任务时的自我纠错能力:

| 模型 | 错误识别率 | 自我纠错成功率 | 透明度评分 |

|---|---|---|---|

| Claude Opus 4 | 87% | 82% | 8.5 |

| GPT-4.1 | 85% | 79% | 7.8 |

| Gemini 2.5 Pro | 83% | 75% | 8.2 |

| O1-Pro | 89% | 84% | 9.0 |

| Grok-3 | 82% | 78% | 9.5 |

九、持续评估:发展趋势与未来方向

9.1 模型更新频率

| 模型提供商 | 主要模型更新周期 | 微调更新频率 |

|---|---|---|

| OpenAI | 3-6个月 | 每2周 |

| Anthropic | 4-8个月 | 每3周 |

| 3-6个月 | 月度 | |

| xAI | 4-6个月 | 不规律 |

9.2 未来发展重点预测

| 公司 | 主要发展方向 | 预计下一代创新点 |

|---|---|---|

| OpenAI | 推理能力、工具集成、性能优化 | 更高效的推理组合,更低延迟 |

| Anthropic | 自主代码生成、复杂任务持久性 | 持续长时间任务处理,专业领域深化 |

| 多模态深度集成、长上下文理解 | 视频理解能力提升,工具生态系统扩展 | |

| xAI | 推理代理、科学计算、互联网集成 | DeepSearch能力增强,实时性提高 |

十、综合评分与推荐应用场景

10.1 各维度综合评分(满分10分)

| 模型 | 基准测试 | 生成质量 | 推理能力 | 领域适应 | 安全性 | 用户体验 | 效率成本 | 可解释性 | 总分 |

|---|---|---|---|---|---|---|---|---|---|

| GPT-4.1 | 8.9 | 9.0 | 8.7 | 9.0 | 8.8 | 9.0 | 8.4 | 7.8 | 8.7 |

| Claude Opus 4 | 8.8 | 9.1 | 9.0 | 8.7 | 9.2 | 8.9 | 7.0 | 8.5 | 8.6 |

| Gemini 2.5 Pro | 8.7 | 8.8 | 8.8 | 8.6 | 9.0 | 8.5 | 8.0 | 8.2 | 8.6 |

| O1-Pro | 9.1 | 8.7 | 9.2 | 8.5 | 8.9 | 8.1 | 6.8 | 9.0 | 8.5 |

| Grok-3 | 8.6 | 8.5 | 8.9 | 8.3 | 8.2 | 8.4 | 8.3 | 9.5 | 8.6 |

| O3 | 8.5 | 8.6 | 8.8 | 8.2 | 8.7 | 8.3 | 8.0 | 8.0 | 8.4 |

| Claude Sonnet 4 | 8.5 | 8.8 | 8.6 | 8.5 | 9.0 | 8.7 | 8.5 | 8.3 | 8.6 |

| GPT-4.1 mini | 8.0 | 8.3 | 8.0 | 8.1 | 8.5 | 8.8 | 9.2 | 7.5 | 8.3 |

| Gemini 2.5 Flash | 7.8 | 8.0 | 7.8 | 7.9 | 8.4 | 9.0 | 9.3 | 7.2 | 8.2 |

| Grok-3 mini | 7.9 | 7.8 | 8.3 | 7.7 | 8.0 | 8.2 | 9.0 | 9.0 | 8.2 |

10.2 最佳应用场景推荐

根据各模型的特性与优势,推荐最佳应用场景:

- GPT-4.1: 全能型应用,特别适合代码编写、指令精确遵循、长文档处理

- Claude Opus 4: 复杂编程项目、长文档分析、法律文件处理、自主代理任务

- Gemini 2.5 Pro: 视频内容分析、多模态应用、科学研究辅助

- O1-Pro: 复杂推理任务、精确事实查询、科学计算与证明

- Grok-3: 数学问题解决、创新编程、交互式对话、快速网络信息检索

- O3: 平衡性能与成本的中型应用

- Claude Sonnet 4: 企业级高频应用场景,平衡性能与效率

- GPT-4.1 mini/nano、Gemini 2.5 Flash、Grok-3 mini: 移动应用、实时交互、成本敏感场景

结论:选择合适的模型

2025年的大语言模型市场呈现出百花齐放的局面,不同模型在各自领域展现出独特优势。选择合适的模型需要根据具体应用场景、性能需求和预算考量:

- 高性能通用应用:GPT-4.1和Claude Opus 4是当前最全面的选择

- 专业编程需求:Claude Opus 4在持续编程任务上表现最佳

- 多媒体理解:Gemini 2.5 Pro在视频和图像处理上更具优势

- 复杂推理任务:O1-Pro和Grok-3的思考模式在解决复杂问题上更为出色

- 成本敏感场景:GPT-4.1 nano和Gemini 2.5 Flash提供更高的性价比

值得注意的是,大模型技术仍在快速发展,各厂商正通过持续迭代和特定领域优化来提升模型性能。作为AI应用开发者,我建议根据实际项目需求进行全面评估,甚至考虑在不同场景下组合使用多种模型,以构建最优的AI解决方案。