想象一下这样的场景:你在一个雾蒙蒙的早晨准备出门,手机天气App显示今天降雨概率70%。你会带伞吗?这个看似简单的决定背后,其实隐藏着概率统计学的核心思想。今天,让我们一起踏上这趟探索之旅,看看概率统计如何从抽象的数学概念,变成我们理解世界、做出决策的强大工具。

网页版:https://wcrbkhnj.gensparkspace.com

视频版:https://www.youtube.com/watch?v=q9p_8RzPkvw

音频版:https://notebooklm.google.com/notebook/9f600761-94a1-418a-b65d-d953e9bc5f48/audio

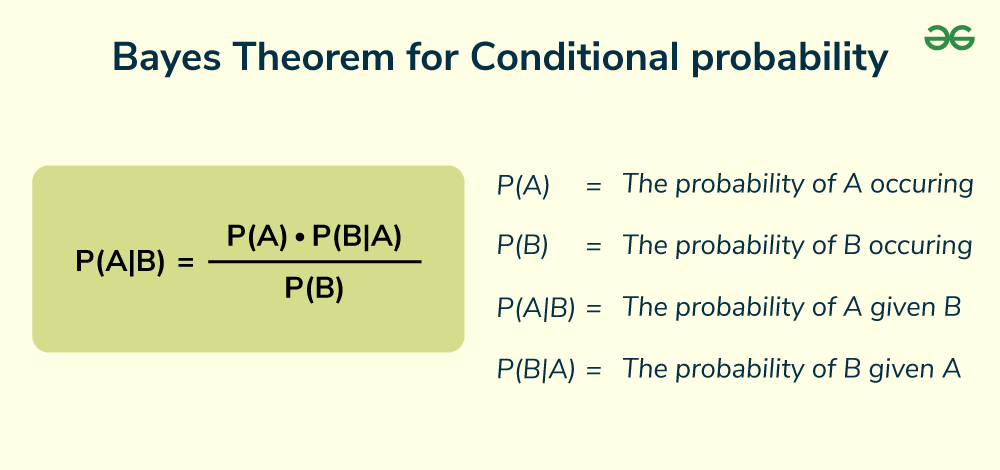

贝叶斯定理:更新我们对世界的认知

托马斯·贝叶斯在1763年提出的这个定理,就像是给我们的大脑装了一个"更新系统"。每当新信息到来时,我们就能更精确地调整自己的判断。

设想这样一个故事:医生小李刚刚接到一份检测报告。患者王大爷的癌症筛查结果呈阳性。乍一看,这似乎是个坏消息。但小李医生知道,这个检测的准确率是95%,而这种癌症在王大爷这个年龄段的发病率只有0.1%。

根据贝叶斯定理的计算方法,即使检测结果呈阳性,王大爷实际患癌的概率仅约为1.9%。这个结果让人意外,却完美诠释了贝叶斯思维的威力:我们不能仅凭表面信息就下结论,而要综合考虑先验知识和新证据。

在机器学习领域,贝叶斯定理的应用更是广泛。垃圾邮件过滤器就是一个典型例子。每当收到一封新邮件,系统会分析邮件中的词汇,计算每个词出现在垃圾邮件中的概率,最后得出这封邮件是垃圾邮件的综合概率。

概率分布:描绘不确定性的图谱

如果说概率是描述单个事件不确定性的工具,那么概率分布就是描绘整个不确定世界的地图。

想象你经营一家咖啡店,每天的顾客流量都不相同。有时门庭若市,有时门可罗雀。但如果你记录足够长时间的数据,就会发现这些看似随机的数字背后隐藏着规律。

**高斯分布(正态分布)**就像是自然界的"默认设置"。从学生的考试成绩到人们的身高体重,从工厂产品的尺寸偏差到股票价格的日波动,都近似遵循这个优美的钟形曲线。这种分布的数学性质让它在统计学中占据核心地位。

伯努利分布则更加简单直接,它只关心"是"或"否"。抛硬币、用户是否点击广告、病人是否康复,这些都是伯努利分布的领域。虽然单个伯努利试验看起来简单,但当我们重复进行多次试验时,就得到了二项分布,这在质量控制和A/B测试中有着广泛应用。

假设检验:科学决策的基石

在数据驱动的时代,我们经常需要做出各种决策。新药是否有效?新的广告策略是否能提高转化率?机器学习模型的性能是否有显著改善?假设检验为这些问题提供了科学的答案。

假设检验的逻辑很像法庭审判。我们首先假设"被告无罪"(零假设),然后搜集证据。只有当证据强烈到足以"超越合理怀疑"时,我们才会改变最初的判断。在统计学中,这个"合理怀疑"的标准通常设定为5%的显著性水平。

想象一家电商公司想要测试新的推荐算法。他们将用户随机分为两组:一组使用原算法,另一组使用新算法。经过一段时间的试验,新算法组的转化率确实更高。但这种差异是真实的改进,还是仅仅由于随机波动造成的?假设检验能够帮助我们量化这种不确定性,给出可信的答案。

置信区间:量化不确定性的艺术

如果有人问你:"明天的气温会是多少度?"你可能很难给出确切的答案。但如果问:"明天的气温会在15-25度之间吗?"你就更有信心了。这就是置信区间的思想精髓。

置信区间不是告诉我们"答案是什么",而是告诉我们"答案可能在哪个范围内"。更重要的是,它还量化了我们对这个范围的信心程度。

一个有趣的例子是民意调查。当新闻报道说"某候选人的支持率为45%,误差范围±3%"时,这里的"误差范围"就来自置信区间的计算。它意味着如果我们重复进行同样的调查100次,大约有95次的结果会落在42%-48%的范围内。

最大似然估计:从数据中挖掘真相

在大数据时代,我们经常面临这样的挑战:手头有大量的观测数据,但不知道产生这些数据的真实机制是什么。最大似然估计(MLE)就是解决这个问题的利器。

设想你是一位考古学家,在古代遗址中发现了一批箭头。通过测量,你发现这些箭头的长度分布很有规律。现在你想推断:当时的工匠制作箭头时,他们的"标准长度"是多少?工艺水平的稳定性如何?

最大似然估计的思路是这样的:假设存在某个真实的制作标准,然后问:"在这个标准下,观察到当前这批箭头数据的可能性有多大?"我们选择让这种可能性最大化的参数值作为我们的估计。

在机器学习中,MLE无处不在。从简单的线性回归到复杂的神经网络,很多算法的训练过程本质上都是在进行最大似然估计。

因果推理:超越相关性的深度思考

"相关性不等于因果性"——这可能是统计学中最重要的警告之一。但在AI时代,我们不能满足于仅仅发现相关性,我们需要理解因果关系。

因果推理试图回答这样的问题:如果我们改变某个变量,会对其他变量产生什么影响?这种"如果…那么…"的思维模式,正是人类智能和现有AI系统的重要区别之一。

考虑一个实际例子:电商平台发现,购买过有机食品的用户往往更喜欢购买运动器材。这种相关性很强,但我们能说"购买有机食品导致对运动器材的需求增加"吗?也许真实的情况是:注重健康的生活态度同时影响了这两种购买行为。

现代因果推理方法,如结构因果模型和反事实推理,正在帮助我们建立更可靠的因果关系模型。这些方法在精准医疗、政策制定、商业策略等领域都有重要应用。

AI模型中的不确定性量化

随着AI系统在关键决策中扮演越来越重要的角色,理解和量化模型的不确定性变得至关重要。当自动驾驶汽车说"前方有90%的概率是行人"时,那10%的不确定性可能意味着生死之别。

AI中的不确定性主要分为两类:偶然不确定性(aleatoric uncertainty)和认知不确定性(epistemic uncertainty)。前者源于数据本身的随机性,后者源于我们对模型的不完全了解。

现代深度学习模型通常只给出点估计,缺乏对不确定性的表示。这就像是一个过分自信的医生,对每个诊断都信心满满,从不表达疑虑。贝叶斯深度学习、集成方法、Monte Carlo Dropout等技术正在努力改变这种状况,让AI系统能够诚实地表达自己的不确定性。

Python实践:将理论转化为代码

让我们通过一个简单的Python示例来体验这些概念的实际应用。以下是一个基于贝叶斯定理的垃圾邮件分类器的核心逻辑:

import numpy as np

from collections import defaultdict

class NaiveBayesClassifier:

def __init__(self):

self.word_counts = defaultdict(lambda: defaultdict(int))

self.class_counts = defaultdict(int)

self.vocab = set()

def train(self, emails, labels):

for email, label in zip(emails, labels):

self.class_counts[label] += 1

words = email.split()

for word in words:

self.vocab.add(word)

self.word_counts[label][word] += 1

def predict(self, email):

words = email.split()

scores = {}

for class_name in self.class_counts:

score = np.log(self.class_counts[class_name])

for word in words:

if word in self.vocab:

# 拉普拉斯平滑

word_prob = (self.word_counts[class_name][word] + 1) / \

(sum(self.word_counts[class_name].values()) + len(self.vocab))

score += np.log(word_prob)

scores[class_name] = score

return max(scores, key=scores.get)

这个简单的实现展示了贝叶斯定理如何在实际代码中发挥作用。每个词的"垃圾邮件概率"都是通过历史数据计算得出的,而最终的分类决策则是所有词汇证据的贝叶斯综合。

生活中的概率思维

概率统计不仅仅是学术概念,它更是一种思维方式。当我们面对不确定性时,概率思维能帮助我们做出更理性的决策。

医生在诊断疾病时运用贝叶斯思维,综合症状、检查结果和疾病发病率来判断病情。投资者运用概率分布来评估风险和收益。工程师运用假设检验来验证产品改进的效果。这些都是概率统计在现实生活中的生动体现。

未来展望:概率统计与AI的深度融合

随着人工智能技术的快速发展,概率统计正在迎来新的春天。从贝叶斯神经网络到概率编程语言,从因果发现算法到不确定性量化方法,概率统计的理念正在深刻影响着AI的发展方向。

在这个充满不确定性的世界中,概率统计为我们提供了一套完整的工具集,帮助我们理解数据、量化不确定性、做出明智决策。无论你是数据科学家、产品经理,还是普通的决策者,掌握这些概念都将让你在面对复杂世界时更加从容。

正如著名统计学家George Box所说:"所有模型都是错误的,但有些是有用的。"概率统计教会我们的不是寻找完美的确定性,而是学会在不确定性中航行,在概率的海洋中找到通往真理的航线。