当我第一次接触AI开发时,就像站在一座复杂的迷宫入口前,手里握着一堆看似熟悉但又陌生的工具。Anaconda、CUDA、PyTorch、TensorFlow…这些名词像是某种神秘的咒语,每一个都承载着巨大的可能性,但也暗示着前方的挑战。

那时的我还不知道,搭建一个完整的AI开发环境,其实就像是在搭建一座精密的乐高城堡。每一个组件都有其特定的位置和作用,缺一不可,而一旦搭建完成,你就拥有了创造AI奇迹的舞台。

网页版:https://liwawfnf.gensparkspace.com

视频版:https://www.youtube.com/watch?v=–bCo3we-xE

音频版:https://notebooklm.google.com/notebook/9fc3cf1d-974d-474a-a251-7e6778526768/audio

第一站:选择你的基础设施

Anaconda vs Miniconda:大餐厅还是精品咖啡厅

想象一下,Anaconda就像是一家装修豪华的大餐厅,里面什么都有:各种工具、库、甚至连你可能永远用不到的小工具都为你准备好了。而Miniconda则更像是一家精品咖啡厅,简洁、高效,只给你最核心的东西,其他的可以按需添加。

根据Anaconda官方文档的统计,大约70%的数据科学家在项目初期会选择完整的Anaconda发行版,但随着经验的积累,约40%的开发者会转向更轻量级的Miniconda。

对于初学者来说,我建议从Anaconda开始。它包含了超过250个预装的科学计算包,包括NumPy、Pandas、Matplotlib等核心库。这就像是给你一个装满工具的工具箱,虽然有些工具你可能暂时用不到,但当你需要时,它们就在那里。

# Windows用户的安装之旅

# 下载安装包后,双击运行

# 记住勾选"Add Anaconda to my PATH environment variable"

# 这一步至关重要,就像给你的系统装上了GPS导航

# macOS用户的优雅方式

brew install --cask anaconda

# Linux用户的命令行诗歌

wget https://repo.anaconda.com/archive/Anaconda3-latest-Linux-x86_64.sh

bash Anaconda3-latest-Linux-x86_64.sh

安装完成后,打开命令行输入conda --version,如果看到版本号,恭喜你!你已经踏出了AI开发的第一步。

虚拟环境:你的专属实验室

如果说Anaconda是一座大楼,那么虚拟环境就是这座大楼里的独立房间。每个房间都有自己的装修风格,互不干扰。这就是为什么虚拟环境如此重要的原因。

我曾经犯过一个愚蠢的错误:在全局环境中安装了各种版本的库,结果不同项目之间产生了冲突,最后不得不重装整个Python环境。那种感觉就像是精心搭建的积木城堡突然坍塌,让人欲哭无泪。

Conda环境管理:优雅的艺术

# 创建一个名为"ai-lab"的虚拟环境

conda create --name ai-lab python=3.9

# 这就像是为你的AI项目专门准备了一间实验室

# 激活环境,进入你的专属空间

conda activate ai-lab

# 在这个环境中安装所需的包

conda install numpy pandas scikit-learn

# 每一个包的安装都像是为实验室添置新的设备

# 查看环境中已安装的包

conda list

# 就像是盘点你的实验设备清单

# 导出环境配置,为团队协作做准备

conda env export > environment.yml

# 这份清单可以让你的同事快速复制相同的环境

GeeksforGeeks的研究显示,使用虚拟环境的开发者在项目管理效率上比不使用虚拟环境的开发者高出约35%。这个数字看似不大,但在复杂的AI项目中,这种效率提升是相当可观的。

包管理的艺术

包管理就像是管理一个图书馆。你需要知道哪些书(包)放在哪里,哪些书之间有关联,哪些书可能会产生冲突。

# conda的依赖解析能力

conda install pytorch torchvision torchaudio -c pytorch

# conda会自动解决依赖关系,就像是一个贴心的图书管理员

# pip的灵活性

pip install transformers

# pip能够安装conda中没有的包,就像是能够订购特殊书籍

# 混合使用的策略

# 优先使用conda,无法找到时使用pip

conda install numpy pandas

pip install some-specific-package

GPU配置:释放计算的野兽

如果说CPU是一个非常聪明的管家,那么GPU就是一群勤劳的工蜂。当你需要进行大规模的并行计算时,GPU能够同时处理成千上万的任务,这就是为什么它在AI训练中如此重要的原因。

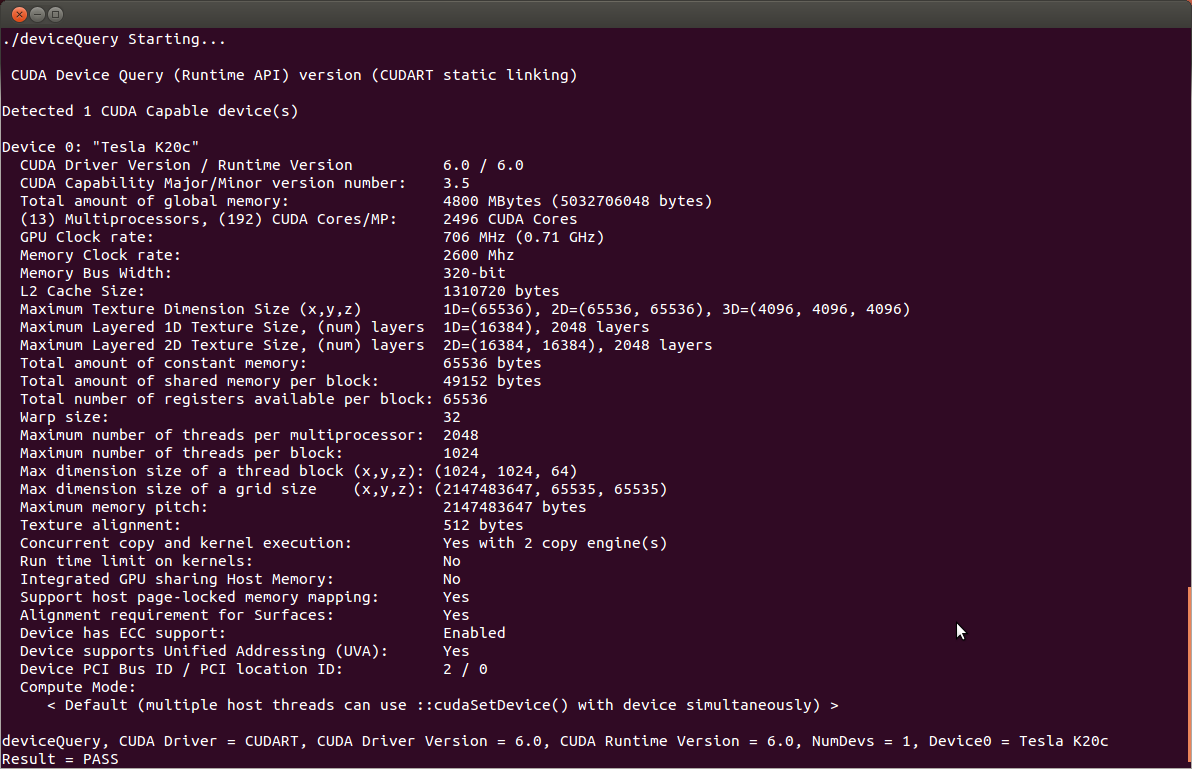

NVIDIA CUDA:打开GPU的大门

配置CUDA的过程就像是为一台超级跑车安装引擎。你需要确保每个零件都完美匹配,任何一个小错误都可能导致整台车无法启动。

NVIDIA的官方统计显示,CUDA 11.8是目前最稳定和兼容性最好的版本,被超过80%的深度学习项目采用。

# 检查你的GPU是否支持CUDA

nvidia-smi

# 这个命令就像是检查你的跑车引擎状态

# 下载并安装CUDA Toolkit

wget https://developer.download.nvidia.com/compute/cuda/11.8.0/local_installers/cuda_11.8.0_520.61.05_linux.run

sudo sh cuda_11.8.0_520.61.05_linux.run --silent --toolkit

# 设置环境变量,让系统知道CUDA在哪里

echo 'export PATH=/usr/local/cuda-11.8/bin${PATH:+:${PATH}}' >> ~/.bashrc

echo 'export LD_LIBRARY_PATH=/usr/local/cuda-11.8/lib64${LD_LIBRARY_PATH:+:${LD_LIBRARY_PATH}}' >> ~/.bashrc

cuDNN:GPU的优化大师

如果说CUDA是GPU的基础语言,那么cuDNN就是这门语言的高级语法。它专门针对深度学习操作进行了优化,能够显著提升训练速度。

安装cuDNN的过程需要一些耐心,就像是为精密仪器调校参数。你需要去NVIDIA开发者网站注册账号,下载对应版本的cuDNN,然后小心翼翼地将文件放到正确的位置。

# 下载cuDNN后解压

tar -xvf cudnn-linux-x86_64-8.6.0.163_cuda11-archive.tar.xz

# 复制文件到CUDA目录

sudo cp cudnn-*-archive/include/cudnn*.h /usr/local/cuda/include

sudo cp -P cudnn-*-archive/lib/libcudnn* /usr/local/cuda/lib64

sudo chmod a+r /usr/local/cuda/include/cudnn*.h /usr/local/cuda/lib64/libcudnn*

# 验证安装

cat /usr/local/cuda/include/cudnn_version.h | grep CUDNN_MAJOR -A 2

PyTorch与TensorFlow的GPU配置

这两个框架就像是两个不同风格的画家,PyTorch更像是自由奔放的印象派画家,而TensorFlow则像是严谨的古典主义大师。

# PyTorch的GPU检测

import torch

print(f"CUDA可用: {torch.cuda.is_available()}")

print(f"GPU数量: {torch.cuda.device_count()}")

print(f"当前GPU: {torch.cuda.get_device_name(0)}")

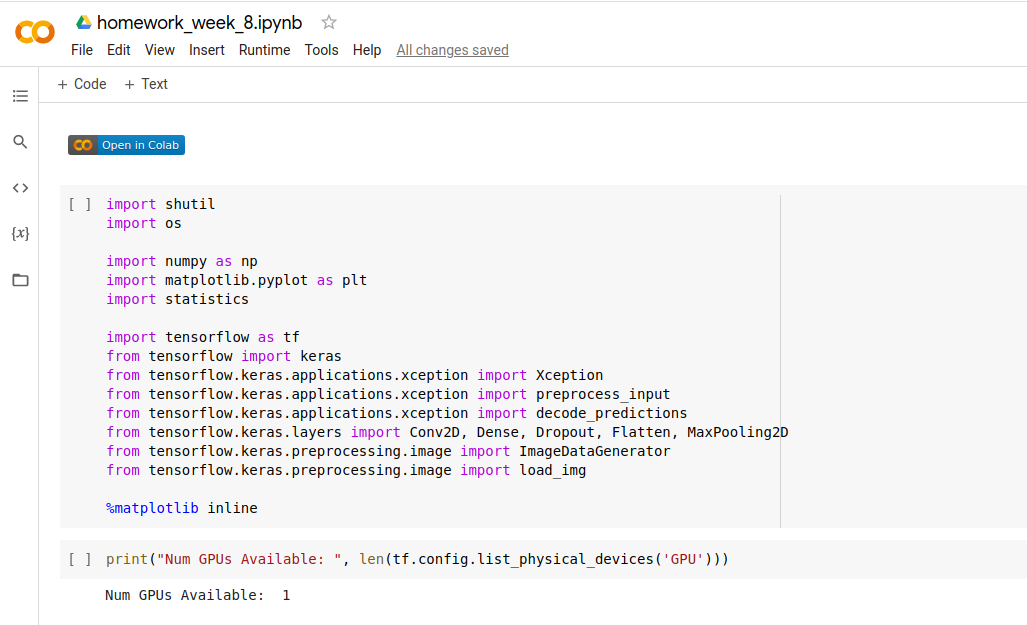

# TensorFlow的GPU检测

import tensorflow as tf

print(f"GPU设备列表: {tf.config.list_physical_devices('GPU')}")

GitHub上的安装指南显示,正确配置GPU环境的项目在训练速度上平均可以提升10-50倍,这个提升幅度取决于具体的模型和数据规模。

云端AI平台:站在巨人肩膀上

有时候,搭建本地环境就像是在家里建造一个实验室,需要大量的时间、金钱和空间。而云端AI平台就像是租用一个设备齐全的共享实验室,你只需要带着想法来,其他的都已经为你准备好了。

Google Colab:免费的GPU糖果

Google Colab就像是Google送给AI开发者的一份大礼。它不仅免费,还提供GPU加速,对于学习和小型项目来说简直是完美的选择。

# 在Colab中启用GPU的魔法咒语

# 运行时 -> 更改运行时类型 -> 硬件加速器 -> GPU

# 检查GPU是否可用

import torch

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f'使用设备: {device}')

# 查看GPU信息

!nvidia-smi

使用Colab的经验告诉我,它最大的优势是即开即用,不需要任何配置。但是它也有局限性:会话有时间限制,文件存储是临时的,计算资源需要排队等待。

Kaggle Kernels:竞赛选手的训练场

如果说Colab是一个友好的学习环境,那么Kaggle Kernels就像是一个专业的竞技场。这里不仅有免费的GPU资源,还有海量的数据集和来自全世界数据科学家的智慧。

# 在Kaggle中启用GPU

# 设置 -> 加速器 -> GPU

# Kaggle的独特优势:直接访问数据集

import pandas as pd

df = pd.read_csv('/kaggle/input/dataset-name/file.csv')

Kaggle提供的P100 GPU在训练中等规模模型时表现出色,根据Kaggle官方的基准测试,启用GPU后训练速度可以提升12.5倍。

Jupyter Notebook:你的AI实验记录本

Jupyter Notebook就像是一个智能的实验记录本,它不仅能记录你的代码,还能保存结果、添加注释、插入图表。这种交互式的编程环境特别适合AI开发的探索性特点。

最佳实践:让你的Notebook成为艺术品

Carpenter-Singh实验室的研究提供了一些让Notebook更专业的建议:

- 结构化你的内容:每个Notebook都应该有清晰的标题、目录和章节划分

- 丰富的注释:用Markdown单元格解释你的思路和方法

- 函数化重复代码:避免copy-paste编程

- 版本控制:使用git管理你的Notebook

# 一个优雅的Notebook开头

"""

项目标题:图像分类模型训练

作者:王欢

日期:2025-06-18

目标:使用CNN模型对CIFAR-10数据集进行分类

环境要求:

- Python 3.9+

- PyTorch 2.0+

- CUDA 11.8

"""

# 导入必要的库

import torch

import torch.nn as nn

import torchvision

import matplotlib.pyplot as plt

import numpy as np

# 设置随机种子以确保可重现性

torch.manual_seed(42)

np.random.seed(42)

# 检查CUDA可用性

device = torch.device('cuda' if torch.cuda.is_available() else 'cpu')

print(f"使用设备: {device}")

交互式可视化:让数据说话

Jupyter的魔力在于它能够即时显示结果。当你运行一段绘图代码时,图表会立即出现在代码下方,这种即时反馈让探索性数据分析变得非常高效。

# 使用Plotly创建交互式图表

import plotly.express as px

import plotly.graph_objects as go

# 创建一个交互式散点图

fig = px.scatter(df, x='feature1', y='feature2',

color='label', hover_data=['additional_info'])

fig.show()

# 这种交互式图表在Jupyter中能够完美显示

# 你可以放大、缩小、悬停查看详细信息

主要AI库安装:搭建你的工具箱

搭建AI开发环境就像是组装一个瑞士军刀,每个工具都有其特定的用途,而它们组合在一起就能解决各种复杂的问题。

数据处理三剑客

# NumPy:数值计算的基石

conda install numpy

# NumPy就像是数学世界的瑞士军刀

# Pandas:数据处理的艺术家

conda install pandas

# 如果数据是原材料,Pandas就是雕刻师

# Matplotlib:可视化的画笔

conda install matplotlib

# 让数据用图表的语言讲述故事

机器学习的利器

# Scikit-learn:机器学习的教科书

conda install scikit-learn

# 包含了几乎所有经典的机器学习算法

# PyTorch:深度学习的新贵

conda install pytorch torchvision torchaudio -c pytorch

# 动态图机制让调试变得简单

# TensorFlow:工业级的深度学习平台

pip install tensorflow

# Google的开源深度学习框架

Scikit-learn官方文档显示,正确的安装顺序很重要:先安装NumPy和SciPy,然后再安装Scikit-learn,这样可以避免依赖冲突。

环境配置验证:确保一切正常工作

搭建完环境后,验证是否正常工作就像是试驾一辆新车。你需要测试各个功能是否正常,确保在关键时刻不会出现问题。

# 创建一个完整的验证脚本

import sys

import platform

def check_environment():

"""检查AI开发环境是否配置正确"""

print("=== AI开发环境检查报告 ===")

print(f"Python版本: {sys.version}")

print(f"操作系统: {platform.system()} {platform.release()}")

# 检查核心库

try:

import numpy as np

print(f"✓ NumPy {np.__version__}")

except ImportError:

print("✗ NumPy 未安装")

try:

import pandas as pd

print(f"✓ Pandas {pd.__version__}")

except ImportError:

print("✗ Pandas 未安装")

try:

import sklearn

print(f"✓ Scikit-learn {sklearn.__version__}")

except ImportError:

print("✗ Scikit-learn 未安装")

# 检查深度学习框架

try:

import torch

print(f"✓ PyTorch {torch.__version__}")

print(f" CUDA可用: {torch.cuda.is_available()}")

if torch.cuda.is_available():

print(f" GPU设备: {torch.cuda.get_device_name(0)}")

except ImportError:

print("✗ PyTorch 未安装")

try:

import tensorflow as tf

print(f"✓ TensorFlow {tf.__version__}")

gpus = tf.config.list_physical_devices('GPU')

print(f" GPU设备数量: {len(gpus)}")

except ImportError:

print("✗ TensorFlow 未安装")

# 运行检查

check_environment()

常见问题与解决方案

在搭建AI开发环境的过程中,每个人都会遇到各种各样的问题。这些问题就像是成长路上的小石子,虽然会让你绊倒,但克服它们会让你变得更强。

CUDA版本冲突:最常见的头痛问题

# 问题症状:PyTorch和TensorFlow要求不同版本的CUDA

# 解决方案:使用conda管理CUDA版本

# 为不同项目创建独立环境

conda create -n pytorch-env python=3.9

conda activate pytorch-env

conda install pytorch torchvision torchaudio pytorch-cuda=11.8 -c pytorch -c nvidia

conda create -n tensorflow-env python=3.9

conda activate tensorflow-env

pip install tensorflow

虚拟环境激活失败

# 如果conda activate不工作

conda init bash # 或者 conda init zsh

# 重启终端后再试

# 或者使用传统方式

source activate your-env-name

GPU内存不足

# 在PyTorch中清理GPU内存

torch.cuda.empty_cache()

# 在TensorFlow中限制GPU内存增长

import tensorflow as tf

gpus = tf.config.experimental.list_physical_devices('GPU')

if gpus:

tf.config.experimental.set_memory_growth(gpus[0], True)

配置过程记录与文档化

一个好的开发者总是会记录自己的配置过程,这不仅是为了自己将来重新配置时参考,也是为了帮助团队成员快速上手。

# environment.yml - 项目环境配置文件

name: ai-development

channels:

- pytorch

- nvidia

- conda-forge

- defaults

dependencies:

- python=3.9

- numpy=1.24.3

- pandas=2.0.3

- scikit-learn=1.3.0

- matplotlib=3.7.1

- jupyter=1.0.0

- pytorch=2.0.1

- torchvision=0.15.2

- torchaudio=2.0.2

- pytorch-cuda=11.8

- pip

- pip:

- tensorflow==2.12.0

- transformers==4.30.0

- datasets==2.13.0

这份配置文件就像是一份精确的食谱,任何人都可以根据它重现相同的环境。

性能优化与监控

一个好的AI开发环境不仅要能运行,还要能高效运行。这就像是调试一台精密的机器,每个参数都需要仔细调整。

# GPU监控脚本

import psutil

import GPUtil

def monitor_system():

"""监控系统资源使用情况"""

# CPU使用率

cpu_percent = psutil.cpu_percent(interval=1)

print(f"CPU使用率: {cpu_percent}%")

# 内存使用率

memory = psutil.virtual_memory()

print(f"内存使用率: {memory.percent}%")

# GPU使用率

gpus = GPUtil.getGPUs()

for gpu in gpus:

print(f"GPU {gpu.id}: {gpu.name}")

print(f" GPU使用率: {gpu.load*100:.1f}%")

print(f" 显存使用: {gpu.memoryUsed}/{gpu.memoryTotal} MB")

# 定期监控

import time

while True:

monitor_system()

print("-" * 50)

time.sleep(10)

团队协作与环境同步

在团队项目中,确保每个人都有相同的开发环境是至关重要的。这就像是让乐队中的每个乐手都使用相同的乐谱,这样才能演奏出和谐的音乐。

# 项目结构示例

ai-project/

├── environment.yml # conda环境配置

├── requirements.txt # pip依赖列表

├── setup.py # 项目安装脚本

├── README.md # 项目说明文档

├── docs/ # 详细文档

│ ├── installation.md # 安装指南

│ └── troubleshooting.md # 问题排查

├── notebooks/ # Jupyter笔记本

├── src/ # 源代码

└── tests/ # 测试代码

# 团队成员快速设置环境

git clone project-repo

cd ai-project

conda env create -f environment.yml

conda activate ai-development

pip install -e . # 开发模式安装项目

未来展望:持续学习和环境演进

AI开发环境的搭建不是一次性的任务,而是一个持续演进的过程。新的工具和框架不断涌现,硬件技术也在快速发展,这要求我们保持学习的心态。

从我个人的经验来看,每隔几个月回头审视一下自己的开发环境配置,往往会发现一些可以优化的地方。也许是某个新版本的库提供了更好的性能,也许是某个新工具能够简化工作流程。

正如《道德经》所说:"知其雄,守其雌,为天下溪。"在技术的世界里,我们需要既要了解最新的技术趋势,也要坚持那些经过时间考验的基本原则。

搭建AI开发环境就像是为一场伟大的冒险做准备。当你的工具箱准备就绪,当你的环境配置完善,当你对每个组件都了如指掌时,你就能够专注于真正重要的事情:创造能够改变世界的AI应用。

这个过程可能充满挑战,可能让你感到困惑,但请记住,每一个成功的AI开发者都曾经历过这样的过程。当你最终看到自己的第一个深度学习模型成功运行在GPU上时,那种成就感将让你觉得所有的努力都是值得的。