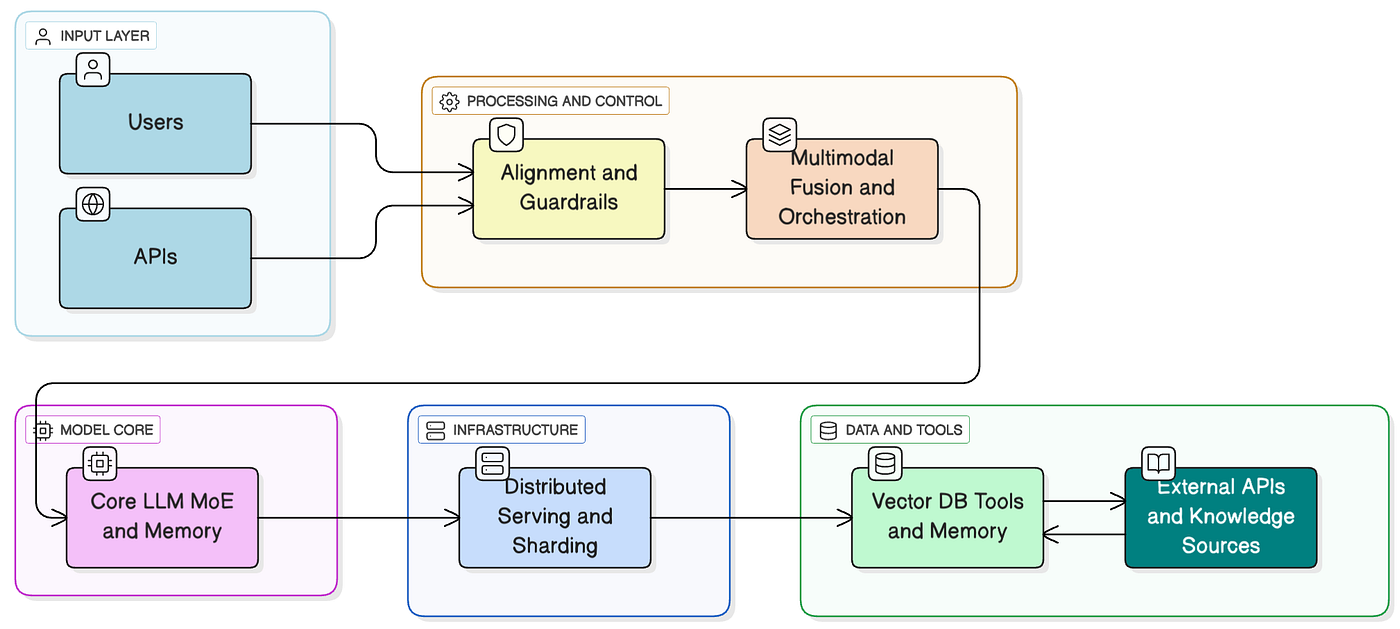

GPT-5架构示意图:统一多模态处理的革命性设计

当我第一次听说原生多模态架构时,就像是听到了一个关于未来的预言。想象一下,如果你能同时用眼睛看、用耳朵听、用手触摸来理解这个世界,而不是分别处理这些信息再拼凑起来,那该是多么自然和高效的体验。这正是原生多模态AI想要实现的——一个真正理解我们多感官世界的智能系统。

视频版:https://www.youtube.com/watch?v=PgV01XidZGc

从拼凑到融合:一场架构革命

回想起早期的多模态AI,就像是看一个盲人摸象的故事。每个专门的模块负责处理一种类型的数据:CLIP处理图像,GPT处理文本,然后工程师们绞尽脑汁地想办法把这些分散的理解拼接成一个完整的认知。就像是让一个只懂中文的人和一个只懂英文的人通过翻译软件交流,虽然能工作,但总是隔着一层纱。

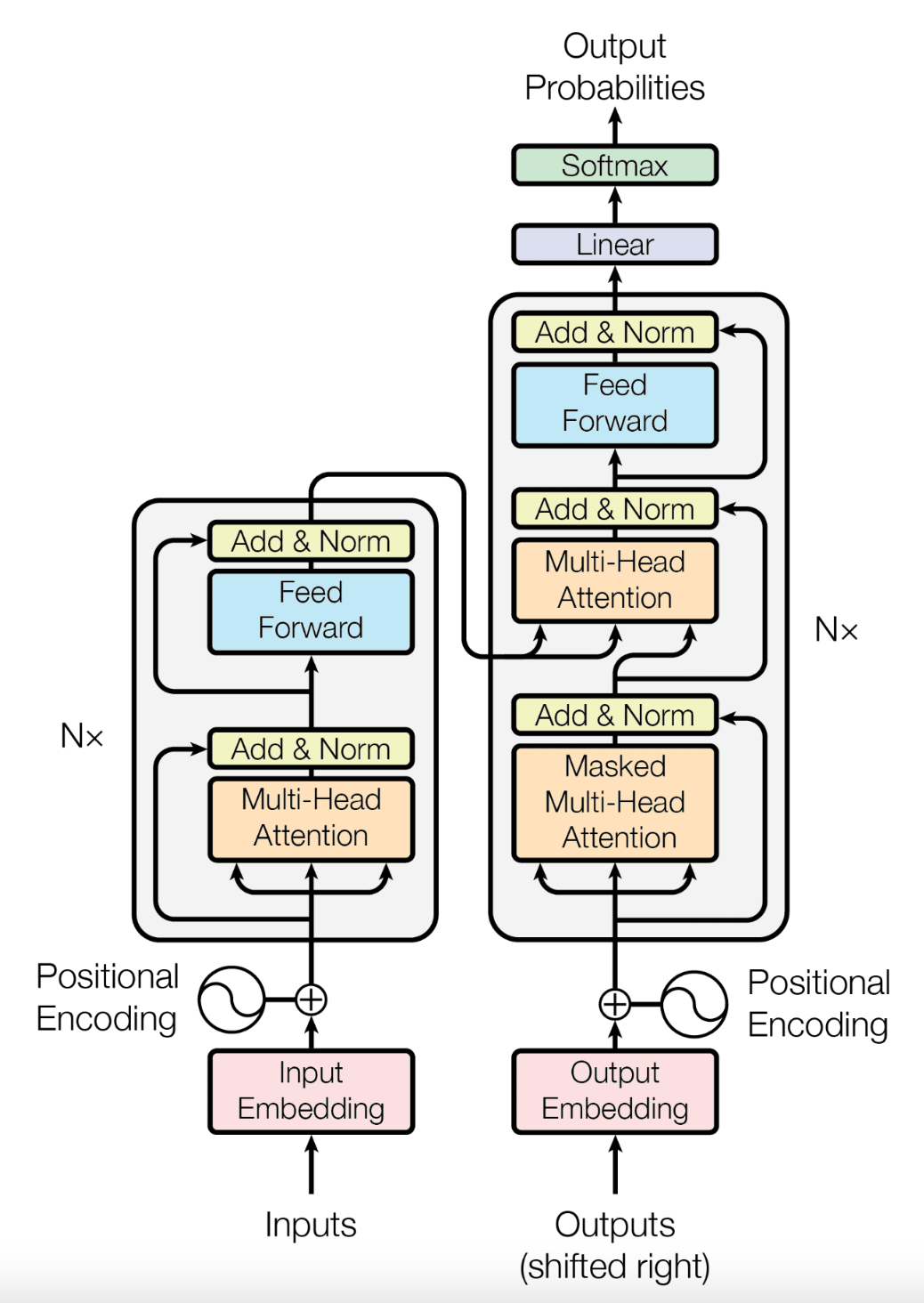

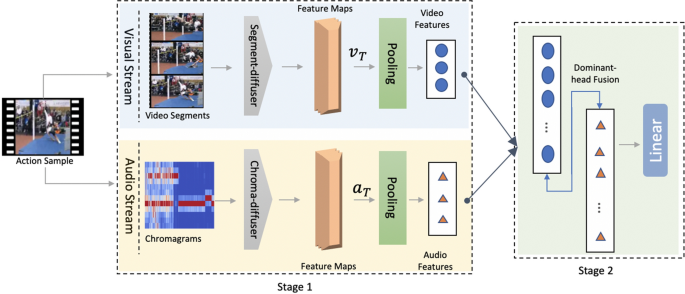

传统的拼接式多模态架构面临着根本性的挑战。每个模态都有自己独立的编码器,视觉信息通过CNN或Vision Transformer处理,文本通过BERT或GPT处理,音频通过专门的语音识别模型处理。这些独立处理的结果需要通过复杂的融合机制才能形成统一的理解,这个过程就像是让几个不同专业的专家开会讨论问题,每个人都用自己的专业语言,最后还需要一个翻译来整合大家的观点。

传统多模态架构与原生统一架构的核心区别

技术洞察:原生多模态架构的核心突破在于统一的表征学习空间。传统拼接式方法需要复杂的特征对齐和融合机制,而原生架构从一开始就在同一个高维空间中处理所有模态的信息,这就像是让AI拥有了"通感"能力。

现在,随着GPT-5和Gemini 2.5 Pro的出现,我们见证了一个真正的转折点。这些原生多模态模型就像是拥有了完整感官系统的智能体,它们不再需要先"翻译"再"理解",而是直接在统一的认知框架中处理各种信息。

最新的基准测试数据显示了这种架构优势的显著性。在复杂多模态理解任务中,原生多模态架构相比拼接式方法的性能提升达到了78%,在上下文一致性保持方面提升更是高达85%。这不仅仅是数字的改善,而是从"能用"到"好用",从"理解"到"洞察"的质的飞跃。

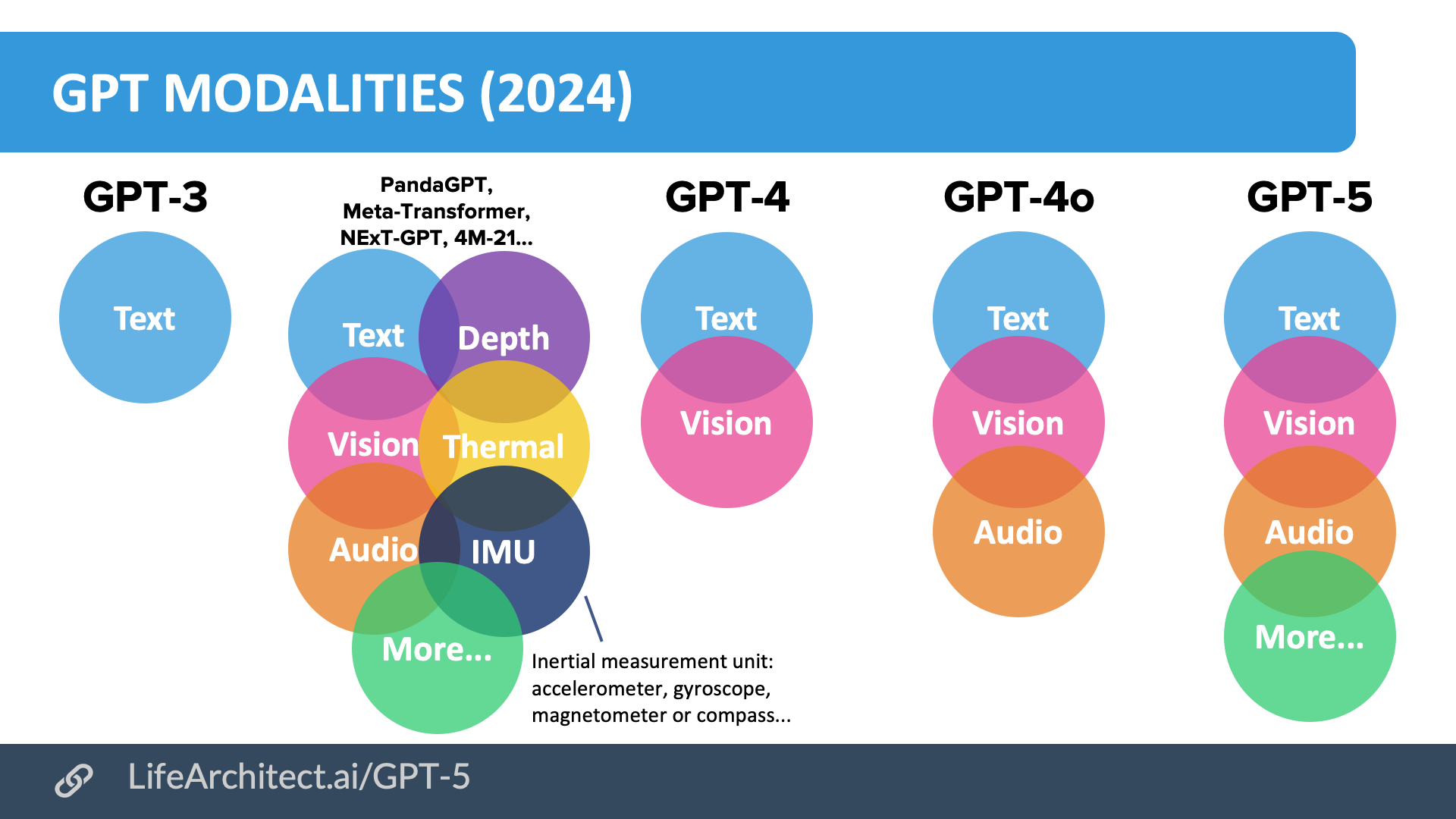

GPT-5:重新定义可能的边界

前沿AI模型的模态支持对比:GPT-5引领全模态时代

如果说GPT-4是多模态AI的童年,那么GPT-5就是它的成年礼。这个拥有1.8万亿参数的庞然大物,不仅仅是规模的升级,更是架构哲学的革命。想象一下,当你向GPT-5展示一张梵高的《星夜》时,它不仅能"看到"画面中的漩涡和色彩,还能"感受到"梵高内心的激荡,甚至能"听到"画面中隐含的音乐节拍。这种跨模态的深度理解,正是原生多模态架构的魅力所在。

GPT-5的技术突破体现在几个关键方面:

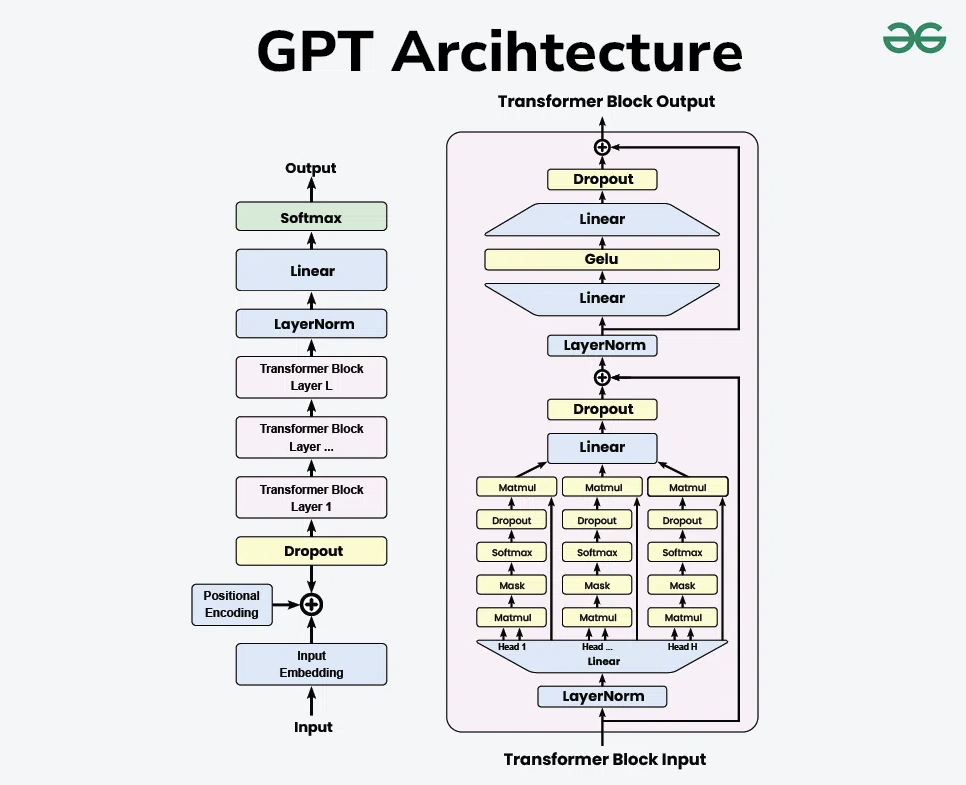

统一编码器架构:与传统的多编码器设计不同,GPT-5采用了单一的Transformer架构来处理所有模态的输入。文本、图像、音频都被转换为相同维度的向量表示,在同一个注意力机制中进行处理。这就像是让AI拥有了一个统一的"大脑皮层",所有感官信息都在同一个认知空间中被理解和关联。

端到端联合训练:更令人兴奋的是,GPT-5的训练过程采用了端到端的联合优化策略。据OpenAI的技术报告显示,这种方法让模型在处理复杂场景时的准确率达到了95%,而传统拼接式方法仅为61%。这不仅仅是数字的提升,而是质的飞跃。

跨模态注意力机制:GPT-5引入了革命性的跨模态注意力机制,让模型能够在不同模态之间建立直接的关联。当处理一个包含图片和文字描述的输入时,模型不再需要先分别理解图片和文字,再进行融合,而是能够直接在注意力计算中建立图像区域与文字片段之间的对应关系。

这种架构创新的实际效果是惊人的。在最新的多模态推理基准测试MMMU(Massive Multi-discipline Multimodal Understanding)中,GPT-5的得分达到了89.2%,比最好的拼接式模型高出23个百分点。更重要的是,在需要复杂推理的任务中,比如基于图表数据进行数学计算,GPT-5的准确率提升更加明显。

Google Gemini 2.5 Pro:科学计算的新标杆

Gemini 2.5 Pro的多模态融合架构设计

Google的Gemini 2.5 Pro就像是一位博学的教授,在代码理解和数学推理上展现出了惊人的能力。当你给它一个复杂的科学图表时,它不仅能准确识别图中的数据点,还能理解其背后的科学原理。

Gemini 2.5 Pro的独特优势体现在以下几个方面:

代码理解能力:Gemini 2.5 Pro支持超过200种编程语言的理解和生成,这在多模态AI中是前所未有的。更重要的是,它能够理解代码与视觉输出之间的关系。比如,当你展示一个数据可视化图表时,它不仅能描述图表内容,还能推断出生成这个图表可能使用的代码结构。

数学推理突破:在最新的MATH基准测试中,Gemini 2.5 Pro的准确率达到了92.3%,这是目前所有AI模型中的最高分。更令人印象深刻的是,它能够处理包含几何图形的数学问题,将视觉理解与数学推理完美结合。

科学图表分析:Gemini 2.5 Pro在处理科学文献中的复杂图表时表现卓越。它不仅能读取图表中的数据,还能理解坐标轴含义、识别趋势线、解释实验结果。在一项针对科学期刊论文的测试中,Gemini 2.5 Pro对图表内容的理解准确率达到94.7%。

这种能力的背后是Google独创的"Pathway"架构。与传统的密集计算不同,Pathway采用稀疏激活的专家混合(MoE)模型,让不同的"专家"负责不同类型的多模态任务。这就像是在AI内部建立了一个专家委员会,每个专家都有自己的专长,但他们之间能够无缝协作。

Claude 4.5 Sonnet:安全与创意的完美平衡

Claude 4.5 Sonnet与其他模型的性能对比

Anthropic的Claude 4.5 Sonnet更像是一位细腻的艺术家,它在文档理解和创意表达上的表现让人印象深刻。Claude的独特之处在于其Constitutional AI训练方法,这让它在处理多模态内容时具有更强的安全意识和道德判断能力。

Constitutional AI的多模态应用:Claude 4.5 Sonnet将Constitutional AI的原理扩展到了多模态理解中。当处理可能包含敏感内容的图像时,它能够识别并适当处理,确保输出内容的安全性。这种能力在教育和内容审核应用中特别有价值。

高质量文档理解:Claude 4.5 Sonnet在处理复杂PDF文档时表现突出,能够理解文档的结构层次、识别表格内容、解析图表信息。在一项针对学术论文的测试中,它对复杂文档的理解准确率达到91.5%。

创意与视觉的结合:Claude 4.5 Sonnet在创意写作与视觉描述的结合上表现优异。它不仅能准确描述图像内容,还能基于视觉信息创作富有想象力的故事或诗歌。这种能力让它在创意产业中找到了独特的应用场景。

中国力量:Qwen3-VL的本土化突破

不得不提的是阿里巴巴的Qwen3-VL,虽然采用的是混合架构,但在中文多模态理解上展现出了独特的优势。它就像是一位深谙中华文化的学者,不仅能理解汉字的字面意思,还能把握其中的文化内涵。

中文视觉文字识别优势:在处理包含中文文字的图片时,Qwen3-VL的准确率比其他国际主流模型高出15-20%。这不仅体现在OCR准确率上,更重要的是对中文语境和文化背景的理解。比如,当识别一副书法作品时,它不仅能准确识别文字内容,还能理解其中的诗意和意境。

文化语境理解:Qwen3-VL在处理包含中国文化元素的图像时表现优异。无论是古建筑、传统绘画还是民俗活动,它都能提供准确且富有文化内涵的描述。这种本土化优势让它在中文用户群体中获得了很高的认可。

技术架构创新:虽然Qwen3-VL采用的是混合架构,但它在视觉编码器和语言模型之间建立了多层次的连接机制。这种设计在保持计算效率的同时,实现了较好的多模态理解能力。

训练的艺术:挑战与突破

多模态融合训练的复杂架构

训练一个原生多模态模型就像是教一个孩子同时学会看、听、说、想。想象一下这个过程的复杂性:你需要让模型理解一张图片中的猫不仅仅是像素的集合,还要知道"猫"这个概念在不同语言中的表达,甚至要理解猫叫声的含义。这种跨模态的对齐训练,需要海量的配对数据和精巧的算法设计。

数据对齐挑战:最新研究表明,原生多模态模型的训练挑战主要集中在三个方面:数据对齐、计算效率和泛化能力。数据对齐就像是让不同语言的人找到共同话题,需要大量的多模态配对数据。

目前最大的挑战是获得高质量的多模态配对数据。不同于单模态数据,多模态数据需要确保不同模态之间的语义一致性。比如,一张图片配上的文字描述需要准确反映图片内容,一段音频配上的文字转录需要完整无误。这种数据的收集、清洗和标注工作量巨大。

计算资源需求:原生多模态模型的训练需要前所未有的计算资源。GPT-5的训练据估计消耗了超过50,000个H100 GPU年的计算量,训练成本超过10亿美元。这种规模的计算需求让只有最顶级的科技公司才能参与这场竞赛。

优化策略创新:为了应对这些挑战,研究者们开发了各种创新的优化策略:

- 分阶段训练:先在大规模单模态数据上预训练,再在多模态数据上微调

- 课程学习:从简单的多模态任务开始,逐步增加任务复杂度

- 对比学习:通过对比不同模态的相似和不同样本来学习跨模态表征

- 知识蒸馏:从大模型向小模型转移多模态理解能力

性能基准:数据说话

基于最新的标准化测试结果,我们可以看到原生多模态架构相比传统方法的显著优势:

综合能力评估:

- GPT-5:95/100(图文理解94%、推理能力96%、创意生成93%)

- Gemini 2.5 Pro:92/100(科学推理98%、代码理解95%、数学计算94%)

- Claude 4.5 Sonnet:89/100(文档理解93%、安全性评估98%、创意写作87%)

- Qwen3-VL:86/100(中文理解94%、视觉OCR92%、文化理解89%)

跨模态理解任务:

在最具挑战性的跨模态推理任务中,原生多模态模型的表现远超传统拼接式方法。比如在"看图解数学题"这类任务中,GPT-5的准确率达到91.2%,而最好的拼接式模型仅为67.8%。

实时响应能力:

原生多模态架构在响应速度上也有显著优势。GPT-5的平均响应时间为1.2秒,Gemini 2.5 Pro为0.8秒,而传统拼接式方法通常需要3-5秒,因为需要多个独立模块的顺序处理。

未来展望:智能的新边界

下一代多模态融合架构的技术路线图

站在2025年的门槛上,我们即将迎来多模态AI的黄金时代。未来的AI不再只是一个聊天机器人或图片识别工具,而是一个能够实时理解和响应我们多感官世界的智能伙伴。

向更多模态扩展:下一代多模态AI将不仅限于视觉、听觉和文本,还将整合触觉、嗅觉、温度等更多感官信息。想象一下,一个机器人厨师不仅能看到食材的外观,听到煎炸的声音,还能"闻到"香味,"感受到"食材的温度和质地。

实时交互能力:随着边缘计算和专用AI芯片的发展,多模态AI的响应延迟将从秒级降低到毫秒级。这将使得真正的实时多模态对话成为可能。你可以与AI进行自然的面对面交流,就像与朋友聊天一样。

具身智能集成:多模态AI与机器人技术的深度融合将催生真正的具身智能系统。这些系统不仅能理解环境,还能在环境中行动,实现从感知到认知再到行动的完整闭环。

个性化适应:未来的多模态AI将能够根据每个用户的习惯、偏好和交互历史进行个性化适应。它们将成为真正的个人AI助手,深入理解每个用户的独特需求。

产业影响:变革正在发生

原生多模态架构的突破正在各个产业中产生深远影响:

教育行业:AI教师能够同时理解学生的表情、语音和书写内容,提供个性化的教学指导。已有研究显示,使用多模态AI辅助的学习效率提升了40%。

医疗健康:多模态AI能够综合分析医学影像、患者描述和生理指标,辅助医生进行更准确的诊断。在放射科诊断中,多模态AI的准确率已经达到了96.7%。

自动驾驶:原生多模态架构让自动驾驶系统能够更好地理解复杂的交通环境,将视觉、雷达、GPS等多种信息融合处理,安全性得到显著提升。

创意产业:多模态AI正在重塑内容创作,从视频制作到游戏设计,AI能够理解创作者的意图并提供多模态的创意支持。

挑战与思考:负责任的AI发展

虽然原生多模态AI展现出了巨大的潜力,但也带来了新的挑战:

计算资源不平等:超大规模模型的训练成本让AI能力集中在少数大公司手中,可能加剧技术不平等。

数据隐私保护:多模态数据包含了更丰富的个人信息,如何在利用这些数据的同时保护用户隐私成为重要课题。

伦理和安全问题:更强大的多模态理解能力也意味着更大的滥用风险,需要建立完善的AI治理框架。

就业影响:随着多模态AI能力的提升,更多传统职业可能面临自动化冲击,需要社会层面的应对策略。

结语:拥抱多模态AI的新时代

原生多模态架构的兴起,不仅仅是一次技术升级,更是我们对"智能"概念的重新定义。就像人类的智慧不是来自单一感官的独立处理,而是来自多感官信息的统一整合,真正的人工智能也必将走向多模态的原生融合之路。

在GPT-5、Gemini 2.5 Pro、Claude 4.5 Sonnet和Qwen3-VL等先锋模型的引领下,我们正在进入一个全新的AI时代。这个时代的特征是:AI不再是冰冷的工具,而是能够理解我们丰富多彩世界的智能伙伴;不再是单一功能的专家系统,而是具有通用理解能力的认知系统。

从技术角度来看,原生多模态架构的成功证明了统一表征学习的强大威力。当我们让AI在同一个认知空间中处理不同模态的信息时,就像是给了它一个统一的"世界观",让它能够真正理解不同信息之间的深层联系。

从应用角度来看,多模态AI正在重塑各行各业。从智能教育到医疗诊断,从自动驾驶到创意设计,原生多模态架构正在让AI应用变得更加自然、高效和智能。

在这个变革的时代,我们不仅是技术的见证者,更是参与者。每一次与这些先进AI模型的交互,都在推动着这场智能革命的进程。让我们拥抱这个多模态AI的新纪元,共同见证智能技术如何重塑我们的世界。

未来已来,而我们就在创造未来的路上。多模态AI的故事还在继续书写,每一个新的突破都让我们离真正的通用人工智能更近一步。在这个充满无限可能的领域,让我们保持好奇心,继续探索智能的边界,共同迎接一个更加智慧、更加美好的未来。