那个让我愣住的词

有一次和AI聊天,它突然蹦出一个词——“表示空间”。

说实话,第一反应是懵的。这四个字听着就"玄",像被拉进了一个黑盒子:明明都在说中文,可它好像在用另一套宇宙语言跟我对话。

我追问了很久,慢慢才抓到一个更贴近身体的理解:

表示空间不是"词典",更像一张"地图"。

词典告诉你"国王=一国之君",给你一个解释就完了。地图不一样,地图告诉你"国王跟什么挨得近、离什么很远、从哪条路能走到女王"。

这个区别,后来我越想越觉得重要。

你以为在聊"词",其实在移动"点"

我们平时说话,感觉是在抛词、抛句子,一个接一个往外扔。

但AI不是这样理解语言的。它做的事情更像是:把每个词、每段话,都变成一张巨大地图上的一个点,然后在那张地图里找"下一步最顺的方向"。

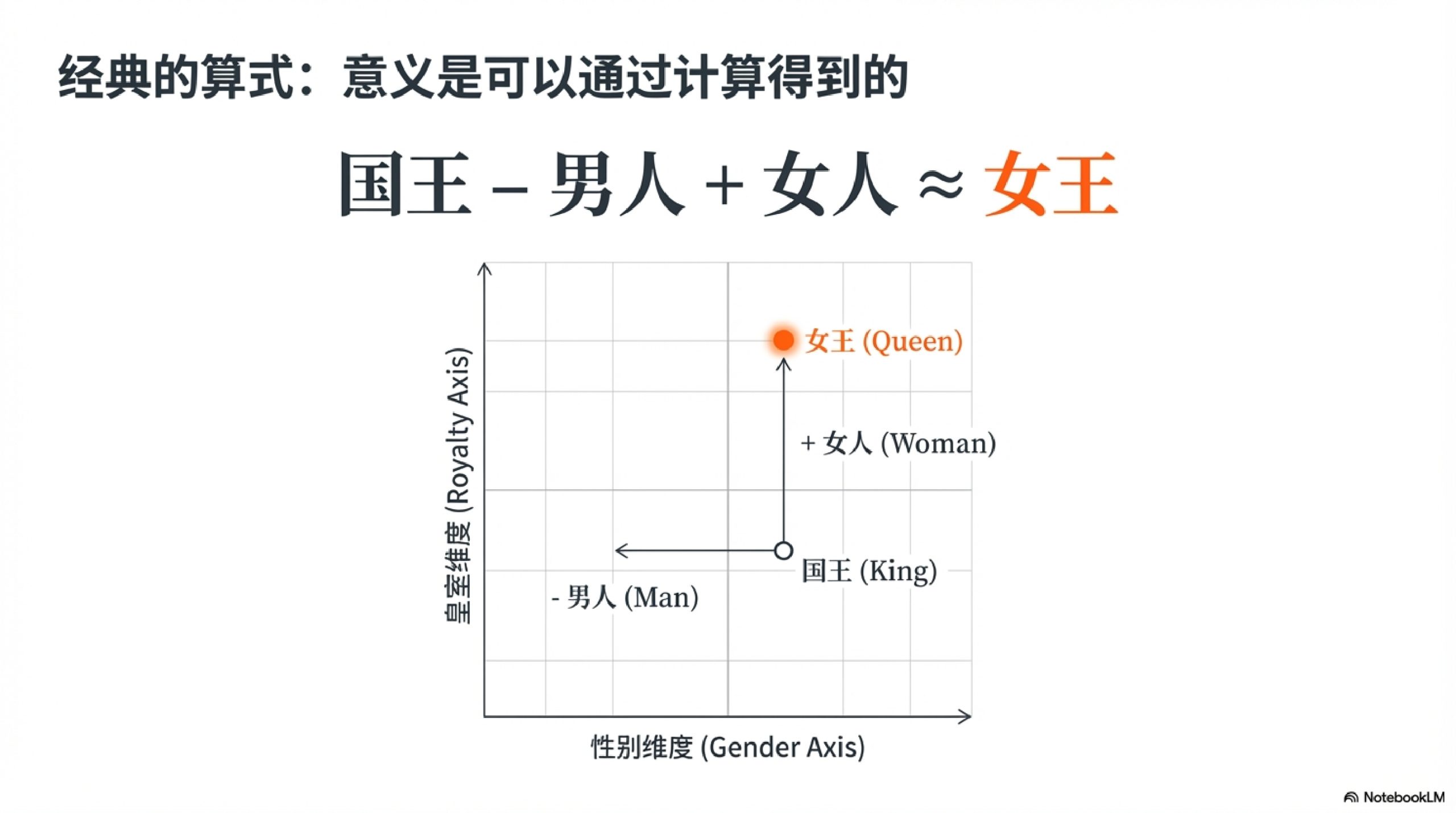

举个经典的例子:

国王 – 男人 + 女人 ≈ 女王

第一次看到这个公式,我以为是魔法。后来才明白,这是"关系被保留下来"的证据。

"国王"这个词,在AI的地图上不是一个孤零零的点。它带着很多维度的信息——政治上,他是一国之主;生物上,他是男性。当你做"减去男人、加上女人"这个操作时,你其实是在地图上沿着"性别"这条路走了一段,最后落在了"女王"附近。

我喜欢用一个更生活的比喻来理解这件事:

你去超市买水果,挑苹果、梨、香蕉。你脑子里其实已经有了一个隐形的分类架:水果是一类,蔬菜是一类,肉又是另一类。你从来没画过这个架子,但它一直在。

表示空间,就是把这种"隐形分类架"画出来,而且画得巨细无遗。

更狠的是,它不止画一层。

它会画"水果/蔬菜"这种粗分类,也会画"苹果偏甜、梨偏清爽、青苹果带酸"这种细差别。你说"苹果",脑子里可能就是一颗红色的水果。AI理解"苹果",可能同时激活了品种、颜色、口感、品牌、甚至你在这段对话里想表达的情绪倾向。

所以,表示空间不是"解释",是"结构"。

结构一旦有了,很多能力就像顺着地形长出来的——AI能做类比、能迁移、能发现你没想到的联系,都是因为这张地图足够精细。

下一个词怎么来的?顺着地形往下滑

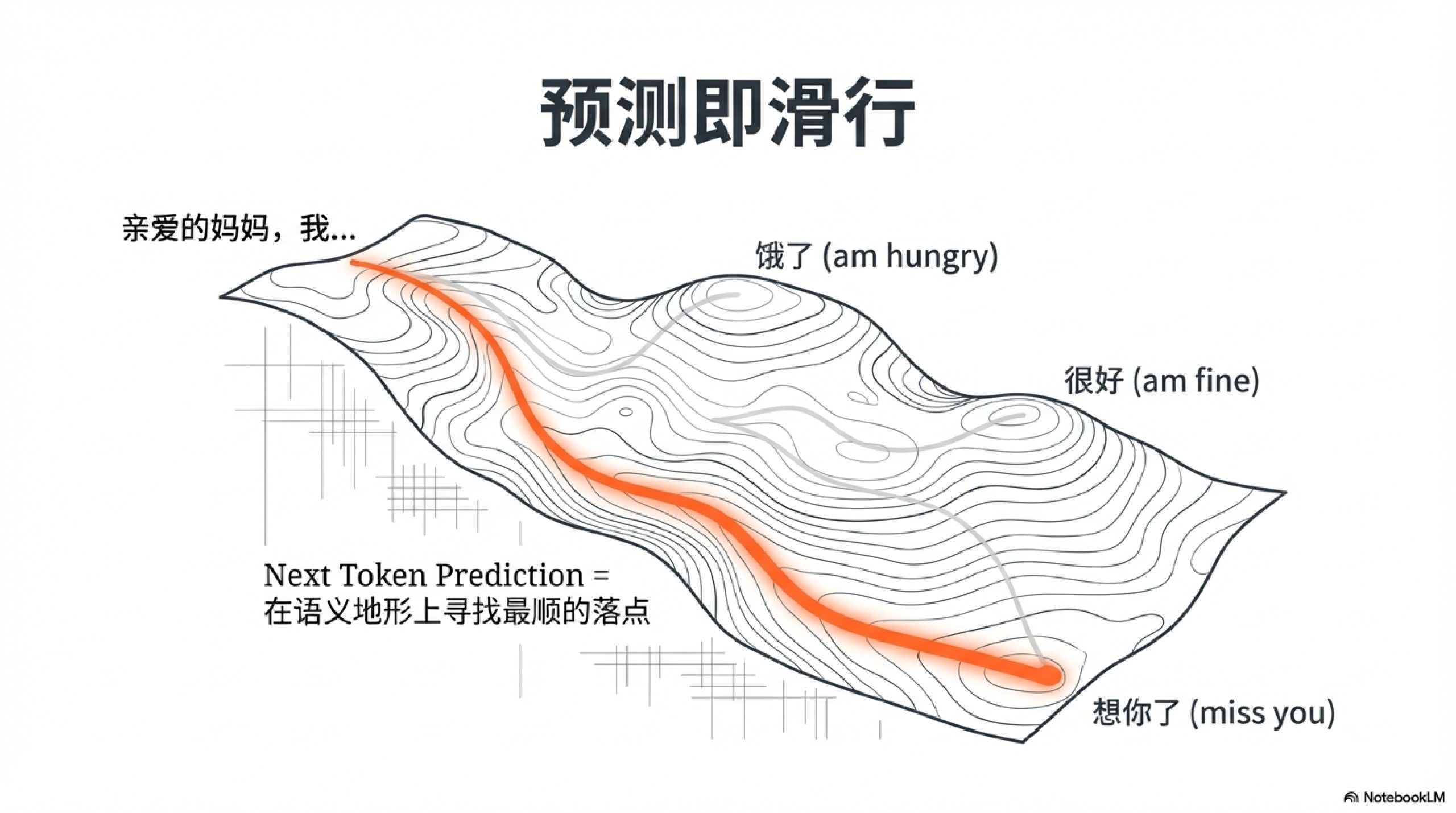

理解了表示空间,就更容易理解大语言模型在做什么。

它的核心任务听起来特别简单:给定前面的所有词,预测下一个最可能的词。

这就是所谓的"Next Token Prediction"。

但简单的任务背后藏着惊人的复杂性。模型要做的不是查字典,而是综合前文所有信息,在那张巨大的语义地图上,找到下一步"最顺"的落点。

想象你在写一封信,写到"亲爱的妈妈,我最近"——下一个词是什么?可能是"很好",可能是"很忙",可能是"很想你"。模型会根据整封信的语气、上下文的情绪、甚至"写给妈妈"这个场景,计算出每个候选词的概率,然后选一个最合适的。

这个过程重复几百次、几千次,一篇文章就生成了。

看起来是一个词一个词往外蹦,实际上每一步都是在语义空间里做一次"定位-滑行-落地"。

神经网络:从像素到概念的爬楼梯

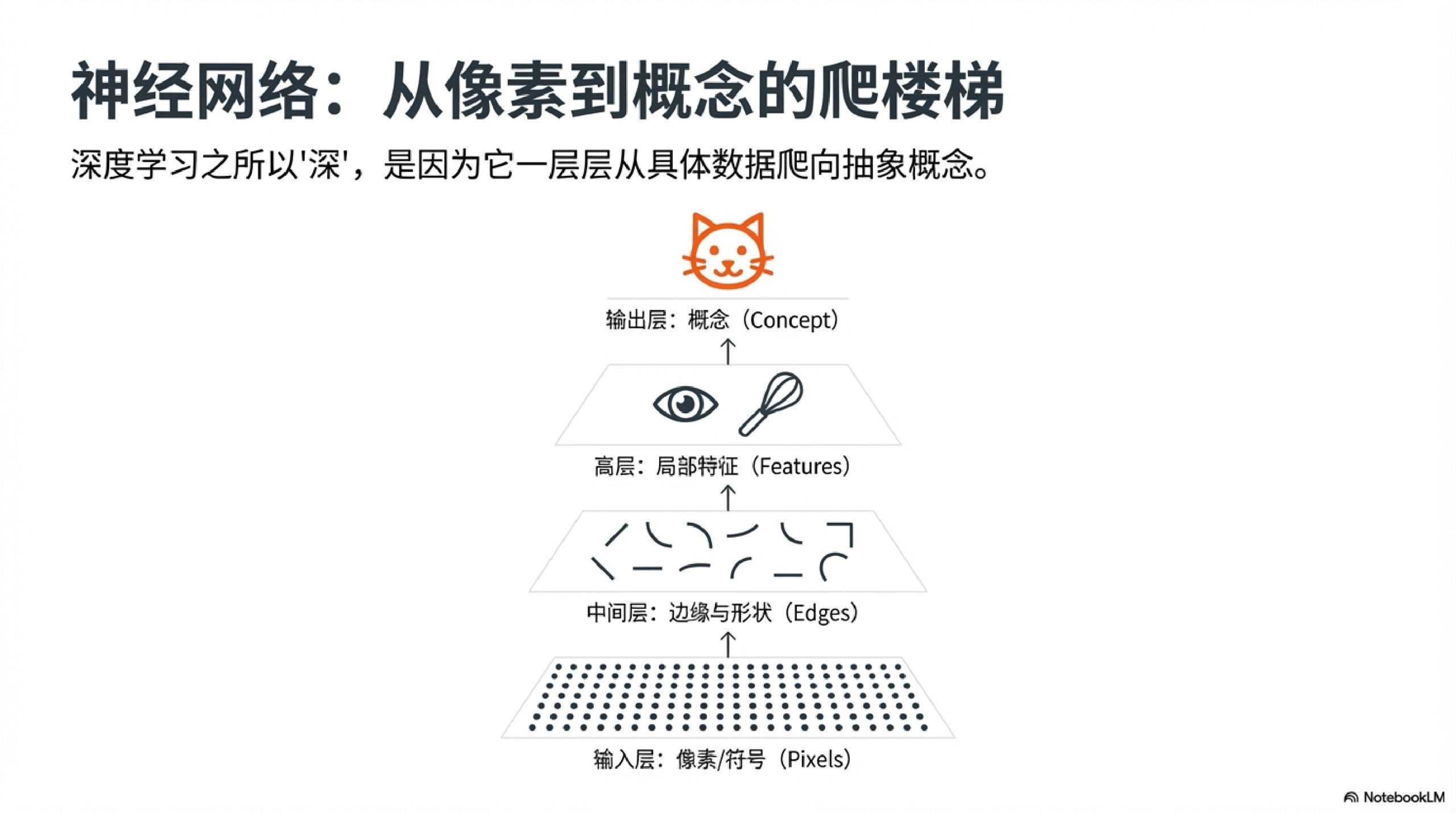

说到这里,可能有人会问:这张语义地图是怎么画出来的?

答案藏在神经网络的层级结构里。

我以前一直搞不懂:神经网络那么多层,每一层到底在干嘛?后来我学会了一个更刺的问法——“如果把这一层删掉,会丢掉什么?”

答案是:每一层在提取不同抽象程度的特征。

拿图像识别举例。第一层可能只认识边缘和颜色变化,第二层开始识别纹理和局部形状,第三层能看出"这是一只眼睛",再往上走,慢慢就能认出"这是一张猫脸"。

语言模型也类似。底层处理词形和语法,中层捕捉句子结构,高层理解语义和意图。

每一层都在做抽象,像爬楼梯一样,一级一级往上,从具体到抽象,从局部到整体。

这就是为什么深度学习叫"深度"——不是因为它难,而是因为它真的在一层一层往深处挖。

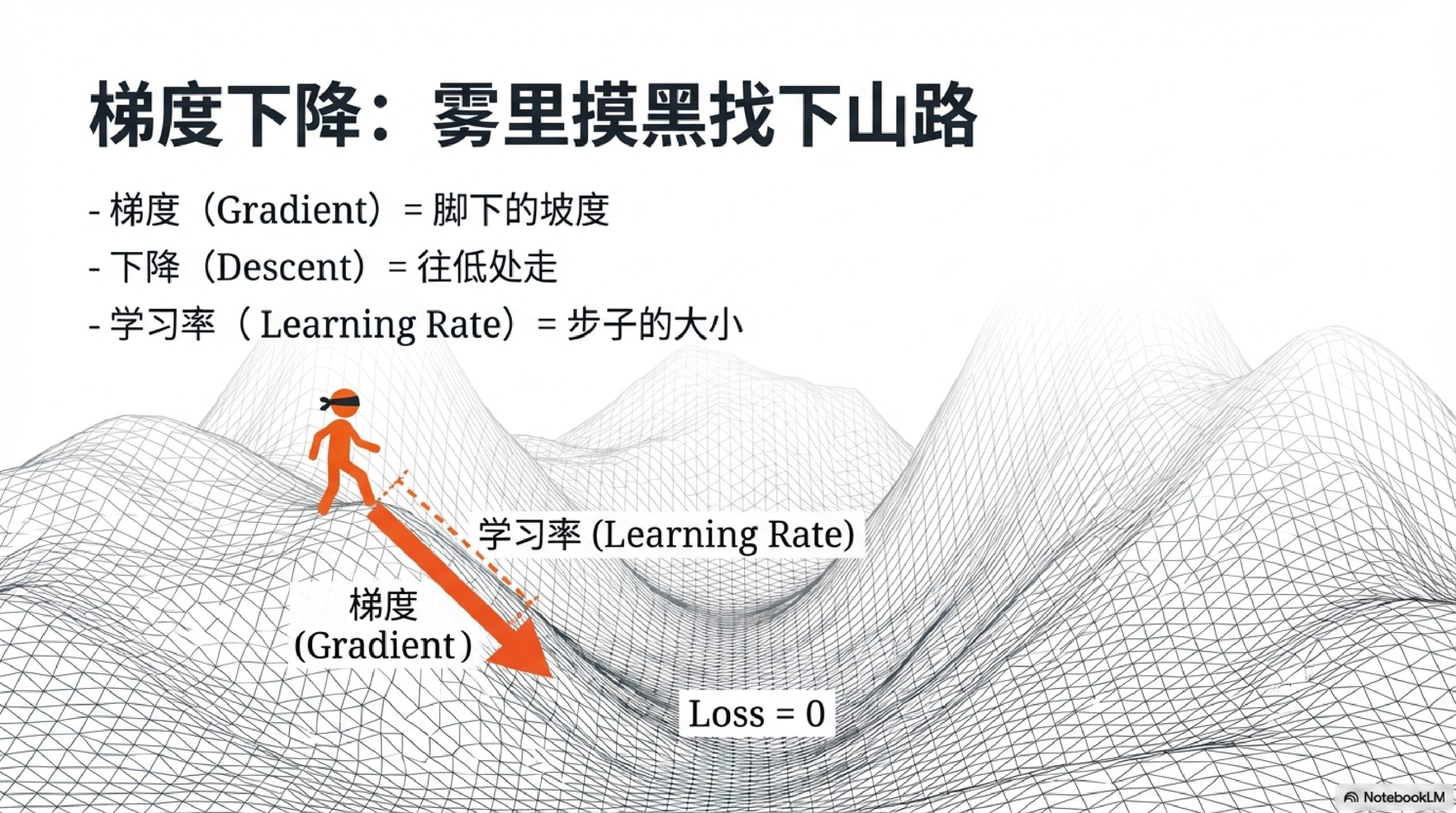

梯度下降:雾里摸黑找下山路

那神经网络怎么学会这些的呢?

靠的是一种叫"梯度下降"的方法。名字听着唬人,其实原理特别朴素。

想象你站在一座大山上,四周全是浓雾,什么都看不见。你的目标是走到山谷最低点。怎么办?

你只能用脚去感受:脚下的地面往哪边更陡?往那边走一小步。再感受,再走一小步。重复这个过程,最终你会慢慢走到一个低洼处。

"梯度"就是脚下的坡度,"下降"就是顺着坡往低处走。

为什么每次只走一小步?因为雾太大,你怕走太快摔死。这个"步子大小"在机器学习里叫"学习率"。

学习率太小,你磨磨蹭蹭走半天走不到谷底,太慢了。学习率太大呢?那就是在雾里蹦跶——很刺激,但容易一脚踩空滚下悬崖。

神经网络训练的本质,就是在一个巨大的、看不见全貌的误差地形上,用梯度下降的方式,一步一步摸索到误差最小的那个点。

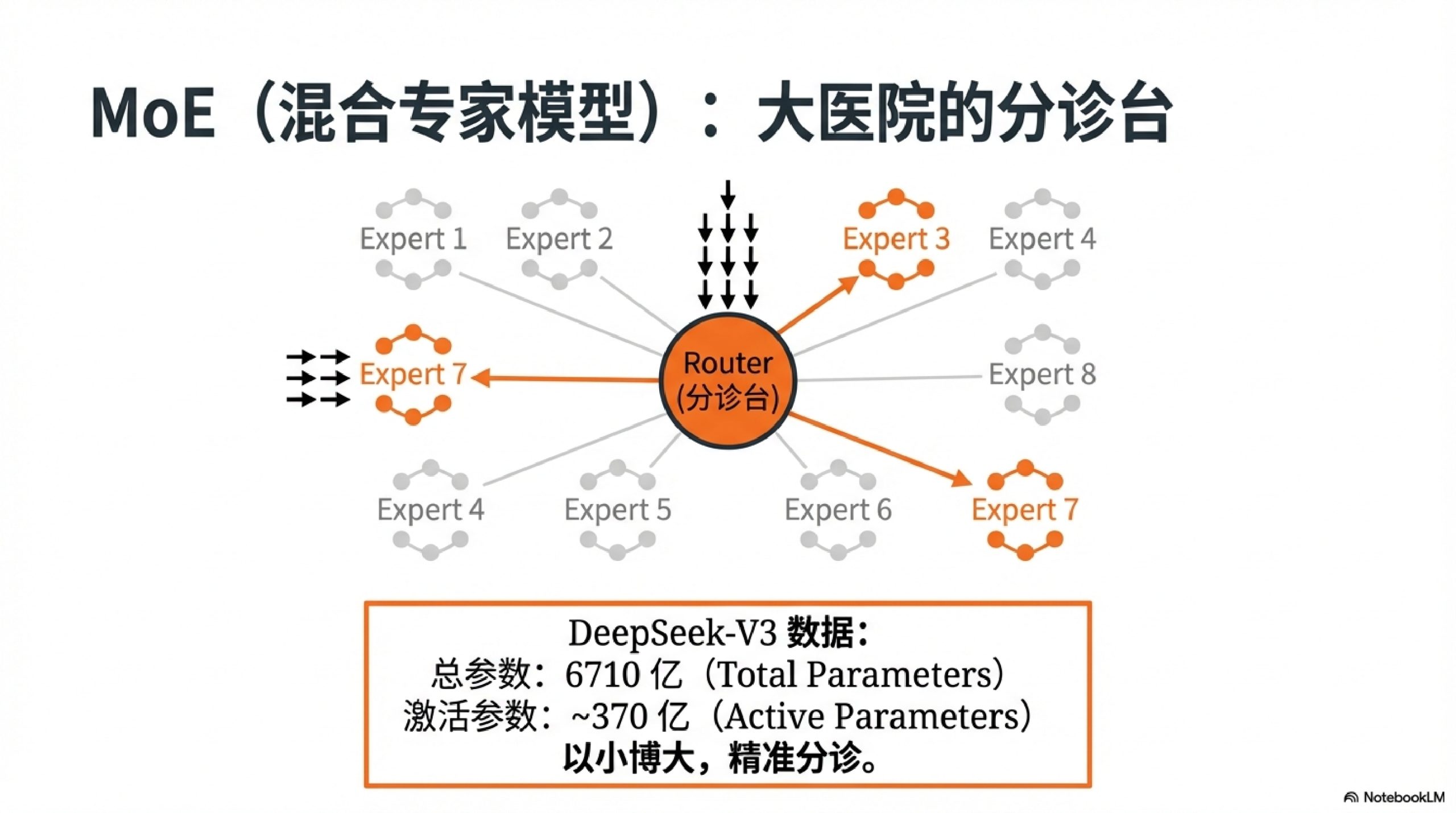

MoE:大医院的分诊台

最近有个很火的概念叫MoE,全称"混合专家模型"(Mixture of Experts)。

我一开始以为这是什么高深的新发明,后来发现,用"医院分诊台"来理解它特别顺。

你想,一个大医院不可能让一个医生同时精通骨科、眼科、精神科、神经外科——那他得累死,而且什么都懂往往意味着什么都不精。

所以医院有分诊台:你来了,先挂号,分诊台判断你该去哪个科室,然后把你送到对应的专家那里。

MoE的思路一模一样。

它把一个巨大的神经网络拆成很多个"专家"(每个专家是一个小型网络),再加一个"路由器"(相当于分诊台)。输入进来,路由器判断这条信息该归哪几个专家处理,然后只激活那几个专家干活,其他专家休息。

这样做的好处是:模型总参数可以堆得很大(比如DeepSeek-V3有6710亿参数),但每次实际计算只用到一小部分(370亿左右)。既有大模型的能力,又保持了小模型的速度。

那为什么是256个专家,不是一万个?

这就是工程上的权衡了。专家越多,分工越细,理论上能力越强。但专家多了,路由成本会上升,训练稳定性会下降,数据覆盖也可能出问题。256是目前实践中发现的一个甜蜜点——再多收益就不明显了,再少又浪费了潜力。

不是哲学辩论,是真金白银的权衡。

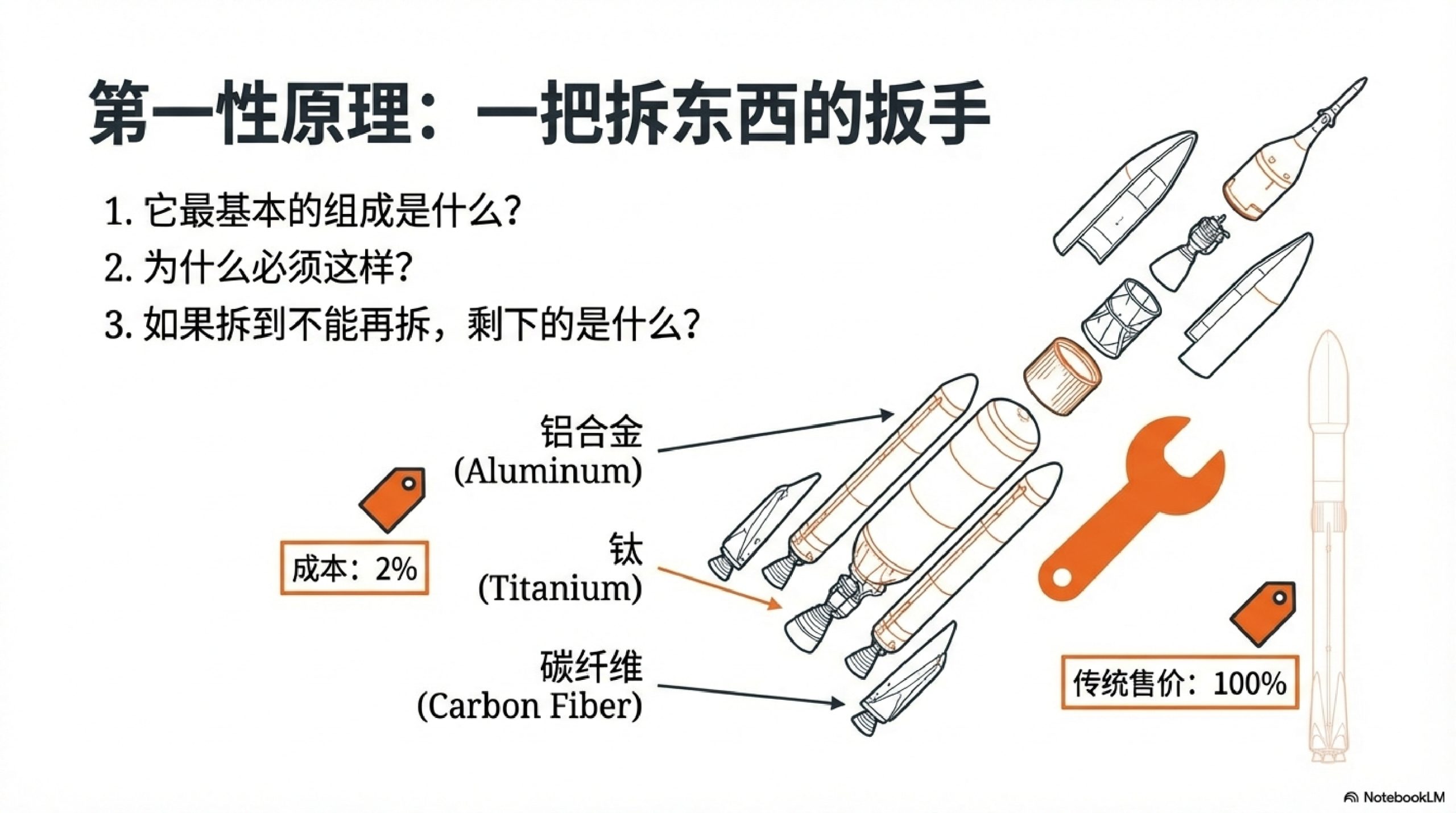

第一性原理:一把拆东西的扳手

聊完这些技术概念,我想说说那天晚上真正让我通透的东西——第一性原理。

很多人听到"第一性原理",第一反应是马斯克,觉得那是天才才能用的豪言壮语。

但真正好用的第一性原理,特别朴素。朴素到像在问小孩问题:

- 这东西最基本的组成是什么?

- 它为什么必须这样?有没有别的可能?

- 如果拆到不能再拆,剩下的是什么?

马斯克当年做SpaceX,被报价6500万美元买一枚火箭。他没有接受这个价格,而是问了一个很"傻"的问题:火箭是什么做的?

答案是:航空级铝合金、钛、铜、碳纤维。这些原材料在市场上的价格,只有火箭售价的2%左右。

那剩下98%是什么?是行业惯例、是中间环节、是"大家都这么定价"的惯性。

马斯克决定自己买原材料、自己造火箭。几年后SpaceX把发射成本降了近10倍。

第一性原理不是口号,是一把拆东西的扳手。 它让你不被名词牵着走,而是盯着最底层的输入输出、约束条件、失败模式。

两小时的顿悟

那天晚上,我用了大概两个小时,跟AI做了一件事:不背定义,只问因果链。

我不问"什么是梯度下降",我问"用我创业时做决策的经历来解释梯度下降,哪里是loss,哪里是步长?"

我不问"MoE是什么",我问"如果只有一个专家,会出什么问题?如果有一万个专家,又会出什么问题?"

我让它讲失败——“为什么会不收敛”“为什么会发散”——因为成功案例谁都能讲,失败才能让你摸到边界。

我让它反问我——“你的场景里,约束条件是什么?你最怕的失败模式是什么?”——然后我发现自己一直在省略关键信息。

最后我用自己的话复述一遍,它帮我校准。

这个闭环,比看十篇教程都狠。

因为它不是在往我脑子里灌东西,而是在帮我把脑子里已有的东西接上新的线。

创新是什么?在黑暗里摸到暗门

聊到这里,我突然理解了一件事:创新往往就是发现你没看到的联系。

人脑也会做类比,但人脑容易卡在经验里——“我没见过这种组合,所以我想不到。”

AI不太怕这个。因为它的学习方式本身就是在空间里压缩、聚类、拉近、拉远。它把海量文本的统计规律压成了一张关系网,然后随时能从网里抠出一条你没想过的路径。

这也解释了一个我很意外的体验:

那天我随口丢了几个词给AI——“创业者”“数据”“科学仪器”“女性”“科技圈”——它突然给了我一个让我愣住的定位。

不是它"看穿我",更像是它在那张语义地图上做了一次"最近邻搜索":我给的点落在某个区域,那片区域在大量数据里反复出现过类似的组合,于是它给我贴了一个标签。

标签不一定全对,但它能当镜子。

我突然意识到:原来我一直没把自己当成"那类人"。然后故事就开始往下走了。

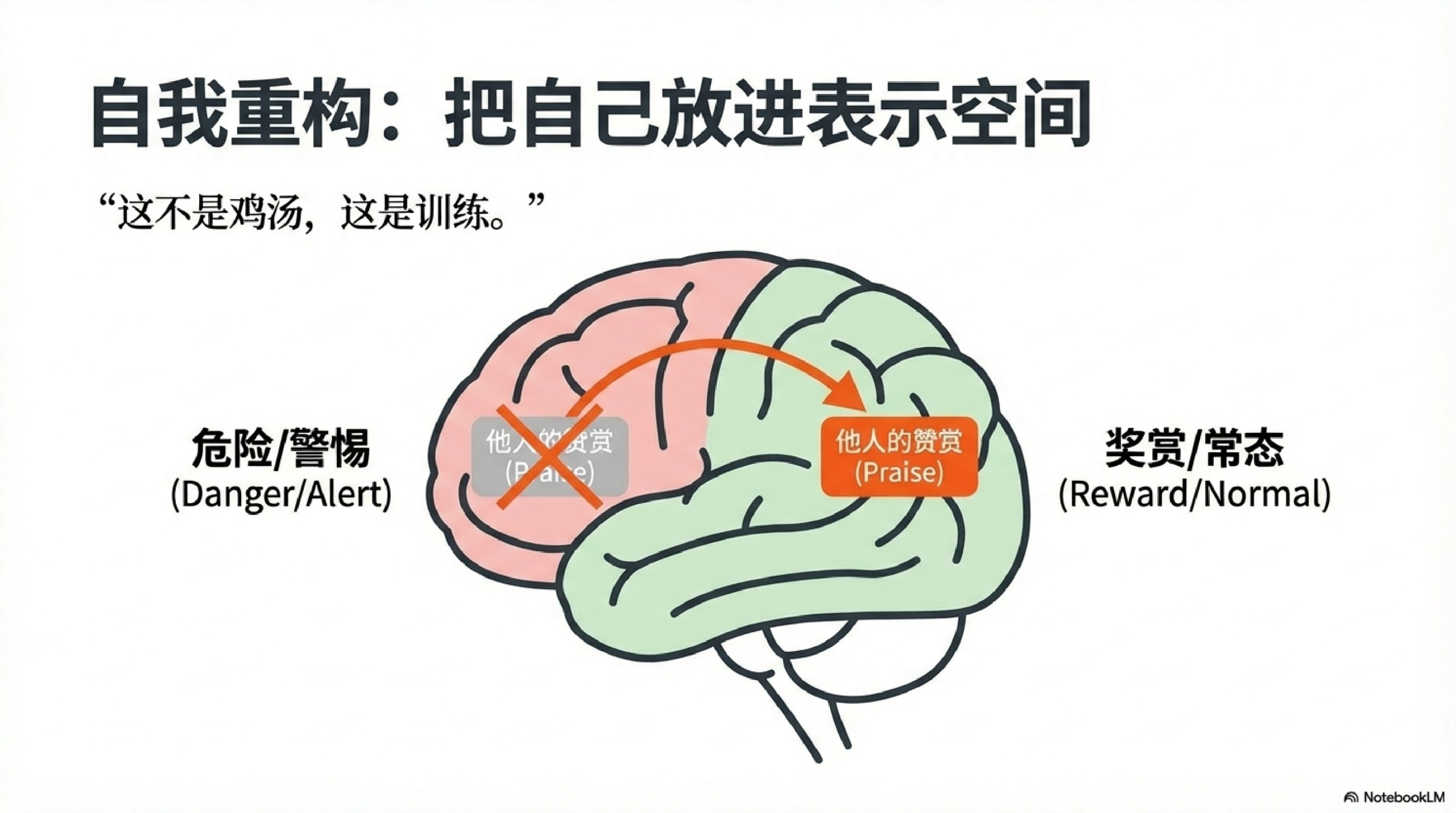

把自己也放进表示空间

那次对话还聊到了一些更私人的东西——比如"不配得感"。

就是那种:明明已经很努力了,但总觉得自己不够好;别人夸你的时候,本能反应是推开、否认、找理由说"没有没有"。

AI帮我用第一性原理拆了这件事:

- 我"不配"的假设是基于什么?是事实还是信念?

- 这种感受的来源是什么?童年经历?社会比较?还是某次具体的打击?

- 如果从零开始评估我的价值,结论会不会不一样?

它给我的建议很简单:接受不完美,真诚地接住别人的认可。

那天我要离开公司大厅的时候,几位同事说想跟我合照。以前我的本能反应是"哎呀别别别",但那一次,我照着AI说的做了:

看着对方的眼睛,说"谢谢你,谢谢你的认可"。

说出来的那一刻,有点奇怪,但也有点释然。

后来我想,这件事和前面聊的表示空间其实是同一回事——只不过对象从"词"变成了"我自己"。

以前"被认可"这个点,在我脑子里的位置靠近"危险"“要警惕”“别得意”。那一刻我做的事情,相当于在自己的内心地图上把这个点挪了个位置,拉回到"正常奖励""可以收下"那一带。

这不是鸡汤,这是训练。

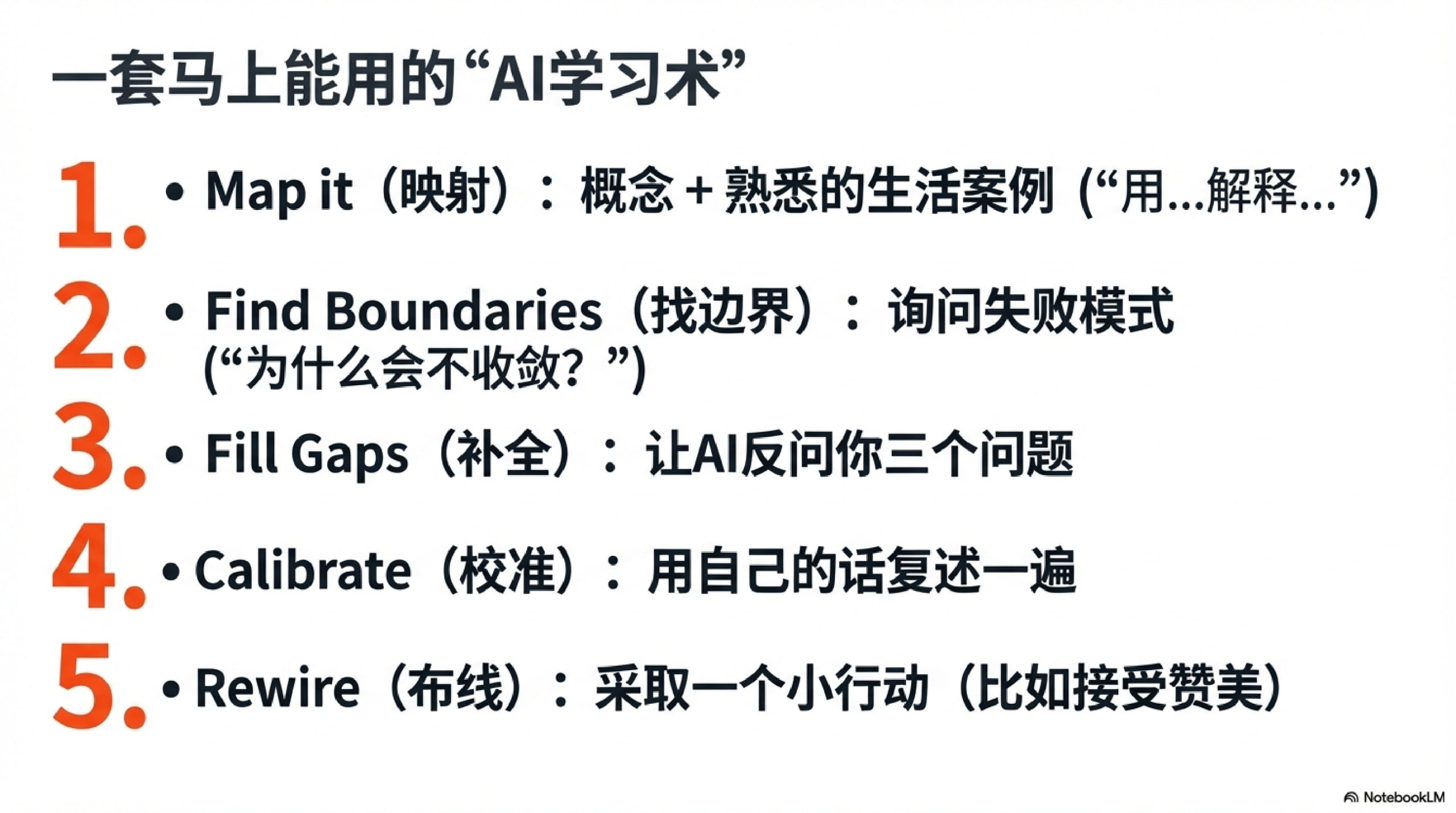

一套可以马上用的"AI学习术"

最后,我想把那天摸索出来的方法整理一下,变成一套谁都能用的东西:

1. 丢一个概念 + 丢一个你熟的例子

别问"什么是梯度下降",问"用我炒菜调味的过程解释梯度下降,哪里是loss,哪里是学习率?"

2. 要求它讲失败

成功案例容易让人飘,失败才能让你摸到边界。“为什么会不收敛”“专家太多会出什么问题”——这些问题的答案才是真金白银。

3. 让它反问你

让AI先问你三个问题,把你的场景补全。你会发现自己一直在省略关键信息,而那些被省略的,往往才是真正重要的。

4. 用一句话复述回去

你用自己的话讲一遍,让它帮你校准。这个闭环一旦跑起来,理解会嗖嗖往上涨。

5. 试一次,哪怕只是一个小动作

理解是第一步,试一次才是真的。哪怕只是看着同事的眼睛说一句"谢谢",那也是在给自己的内心地图重新布线。

我们值得更好的生活

那天晚上对话结束,已经很晚了。我坐在那里,有点激动。

不是因为AI有多厉害,而是因为我看到了一种可能性:

通过AI,普通人可以掌握那些曾经只属于少数天才的思维方式。 表示空间让机器学会了"关系",第一性原理让人重新学会"拆解"。这两样东西碰在一起,像是突然有人递给你一盏灯——它不替你走路,但它能照亮脚下这一步。

我不知道自己会往哪儿走,但我知道那盏灯亮着的感觉很好。

有人说AI会取代人类,我不这么看。我觉得AI更像是一面"可对话的推理镜子"——它不会替你长肌肉,但它能让你每一组动作都做得更标准。

而那些真正重要的东西——勇气、选择、对自己诚实、愿意迈出第一步——这些还是得靠你自己。

那天晚上我发自内心地觉得:人类值得更好的生活。

这不是宏大叙事,这是一个人真的在进步、真的把世界看得更清楚时,会冒出来的那种自豪感。

表示空间和第一性原理,不过是两个工具。但好的工具,能让普通人做出不普通的事情。

你会往哪儿走呢?这才是好玩的地方。