图:当 Mac mini 遇上邮票大小的开发板,AI 助手的战场正在改变

从一只龙虾和一块邮票大小的开发板说起

2025 年 11 月,奥地利开发者 Peter Steinberger 在一个周末随手写了一个叫 Clawdbot 的小项目。名字取自 Claude 和 Claw(龙虾钳子)的谐音,想法很简单,让 AI 助手真正帮你处理日常琐事,而不是只能聊天。谁也没想到,这只"龙虾"后来搅动了整个开源世界。

Anthropic 的法务团队"礼貌地"找上了门,毕竟名字和 Claude 太像了。于是 Clawdbot 改名 Moltbot(molt 是龙虾蜕壳的意思,挺有诗意),但这名字实在不好念。三天后,它又变成了 OpenClaw。Peter 自己说,“这次我们做了功课,商标检索通过了,域名也买了。”

改名的混乱没有阻止它的疯狂增长。2026 年 1 月 29 日到 30 日,OpenClaw 在 48 小时内获得了 34,168 颗 GitHub Star,高峰时每小时 710 颗。到现在,它的 Star 数已经突破 187,000,成为 GitHub 历史上增长最快的开源项目之一。有人形容这不像是自然增长,更像是一个社区一直在等它出现。

然后事情开始变得更有趣了。

2026 年 2 月 9 日,中国的 RISC-V 硬件厂商矽速科技(Sipeed)发布了 PicoClaw,一个用 Go 语言从零重写的超轻量 AI 助手。它的口号直接了当,“10 美元硬件,10MB 内存,1 秒启动”。仓库上线 15 小时就突破 500 Star,3 天破 3,100,Hackster.io、CNX Software、Circuit Digest 等硬件技术媒体纷纷跟进报道。

如果说 OpenClaw 是"AI 管家住进了你的 Mac mini",那 PicoClaw 想做的就是"AI 管家住进了你口袋里那块邮票大小的开发板"。

这两个项目代表了当下 AI Agent 发展的两个极端方向,一个追求"什么都能做",一个追求"在哪里都能做"。作为一个长期关注 AI 应用落地的人,我觉得有必要把它们放到一起,认真聊一聊。而且不仅聊对比,还要聊怎么用,怎么选,甚至怎么拿它赚钱。

两个项目的家世背景

OpenClaw 是怎么来的

Peter Steinberger 最初的想法很朴素。他在 Pragmatic Engineer 的采访中坦率地说,“I ship code I don’t read”,意思是他大量使用 AI 来写代码,然后直接发布。这种"vibe coding"的方式在开发者圈子里引起过不少争议,但不可否认,它确实催生了一个现象级产品。

OpenClaw 的核心理念用 Peter 自己的话说就是,“an AI that actually does things”。它不只是跟你聊天,而是真的能帮你清理邮箱、管理日历、航班值机、操作浏览器、甚至用 WhatsApp 帮你回消息。它运行在你自己的设备上,你的数据留在你手里。到今天,OpenClaw 的代码量超过 430,000 行 TypeScript,有 9,384 次 Commit,31,500 个 Fork,社区贡献者遍布全球。

围绕 OpenClaw 已经形成了一个相当活跃的知识生态。如果你不想直接啃代码,可以先通过 OpenClaw GPT(OpenAI GPTs 版本)、Google Gemini 上的 OpenClaw Gem,或者 Poe.com 上的 OpenClaw GPT 来了解这个项目。这些 AI 助手可以回答关于 OpenClaw 的安装、配置、使用等各种问题,相当于一个随时在线的入门导师。

但 OpenClaw 有一个现实问题。它需要 Node.js 22 运行时,推荐在 Mac mini(起步价 599 美元)上运行,实际内存占用超过 1GB。启动一次在低频单核处理器上要等 500 秒以上。对于很多开发者来说,这意味着你得专门准备一台像样的机器来伺候这只"龙虾"。

PicoClaw 和它背后的三层血统

PicoClaw 的故事要从另一个项目说起。OpenClaw 爆红后,香港大学的 HKUDS 团队觉得 430,000 行代码太重了,于是用 Python 写了一个叫 nanobot 的精简版,只有大约 4,000 行代码,号称"99% 更小的 OpenClaw"。nanobot 证明了一件事,AI 助手的核心功能其实不需要那么多代码。

Sipeed 看到了 nanobot,但他们的野心更大。Python 虽然代码精简,但运行时依赖重,在嵌入式设备上跑 Python 解释器仍然需要 100MB 以上的内存。于是 Sipeed 决定用 Go 语言把 nanobot 的思路彻底重写,目标是让 AI 助手能跑在自家 9.9 美元的 LicheeRV Nano 开发板上。那是一块只有 SD 卡大小(22x36mm)的 RISC-V 板子,搭载 SOPHGO SG2002 处理器,1GHz 主频,256MB DDR3 内存。

整个项目在 1 天内完成,大约 95% 的核心代码由 AI Agent 自动生成,人类开发者主要做架构决策和质量把控。Go 的静态编译特性让最终产物是一个不依赖任何外部运行时的单一二进制文件,复制到目标设备上就能跑。

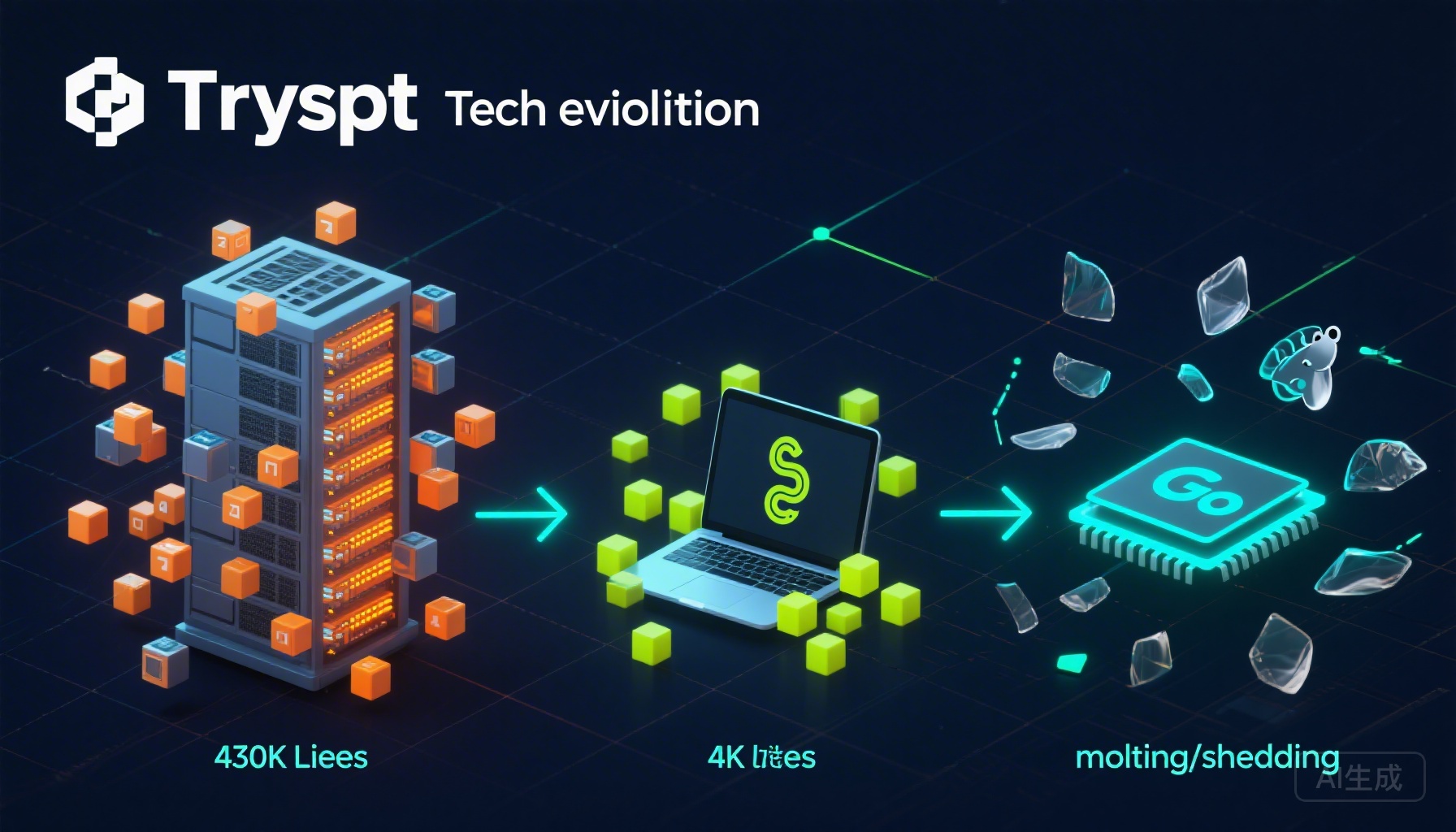

所以 PicoClaw 的血统是这样的。OpenClaw(全功能,430K 行 TypeScript)蜕壳为 nanobot(精简,4K 行 Python),再蜕壳为 PicoClaw(极致精简,Go 语言,嵌入式友好)。每一步都是一次大幅度的"减法",但保留的是 AI 助手最核心的那部分能力。

图:从 430K 行到极致精简,每一次蜕壳都是一次大幅度的减法

硬指标对决,数字不会说谎

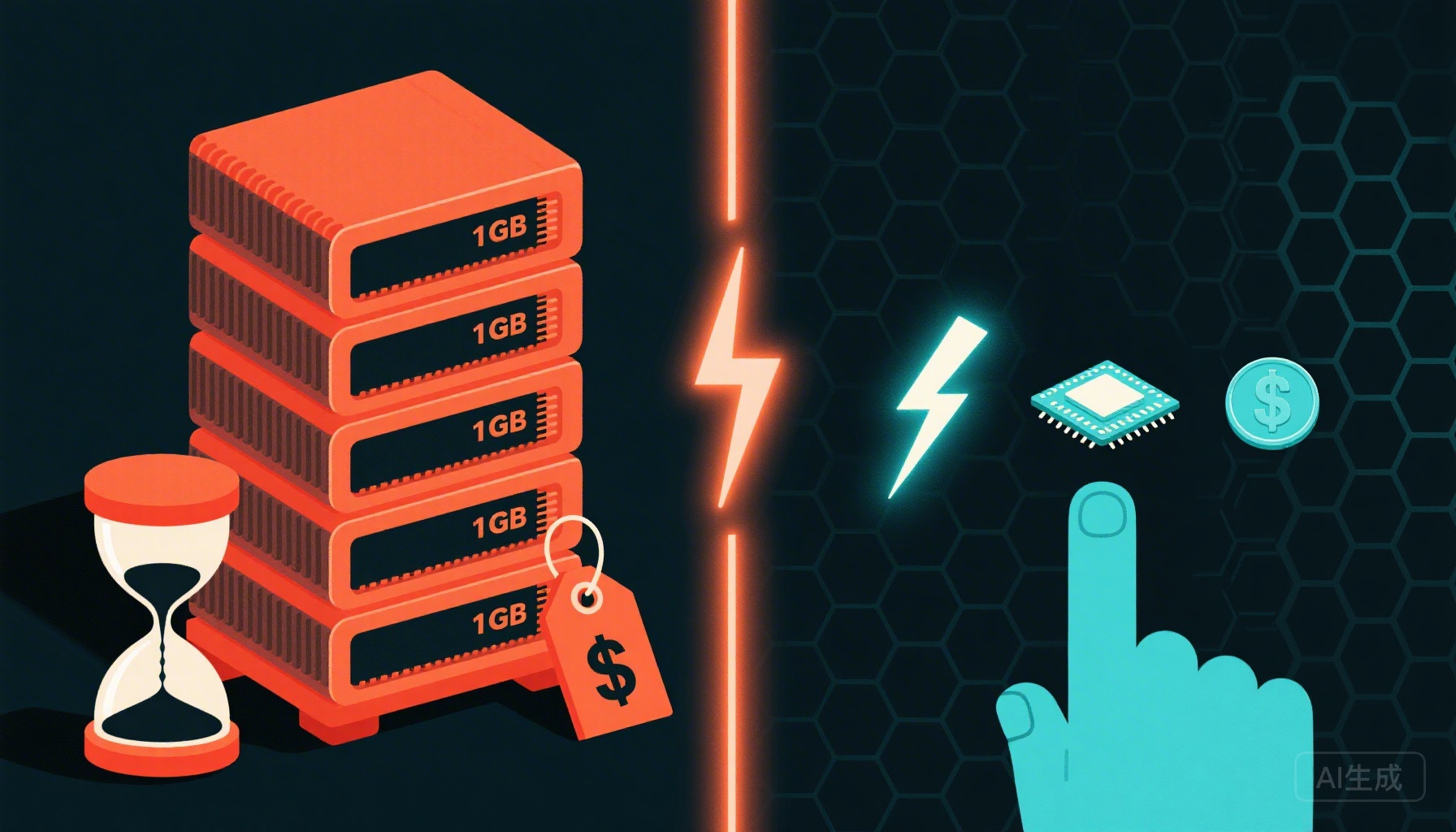

图:100 倍内存差距、500 倍启动速度差距、60 倍成本差距

在具体聊架构和功能之前,先看一组最直观的数据。这是 PicoClaw 官方给出的三方对比,我在此基础上做了一些补充。

| 指标 | OpenClaw | NanoBot | PicoClaw |

|---|---|---|---|

| 编程语言 | TypeScript | Python | Go |

| 内存占用 | >1GB | >100MB | <10MB |

| 启动时间(0.8GHz 单核) | >500 秒 | >30 秒 | <1 秒 |

| 最低硬件成本 | Mac mini $599 | 大部分 Linux SBC ~$50 | 任意 Linux 板 ~$10 |

| CPU 架构支持 | x86-64, ARM64 | x86-64, ARM64 | x86-64, ARM64, RISC-V |

| 运行时依赖 | Node.js 22 + npm 生态 | Python 3 + pip | 无(单一静态二进制) |

| 代码规模 | 430,000+ 行 | ~4,000 行 | 极精简 |

| AI 代码生成占比 | 部分 | 部分 | 95% |

数字差异是惊人的。内存占用相差约 100 倍,启动速度相差约 500 倍,硬件成本相差约 60 倍。但这里有一个重要的上下文需要理解。PicoClaw 之所以这么"轻",是因为它把所有计算密集型工作全部外包给了云端 LLM API,本地只做消息路由和记忆管理。OpenClaw 的"重",有相当一部分来自它丰富的本地功能,比如浏览器控制、语音处理、Canvas 渲染。CNX Software 的评测也指出了这一点。

换个角度看,两者都需要付费调用 LLM API,这部分成本是相同的。真正的差异在本地部分。

从功能密度的角度,也就是"每 MB 内存能换来多少实用功能",PicoClaw 的比值极高。在不到 10MB 的内存预算下,它支持了 Discord、Telegram、QQ、钉钉、飞书五个消息平台,还有 Web 搜索、定时任务、长期记忆、语音识别(通过 Groq Whisper)和全栈编程能力。这个"功能/内存"比,就是 PicoClaw 官方网站所强调的核心竞争力。

技术架构,两种截然不同的哲学

OpenClaw 的"本地微服务"思路

打开 OpenClaw 的架构文档,你会发现它本质上是一个运行在本地的微服务系统。核心是一个 WebSocket Gateway,监听在 ws://127.0.0.1:18789,所有的客户端都通过这个 Gateway 来协调工作。

WhatsApp / Telegram / Slack / Discord / 更多渠道...

|

Gateway

(WebSocket 控制平面)

ws://127.0.0.1:18789

|

Pi agent (RPC) / CLI / WebChat UI

macOS app / iOS node / Android node

这个架构让 OpenClaw 能做到很多 PicoClaw 做不到的事情。比如多设备协同,你可以在 Mac 上运行 Gateway,iPhone 和 Android 手机同时作为"节点"连接上来,摄像头拍照、屏幕录制、GPS 定位这些设备专属的能力都可以被 AI 调用。再比如 Docker 沙箱隔离,群聊会话可以运行在独立的 Docker 容器里,防止恶意指令影响宿主系统。还有 Tailscale 远程访问,你可以安全地从外网访问运行在家里的 OpenClaw。

但这些复杂性是有代价的。Node.js 22 运行时、npm 包管理、WebSocket 服务、浏览器 CDP 控制,这些模块叠加在一起,内存占用超过 1GB 几乎是必然的。OpenClaw 是一个"平台型"架构,像一个运行在你家里的小型 Kubernetes。

PicoClaw 的"薄客户端"思路

PicoClaw 的架构简单到几乎可以用一句话概括。一个 Go 进程,连接消息平台和 LLM API,中间做消息路由和记忆管理。

没有 WebSocket Gateway,没有多设备协同,没有浏览器控制,没有 Docker 沙箱。它把所有计算密集型的工作全部外包给了云端 LLM API,本地只保留最薄的一层。这也是它能把内存压到 10MB 以下的根本原因。PicoClaw 是一个"设备型"架构,像一个贴着硬件跑的精简固件。

Go 语言在这里的选择非常聪明。Go 的静态编译意味着最终产物是一个自包含的二进制文件,没有运行时依赖,没有包管理器,没有 node_modules 地狱。更关键的是,Go 原生支持交叉编译,一行命令就能编译出 RISC-V、ARM64、x86-64 三种架构的二进制文件。极低的 GC(垃圾回收)压力和更可控的系统资源使用,也让它非常适合 7×24 小时长期稳定运行,这在嵌入式和工业场景中是刚需。

这里有一个容易被忽视的细节。PicoClaw 在 0.6GHz 单核处理器上也能在 1 秒内启动,而 OpenClaw 在 0.8GHz 单核上需要超过 500 秒。在嵌入式场景中,启动时间直接决定了用户体验。想象一下,你对着一个智能家居设备说了句话,然后等了 8 分钟它才准备好回答你。

图:左侧 OpenClaw 的星形拓扑微服务架构,右侧 PicoClaw 的极简单进程直连

功能全景,"瑞士军刀"和"手术刀"

图:OpenClaw 是功能繁多的瑞士军刀,PicoClaw 是精准锋利的手术刀

消息平台,不同的朋友圈

OpenClaw 支持的消息平台数量是压倒性的。WhatsApp、Telegram、Slack、Discord、Google Chat、Signal、iMessage(通过 BlueBubbles)、Microsoft Teams、Matrix、Zalo、WebChat,总共 13 个以上。几乎覆盖了西方用户日常使用的所有主流通讯工具。

PicoClaw 目前支持 5 个平台,Telegram、Discord、QQ、钉钉和 WhatsApp。数量差距明显,但选择非常有策略性。Telegram 和 Discord 是全球开发者社区的标配,QQ 和钉钉则精准命中了中国用户的日常场景。如果你在国内工作,不需要 iMessage 和 Slack,PicoClaw 的渠道覆盖其实已经够用了。从 PicoClaw 的完整配置文件来看,飞书(Feishu)的支持也已经在列表中了。

LLM 提供商,意外的逆转

在大语言模型的支持上,PicoClaw 反而比 OpenClaw 更丰富。OpenClaw 强烈推荐 Anthropic Claude Opus 4.6(需要 Pro/Max 订阅,每月 100 到 200 美元),主要考虑长上下文能力和 Prompt 注入防护。

PicoClaw 原生支持 7 家提供商。其中已经充分验证的有 智谱 GLM-4.7 和 Google Gemini,OpenRouter、Anthropic、OpenAI、DeepSeek、Groq 也在支持列表中。免费额度方面,OpenRouter 每月提供 200K tokens,智谱同样提供 200K tokens,Groq 有免费推理额度并且附带 Whisper 语音转文字,Brave Search 每月 2000 次免费查询。对中国用户来说,智谱和 DeepSeek 可以直接在国内网络环境下调用,不需要任何特殊网络配置,这是一个非常实际的优势。

核心能力矩阵

两者都能做到基本的对话交互、长期记忆(通过 MEMORY.md 文件)、Cron 定时任务和 Web 搜索。PicoClaw 的演示中还展示了全栈工程能力,帮用户写代码、做项目规划、搜索学习材料。

但 OpenClaw 的"深水区"功能是 PicoClaw 目前完全没有的。浏览器控制可以让 AI 操作 Chrome 浏览器,帮你填表、下载文件、截图。Canvas / A2UI 是一个 AI 驱动的可视化工作区。Voice Wake + Talk Mode 支持语音唤醒和持续语音对话。多 Agent 路由允许不同的渠道和用户连接到不同的 AI Agent。还有 ClawHub Skills 平台,社区开发者可以发布和共享 AI 技能插件。macOS、iOS、Android 都有原生 Companion App。

这些功能的缺失不是 PicoClaw 的 bug,而是它的 feature。做得少,才能跑得小。

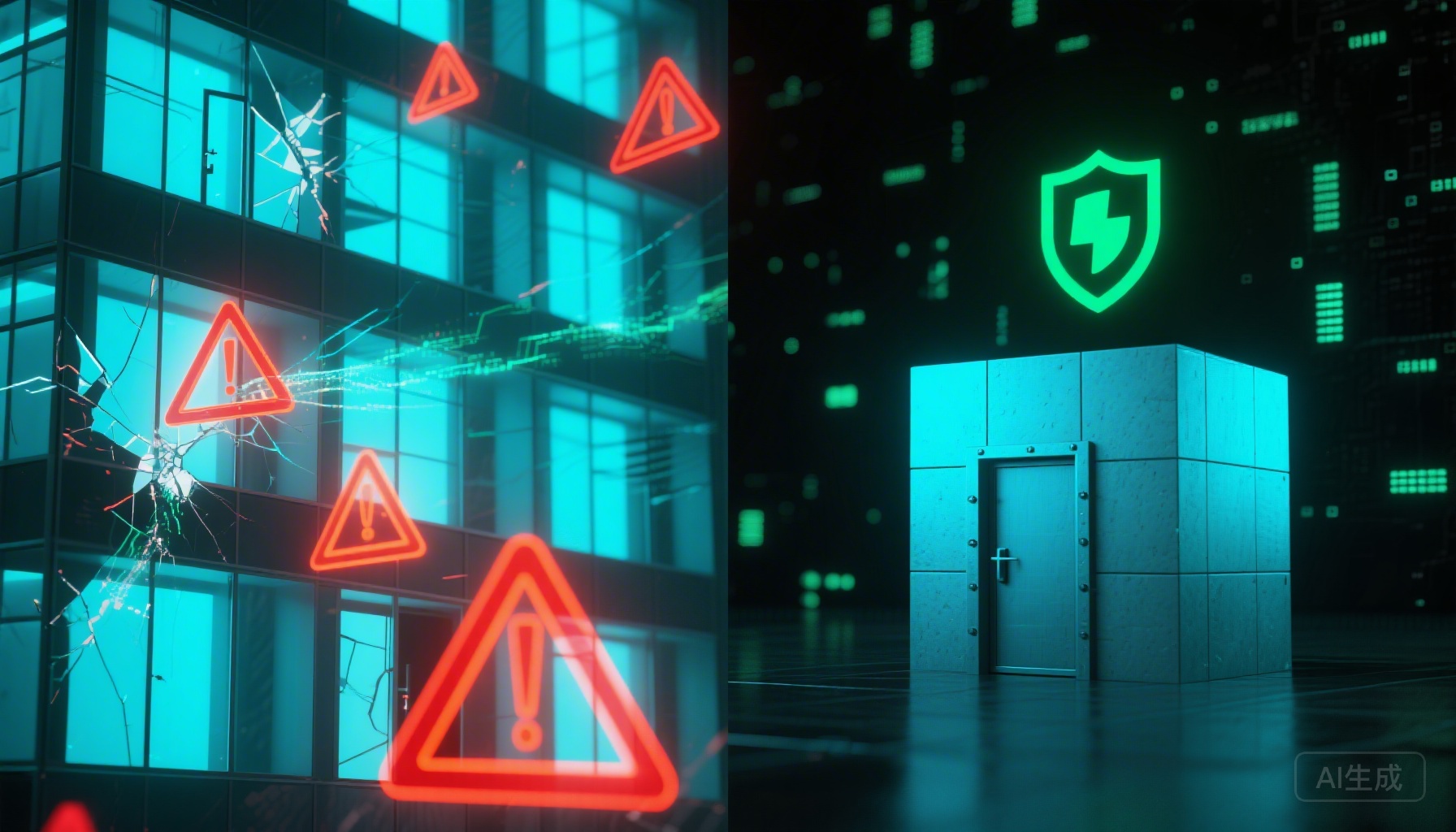

安全,那个绕不开的话题

OpenClaw 的安全问题可能是它成名路上最大的阴影。

图:更多功能意味着更大的攻击面,简单性本身就是一种安全保障

2026 年 2 月初,安全研究公司 depthfirst 披露了 CVE-2026-25253,CVSS 评分 8.8(高危)。默认配置下,OpenClaw 的 WebSocket Gateway 没有认证保护,恶意网页可以通过 JavaScript 静默连接到本地 Gateway,窃取认证令牌,进而完全控制宿主系统。Hunt.io 的研究团队扫描发现互联网上有超过 17,500 个暴露的 OpenClaw 实例受此漏洞影响。紧接着 SentinelOne 又披露了 CVE-2026-25475,一个路径遍历漏洞。Cisco 的 AI 安全研究团队测试了 OpenClaw 的第三方 Skill,发现存在数据窃取和 Prompt 注入风险。SecurityScorecard 的报告则从更宏观的层面分析了暴露实例的分布。

OpenClaw 的一位核心维护者在 Discord 上直言不讳地警告用户,"如果你不懂如何运行命令行,这个项目对你来说太危险了。“OpenClaw 团队在 2026.1.29 版本中修复了 CVE-2026-25253,并在新版本中增加了 34 项安全相关的 Commit。但正如 Peter 自己承认的,Prompt Injection 仍然是"整个行业未解决的问题”。

PicoClaw 在安全方面的处境完全不同。它没有 WebSocket Gateway 暴露在网络上,没有浏览器控制这种高权限功能,不管理用户的消息账户登录态(只通过 Bot API 交互),单进程架构意味着攻击面非常小。但这种"安全优势"更多是"做的事情少"的副产品,而不是刻意的安全设计。PicoClaw 的 API 密钥同样以明文存储在 ~/.picoclaw/config.json 中,如果设备被物理访问,风险依然存在。

对于普通用户来说,PicoClaw 的简单性本身就是一种安全保障。对于企业或政务场景,PicoClaw 的单二进制、无外部依赖、可完全离线运行的特性,反而更容易通过合规审计。

手把手教程,从零开始跑通 PicoClaw

聊了这么多理论,是时候动手了。下面是一份完整的 PicoClaw 部署教程,涵盖从安装到接入 Telegram 的全过程。整个过程大约只需要 5 到 10 分钟。

第一步,准备硬件和系统

PicoClaw 对硬件要求极低。官方网站标注的最低要求是 64MB 内存(推荐 512MB),支持 x86-64、ARM64 和 RISC-V 三种架构。也就是说,你家里的任何一台 Linux 电脑、Mac、Windows(WSL2)、树莓派、甚至一块 9.9 美元的 LicheeRV Nano 都可以。

如果你想体验"10 美元 AI 助手"的极致方案,Sipeed 列出了几个推荐的硬件搭配。LicheeRV Nano E(带以太网)或 W(带 WiFi 6)版本适合做最小化家庭助手。NanoKVM(30 到 100 美元)本身是远程 KVM 设备,加上 PicoClaw 可以变成智能运维助手。MaixCAM(50 到 100 美元)自带摄像头,适合智能监控场景。

第二步,安装 PicoClaw

方式一,下载预编译二进制文件(最简单)

前往 GitHub Releases 页面,根据你的平台下载对应的文件。目前提供 RISC-V 64 位 Linux、ARM64 Linux、AMD64 Linux 和 AMD64 Windows 四个版本。下载后解压,就是一个可以直接运行的二进制文件,不需要安装任何额外的运行时。

方式二,从源码编译(推荐开发者使用)

git clone https://github.com/sipeed/picoclaw.git

cd picoclaw

make deps

make build # 编译当前平台

make build-all # 编译所有平台

make install # 编译并安装到系统路径

这需要你的机器上装有 Go 语言环境。make build-all 会一次性编译出所有架构的二进制文件,方便交叉部署。

第三步,初始化和配置

运行初始化命令。

picoclaw onboard

这会在 ~/.picoclaw/ 目录下创建配置文件和工作区。接下来编辑核心配置文件 ~/.picoclaw/config.json。

如果你在国内,推荐使用智谱 GLM-4.7 作为 LLM 提供商,因为无需特殊网络就能访问。先到智谱开放平台注册账号并获取 API Key,然后这样配置。

{

"agents": {

"defaults": {

"workspace": "~/.picoclaw/workspace",

"model": "glm-4.7",

"max_tokens": 8192,

"temperature": 0.7,

"max_tool_iterations": 20

}

},

"providers": {

"zhipu": {

"api_key": "你的智谱 API Key",

"api_base": "https://open.bigmodel.cn/api/paas/v4"

}

}

}

如果你想用多种模型并且不介意使用海外 API,推荐 OpenRouter,一个 Key 就能访问 Claude、GPT-4、Gemini 等多种模型,还有每月 200K tokens 的免费额度。

{

"agents": {

"defaults": {

"model": "anthropic/claude-opus-4-5"

}

},

"providers": {

"openrouter": {

"api_key": "sk-or-v1-你的OpenRouter Key",

"api_base": "https://openrouter.ai/api/v1"

}

}

}

Web 搜索是可选的。如果你想让 AI 助手具备联网搜索能力,到 Brave Search API 申请一个免费 Key(每月 2000 次查询),然后在配置文件中添加。

{

"tools": {

"web": {

"search": {

"api_key": "你的 Brave Search API Key",

"max_results": 5

}

}

}

}

第四步,开始对话

最简单的方式是直接在命令行聊天。

picoclaw agent -m "你好,介绍一下你自己"

或者进入交互式对话模式。

picoclaw agent

到这一步,你已经有了一个可以工作的 AI 助手。整个过程可能只花了 2 分钟。

第五步,接入 Telegram(推荐)

让 AI 助手住进你的聊天工具里,才是真正有趣的开始。Telegram 是最容易配置的渠道。

首先在 Telegram 中搜索 @BotFather,发送 /newbot,按照提示给你的 Bot 起个名字,然后你会收到一个 Bot Token,类似 123456:ABC-DEF1234ghIkl-zyx57W2v1u123ew11。

接着搜索 @userinfobot,它会返回你的 User ID,这是一串数字。

在 ~/.picoclaw/config.json 中添加 Telegram 渠道配置。

{

"channels": {

"telegram": {

"enabled": true,

"token": "你的 Bot Token",

"allowFrom": ["你的 User ID"]

}

}

}

allowFrom 字段是安全白名单,只有列表中的用户才能和你的 Bot 对话。这个细节虽小,但很重要。

最后启动网关服务。

picoclaw gateway

回到 Telegram,找到你刚创建的 Bot,发送一条消息试试。如果一切配置正确,你会在几秒内收到 AI 的回复。

第六步,接入钉钉或 QQ(中国用户)

钉钉需要先到钉钉开放平台创建一个企业内部应用,获取 Client ID 和 Client Secret。

{

"channels": {

"dingtalk": {

"enabled": true,

"client_id": "你的 Client ID",

"client_secret": "你的 Client Secret",

"allow_from": []

}

}

}

allow_from 设为空数组表示允许所有人使用,也可以指定特定用户。

QQ 需要到 QQ 开放平台创建应用,获取 AppID 和 AppSecret。

{

"channels": {

"qq": {

"enabled": true,

"app_id": "你的 AppID",

"app_secret": "你的 AppSecret",

"allow_from": []

}

}

}

所有渠道配好后,统一用 picoclaw gateway 启动即可,PicoClaw 会同时监听所有已启用的渠道。

第七步,设置定时任务和长期记忆

PicoClaw 内置了 Cron 定时任务功能,支持三种模式。一次性提醒,比如对 AI 说"10 分钟后提醒我开会"。周期性任务,比如"每 2 小时提醒我喝水"。标准 Cron 表达式,比如"每天早上 9 点给我发送天气预报"。

任务数据存储在 ~/.picoclaw/workspace/cron/ 目录下,可以通过命令行管理。

picoclaw cron list # 查看所有定时任务

picoclaw cron add ... # 添加新任务

picoclaw status # 查看整体状态

长期记忆保存在 ~/.picoclaw/workspace/memory/MEMORY.md 文件中,AI 会自动将重要的对话内容和你的偏好写入这个文件,下次对话时自动加载。

完整配置示例

如果你想一次性配置好所有功能,下面是一个涵盖多个 LLM 提供商和多个消息渠道的完整配置文件参考。

{

"agents": {

"defaults": {

"model": "anthropic/claude-opus-4-5"

}

},

"providers": {

"openrouter": {

"api_key": "sk-or-v1-xxx"

},

"groq": {

"api_key": "gsk_xxx"

}

},

"channels": {

"telegram": {

"enabled": true,

"token": "123456:ABC...",

"allow_from": ["123456789"]

},

"discord": {

"enabled": true,

"token": "你的 Discord Bot Token",

"allow_from": ["你的 Discord User ID"]

},

"qq": {

"enabled": false,

"app_id": "",

"app_secret": "",

"allow_from": []

},

"dingtalk": {

"enabled": false,

"client_id": "",

"client_secret": "",

"allow_from": []

},

"feishu": {

"enabled": false,

"app_id": "cli_xxx",

"app_secret": "xxx",

"encrypt_key": "",

"verification_token": "",

"allow_from": []

}

},

"tools": {

"web": {

"search": {

"api_key": "BSA..."

}

}

}

}

配置 Groq 后,如果有人在 Telegram 发送语音消息,PicoClaw 会自动通过 Groq 的免费 Whisper 服务将语音转成文字再处理,这是一个小但实用的细节。

工作区目录结构

了解工作区的文件布局有助于你理解 PicoClaw 的数据管理方式。

~/.picoclaw/workspace/

├── sessions/ # 对话会话和历史记录

├── memory/ # 长期记忆(MEMORY.md)

├── cron/ # 定时任务数据库

├── skills/ # 自定义技能

├── AGENTS.md # Agent 行为指南

├── IDENTITY.md # Agent 身份定义

├── SOUL.md # Agent 灵魂设定

├── TOOLS.md # 工具描述

└── USER.md # 用户偏好

你可以直接编辑这些 Markdown 文件来自定义 AI 的行为。比如修改 SOUL.md 来设定 AI 的人格特征,修改 USER.md 来告诉 AI 你的偏好和习惯。这种纯文本的配置方式,对于开发者来说透明而友好。

OpenClaw 快速上手对照

作为对比,我也简要整理一下 OpenClaw 的安装流程,让你心里有个数。

OpenClaw 需要 Node.js 22 运行时。安装方式是通过 npm 全局安装。

npm install -g openclaw@latest

openclaw onboard --install-daemon

引导向导会一步步带你配置 Gateway、消息渠道、LLM 提供商和 Skills。启动 Gateway 后可以通过 CLI 发消息。

openclaw gateway --port 18789 --verbose

openclaw agent --message "做一份待办清单" --thinking high

接入 Telegram 同样需要 BotFather 创建 Bot,配置在 ~/.openclaw/openclaw.json 中。

{

"channels": {

"telegram": {

"botToken": "123456:ABCDEF"

}

}

}

主要的区别在于,OpenClaw 的配置项更多,功能也更丰富,引导向导(openclaw onboard)会问你很多问题。Codecademy 上有一篇很详细的入门教程,从安装到第一次对话大约需要 20 分钟。如果你遇到问题,openclaw doctor 命令可以自动诊断常见配置错误。

常见问题排查

在使用 PicoClaw 的过程中,可能会遇到几个典型问题。

Web 搜索提示"API",这是正常的,说明你还没配置 Brave Search API Key。不配置也不影响基本对话功能,PicoClaw 会退而求其次提供手动搜索链接。

某些提供商返回内容过滤错误,比如智谱对部分内容有敏感词过滤。换一种说法重新提问,或者切换到其他模型即可。

Telegram Bot 报 “Conflict: terminated by other getUpdates”,这说明有另一个 PicoClaw 实例正在运行。确保同一时间只有一个 picoclaw gateway 进程在跑。

产品决策者视角,这不只是技术对比

前面聊的更多是技术维度。但对于做产品和商业化的人来说,PicoClaw 和 OpenClaw 的差异还有更深层的含义。

正确的产品梯队

把两者放进一个完整的产品光谱来看,它们不是竞争关系,而是分层互补。

[ 云端 / 企业管理层 ] → OpenClaw (平台型、Gateway 架构、全功能)

↑

[ 车间 / 本地协调层 ] → NanoBot (中间态、Python、轻量协调)

↑

[ 设备 / 控制器层 ] → PicoClaw (设备型、Go、嵌入式友好)

OpenClaw 是「AI Agent 的 Kubernetes」,PicoClaw 是「AI Agent 的 FreeRTOS」。一个管全局,一个贴设备。工业客户和系统集成商最喜欢的就是这种分层架构,因为每一层的安全边界和职责划分都非常清晰。

图:从云端到设备,三层 AI Agent 产品梯队各司其职

PicoClaw 的三种可商业化形态

从产品负责人的角度看,PicoClaw 的极致轻量不只是技术炫技,它打开了 OpenClaw 完全进入不了的市场空间。

第一种形态是 AI 硬件产品。 把 PicoClaw 直接烧进硬件里,变成一个随插即用的个人 AI 助手设备。形态可以是 USB-C 的 AI 助手棒,桌面小盒子,路由器或 NAS 的 AI 插件,甚至是工控网关里内置的 AI 模块。核心卖点是不依赖电脑、不吃资源、即插即跑。这是 OpenClaw 完全打不过的赛道,因为你没法在一个 10 美元的设备上跑 Node.js 22 和 1GB 内存的程序。

第二种形态是企业私有化部署。 “能跑在任何老旧服务器上的 AI 助理”,这句话对政府、国企、制造业这些客户来说非常有吸引力。不需要 Docker、不需要 Node.js、不需要 GPU,内存 10MB 以下,单一二进制文件,容易备案、容易审计、容易部署到完全断网的内网环境。"低配置可落地"恰好是私有化场景的刚需。

第三种形态是超轻量 Agent SDK。 把 PicoClaw 做成可嵌入的 AI Agent Runtime SDK,卖给硬件厂商、IoT 平台、OS 厂商和 RISC-V 生态合作伙伴。这种思路可以类比 SQLite,SQLite 不是要和 PostgreSQL 竞争,它要做的是"让任何应用都能内嵌数据库"。PicoClaw 的潜力也在于此,让任何设备都能内嵌 AI Agent。

工业场景的特殊契合

如果把视角再推进一步,到工业机器人和 AIoT 领域,PicoClaw 的特性匹配度极高。工业系统对 AI 的约束和消费级完全不同。内存可能只有 64 到 512MB,网络可能是隔离内网,启动要求毫秒到秒级,运行必须 7×24 稳定,安全审计要求严格。

一个具体的场景是"工业机器人的自然语言控制副脑"。PicoClaw 驻留在机器人控制柜或工控机上,把操作员的自然语言指令转化为结构化控制指令,通过 ROS2、Modbus、OPC-UA 等协议与机器人通信。不用 PLC 工程师,普通操作员也能跟机器人说人话。

另一个场景是"设备 AI 运维诊断 Agent"。PicoClaw 监听传感器数据、日志和错误码,在本地做异常分析和操作建议,通过钉钉或飞书推送给运维人员。设备不再只给你一个冷冰冰的报警码,而是用自然语言解释发生了什么、建议怎么处理。

这些场景里,OpenClaw 太重了,nanobot 虽然轻但仍然偏软件。只有 PicoClaw 能真正"贴着控制器跑"。

真实的想法

写到这里,有几个感受想分享。

AI Agent 的"上半场"和"下半场"正在同时开打。 OpenClaw 代表的是上半场,"让 AI 做更多事"。PicoClaw 代表的是下半场,"让 AI 无处不在"。从技术发展的规律来看,几乎所有技术最终都会走向更小、更便宜、更无处不在。从大型机到 PC,从 PC 到手机,从手机到 IoT。AI Agent 大概率也会走这条路。

图:向上扩展能力,向下渗透万物——AI Agent 的两条演化路径正在同时展开

安全问题不是 OpenClaw 一家的问题,而是整个 AI Agent 行业的问题。 当你给 AI 助手访问邮箱、日历、浏览器的权限时,它本质上就变成了一个拥有你全部数字身份的代理人。CVE-2026-25253 的教训是,任何面向网络的 AI Agent 都需要从第一天就把安全作为核心设计考量。PicoClaw 目前"安全"更多是因为它做的事情少,一旦功能增加,同样的挑战会出现。对于想要商业化部署的团队来说,安全加固清单应该包括默认关闭高风险能力、IM 入口白名单、密钥只允许环境变量存储不进日志、日志脱敏、更新可回滚等基本措施。

PicoClaw 的"1 天开发 + 95% AI 生成"模式值得每个技术团队认真思考。 当需求足够清晰,技术选型足够合理,AI 确实可以大幅压缩开发周期。这不意味着人类开发者不重要。恰恰相反,架构决策、场景定义、质量把控这些"高阶判断"仍然是人类的活。但"从零构建一个轻量级 AI 应用"的成本已经急剧下降了。

PicoClaw 发布 3 天拿到 3,100 Star 的增速说明了一个真实的市场信号,人们渴望"跑得动、买得起"的 AI Agent 方案。但 3,100 和 187,000 之间的差距也说明它还有很长的路要走。目前只有 57 个 Commit,没有插件生态,文档还在 README 阶段。从一个"有趣的实验"变成一个"可靠的工具",取决于 Sipeed 和社区接下来几个月的投入。

这两个项目放在一起看,让我想起一个很简单的道理。好的技术选型从来不是"哪个更好",而是"在什么约束下哪个更合适"。OpenClaw 在"功能丰富"的约束下找到了自己的最优解,PicoClaw 在"极致轻量"的约束下找到了另一个。

如果你是一个追求全能体验的个人用户,愿意投入 Mac mini 级别的硬件,OpenClaw 的 187,000 Star 和 完整文档不是白来的。如果你在中国做开发、做 IoT、做工业,或者单纯想用最低成本体验 AI Agent,去 GitHub 下载 PicoClaw 的二进制文件,花 5 分钟配好智谱的 Key,再花 5 分钟接上钉钉或 Telegram,你会发现,原来 AI 助手可以这么轻。