引言

大语言模型(LLM)的发展日新月异,但一直以来受制于上下文窗口长度的限制。随着应用场景的不断扩展,处理长文本的能力已成为LLM的关键性能指标之一。本文将深入探讨大语言模型中的长度与上下文拓展技术,从位置编码的进阶技术到超长上下文处理方案,为读者全面剖析这一领域的最新进展。

一、位置编码的演进与挑战

1.1 传统位置编码的局限性

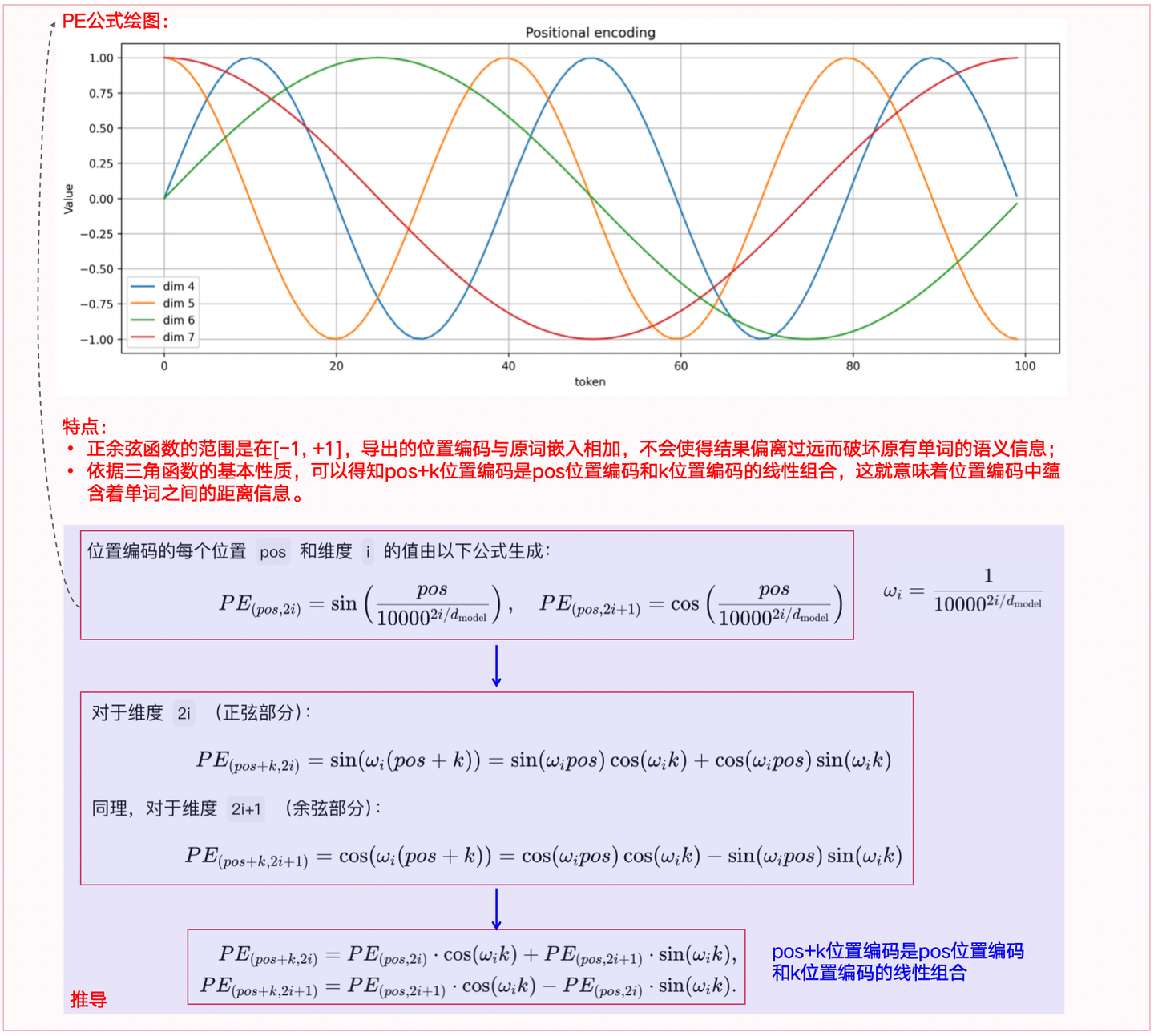

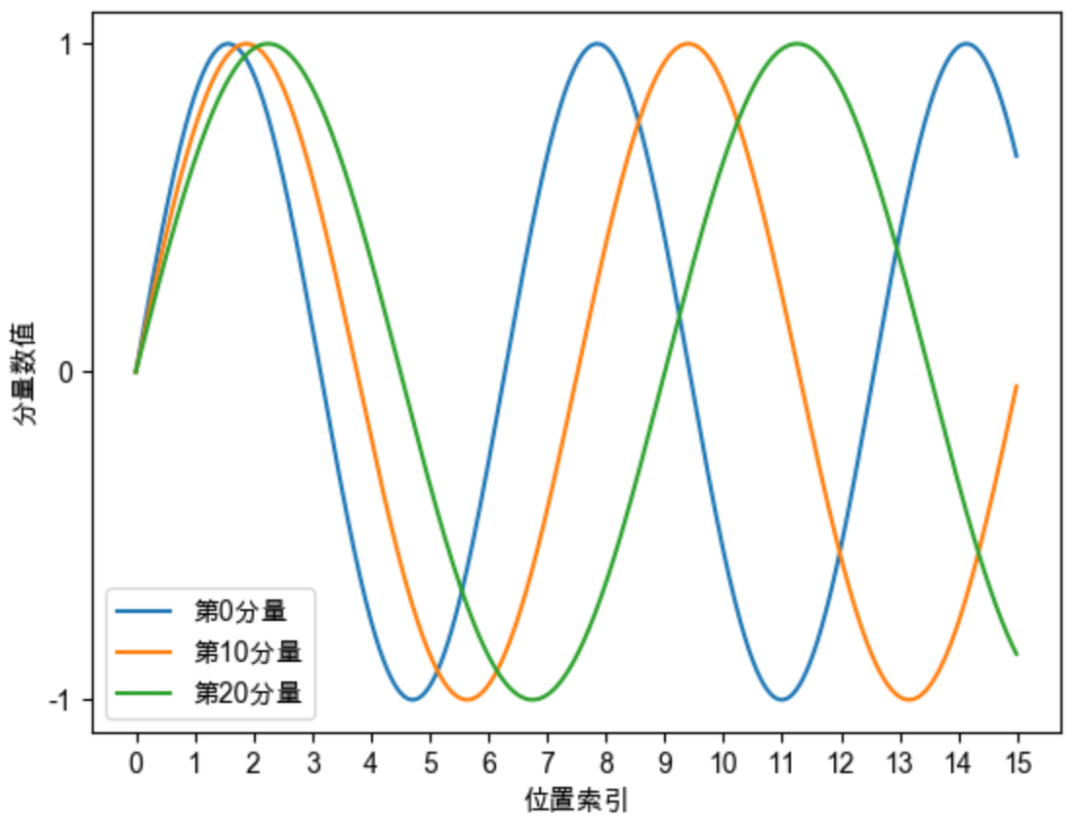

Transformer架构的出现彻底改变了自然语言处理领域,但其注意力机制本身不包含序列顺序信息。为解决这个问题,最初的Transformer模型采用了正弦/余弦位置编码:

PE(pos, 2i) = sin(pos/10000^(2i/d_model))

PE(pos, 2i+1) = cos(pos/10000^(2i/d_model))

然而,这种标准位置编码在处理超出训练序列长度的文本时表现不佳。当模型需要处理比训练时见过的更长序列时,位置编码会进入"未知区域",导致模型性能严重下降。

1.2 RoPE:旋转位置编码的突破

旋转位置编码(Rotary Position Embedding, RoPE)是一种能够将相对位置信息集成到self-attention中并提升transformer架构性能的位置编码方式。其核心思想是以旋转矩阵的形式将位置信息注入到模型中。

RoPE的关键公式如下:

f_q(x_m, m) = R_Θ^m · x_m

f_k(x_n, n) = R_Θ^n · x_n

其中R_Θ表示旋转矩阵。

RoPE的优势在于:

- 能够同时捕获绝对位置和相对位置信息

- 线性复杂度,计算高效

- 序列外推能力更强

- 与注意力机制的兼容性更好

然而,即使是RoPE也面临长度外推问题,即当处理的序列长度大大超过训练时的长度时,模型性能仍会下降。

二、YaRN技术:高效的上下文窗口扩展

2.1 YaRN技术概述

YaRN (Yet another RoPE extensioN)是一种高效的RoPE扩展方法,旨在解决长度外推问题。YaRN技术能够大幅扩展模型的上下文窗口,且所需训练token减少10倍,训练步骤减少2.5倍。

2.2 YaRN的核心原理

YaRN综合了多种技术,其核心组件包括:

- 注意力缩放:通过调整注意力机制的温度参数,平衡长距离关系的影响

- NTK-by-parts插值:在不同维度上使用不同的插值策略,避免外推问题

YaRN解决了之前位置编码扩展方法中的三大问题:

- 高频信息丢失问题:通过NTK-aware插值解决

- 相对局部距离损失问题:通过NTK-by-parts插值技术处理

- 长距离平均最小余弦相似度问题:通过增加熵来解决

2.3 YaRN的优势

根据研究结果,YaRN展示了显著的优势:

- 在不到原始训练数据0.1%的数据上进行微调后,YaRN在上下文窗口的扩展上超过了其他测试方法

- 能够将LLaMA模型的上下文处理能力从4K扩展到128K甚至更高

- 可以与FlashAttention等其他注意力优化机制兼容使用

- 在扩展到更大的上下文窗口时,保持了较低的困惑度

实验表明,在Proof-pile和GovReport等长序列数据集上,YaRN模型的性能优于所有其他上下文窗口扩展方法,特别是YaRN(s=32)模型在128K的上下文长度中仍然表现出色,尽管微调数据仅限于64K长度。

三、超长上下文处理与注意力优化

3.1 注意力机制的瓶颈

标准的多头自注意力机制在处理长序列时面临严重的计算和内存瓶颈,其复杂度为O(n²),其中n是序列长度。当处理10万级别的token序列时,这种二次方增长的计算开销变得难以承受。

3.2 注意力优化技术

为了解决这一问题,多种注意力优化技术被提出:

3.2.1 稀疏注意力

稀疏注意力通过选择性地处理部分token对来降低计算复杂度。常见的稀疏注意力变体包括:

- 局部注意力:只关注相邻的一小段序列

- 分块注意力:将序列分为若干块,只在块内部进行全连接注意力计算

- 滑动窗口注意力:使用固定大小的滑动窗口来限制注意力的计算范围

3.2.2 线性注意力

线性注意力机制将注意力的计算复杂度从O(n²)降低到O(n),大幅提升了长序列处理能力:

- Performer:使用随机特征近似核函数

- Linear Transformer:通过重新排列矩阵乘法运算顺序

- FlashAttention:通过优化内存访问模式提高计算效率

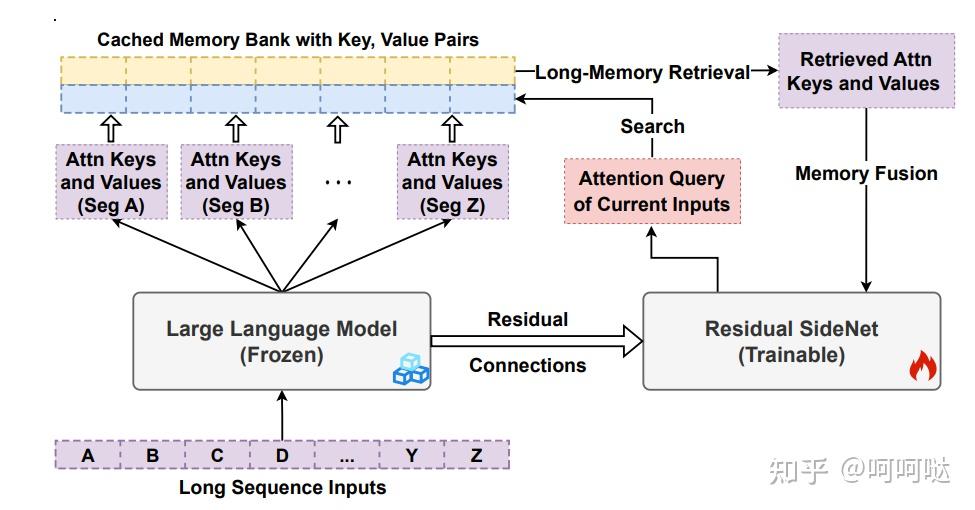

3.2.3 检索增强注意力

针对超长上下文,检索增强注意力(Retrieval Attention)能够有效地管理长范围依赖关系:

A_mem = (σ(Q)M_{s-1})/(σ(Q)z_{s-1})

通过检索增强注意力,模型可以在保持几乎相同准确度的情况下,对长上下文进行高效推理。

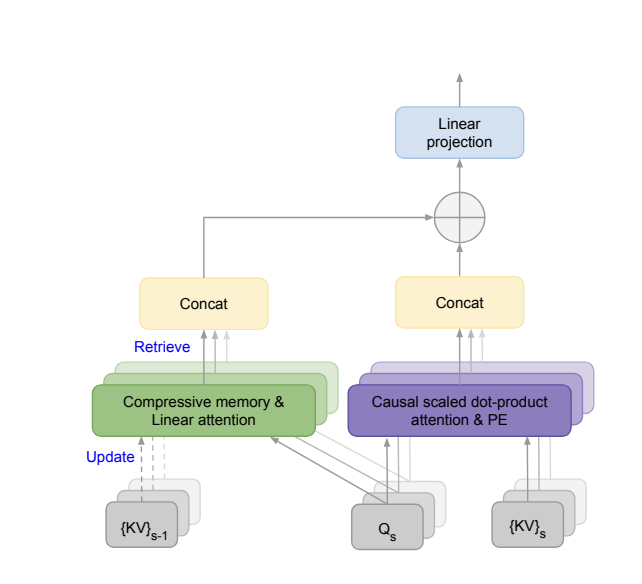

3.3 Infini-attention:无限上下文的解决方案

Infini-attention是一种创新的注意力机制,将压缩记忆集成到标准注意力中,支持无限长度的上下文处理。

Infini-attention的核心是通过压缩内存技术,将历史信息高效地存储和检索:

- 使用线性注意力机制压缩历史信息

- 通过可学习的门控机制平衡局部和长期信息

- 实现固定内存复杂度下的无限上下文处理

实验结果表明,Infini-attention能够高效处理长达1M token的序列,在保持固定内存使用量的同时,维持较低的困惑度。

四、10万+token的处理方案

4.1 大规模预训练与持续学习

处理10万级别token的一个直接方法是增加预训练阶段的上下文窗口大小,但这会大大增加训练成本。更实用的方法是采用持续学习策略:

- 分阶段训练:先用2k或4k上下文训练基础模型,再用更长上下文进行微调

- 渐进式扩展:逐步增加训练中的上下文长度

- 混合长度训练:在训练过程中混合使用不同长度的序列

4.2 LongLoRA:高效的长文本微调

LongLoRA是一种计算效率高的微调技术,可以将7B模型的上下文长度扩展到10万token,将70B模型扩展到3.2万token。

LongLoRA技术的关键在于:

- 结合S2-Attention和注意力下采样机制降低训练开销

- 采用LoRA微调,仅训练少量参数

- 通过位置插值来提高长上下文建模能力

4.3 TokenSWIFT:加速超长文本生成

TokenSWIFT框架从模型加载、KV缓存管理到Token生成策略进行了全方位优化,能够在90分钟内生成10万Token,实现3倍无损加速。其核心技术包括:

- 优化KV缓存管理:高效处理超长序列的键值对

- 动态批处理:根据序列长度动态调整批处理大小

- 自适应解码:根据内容复杂度调整生成策略

五、超并发处理技术

5.1 并发控制策略

在实际应用中,LLM服务需要同时处理多个请求,这就需要高效的并发控制策略:

- 连续批处理(Continuous Batching):动态合并请求,最大化GPU利用率

- 动态缩放:根据当前负载调整模型精度和计算资源分配

- 优先级队列:根据请求重要性和资源需求进行调度

使用vLLM等工具,连续批处理和特定内存优化可以实现多达23倍的吞吐量提升。

5.2 高效推理框架比较

多种并发加速部署框架在超并发处理中发挥重要作用:

- llama.cpp:适合低资源环境,支持CPU和GPU混合推理

- vLLM:利用PagedAttention技术实现高效KV缓存管理

- LightLLM:纯Python实现的轻量级高性能LLM推理框架

- FastLLM:适合边缘设备的优化推理引擎

这些框架通过不同的优化策略来提高LLM的并发处理能力。

5.3 分布式推理技术

处理超大规模并发请求时,单机资源往往不足,此时需要分布式推理技术:

- 张量并行:将模型层内计算分布到多个设备上

- 流水线并行:将模型的不同层分布到不同设备上

- 专家混合(MoE):动态路由到不同的专家模型

这些技术结合起来,可以实现超过10万token的高并发处理。

六、未来发展与挑战

6.1 理论与实践的差距

尽管已经有多种方法可以扩展LLM的上下文窗口,但依然面临以下挑战:

- 记忆退化问题:随着上下文窗口的增大,模型对早期信息的记忆能力会下降

- 计算资源限制:处理超长上下文需要大量计算资源,不是所有用户都能负担

- 训练与推理的不一致:训练时使用的上下文长度与实际应用中需要处理的长度差异大

6.2 创新方向

未来长度与上下文拓展的研究方向包括:

- 记忆压缩技术:开发更高效的记忆压缩和检索机制

- 结构化记忆:采用图结构或树结构来组织长期记忆

- 神经符号集成:结合神经网络和符号推理系统,提高长期记忆和推理能力

- 自适应注意力:根据内容重要性动态调整注意力机制

- 硬件专用加速器:开发专门针对超长上下文处理的硬件加速器

大语言模型的长度与上下文拓展技术正在快速发展,从位置编码的进阶技术(如RoPE)到超长上下文处理方案(如YaRN、LongLoRA和Infini-attention),研究者们不断突破模型处理长文本的能力边界。

尽管如此,10万+token的高效处理和超并发应用仍面临诸多挑战。未来的研究将围绕记忆压缩、高效注意力机制和专用硬件加速等方向展开,推动大语言模型在更广泛的应用场景下发挥作用。

随着技术的不断进步,我们有理由相信,大语言模型将突破当前的限制,实现更长、更高效的上下文处理,为人工智能应用开辟更广阔的前景。