大型语言模型(LLM)正以前所未有的速度融入企业的核心业务流程,为创新带来了巨大机遇。然而,将LLM从实验阶段推向稳定、高效、可信赖的生产环境,面临着诸多独特的挑战。LLM的“黑盒”特性、动态且难以预测的生成行为、对计算资源的高昂需求以及复杂的多阶段应用架构,都使得传统的软件监控手段显得力不应手。

网页版:https://qftkbuyn.gensparkspace.com

视频版:https://www.youtube.com/watch?v=usMGWnNVA8A

音频版:https://notebooklm.google.com/notebook/d8888721-9458-4272-a919-0fbd4d70d200/audio

想象一下,您的LLM应用在处理用户请求时突然响应变慢,输出了事实性错误,或者计算成本急剧上升。没有深入的可见性,工程师们将难以快速定位问题、理解根本原因,更无法持续优化系统。因此,构建一个全面、深入的企业级LLM系统可观测性与智能监控平台,已不再是可选项,而是确保LLM应用成功落地的基石。

本文将深入探讨企业级LLM系统监控的关键方面,从基础的可观测性概念出发,详细阐述全链路追踪、性能监控、成本分析、异常检测与预测性维护等核心技术,并探讨如何通过数据驱动的方法实现系统优化和自动扩缩容,最终勾勒出智能监控平台的架构与关键能力,为企业构建稳定、高效、可信赖的LLM应用提供路线图。

LLM系统可观测性基础:洞察“黑盒”内部

可观测性是指从系统外部通过收集、关联和分析其产生的遥测数据,来推断系统内部状态的能力。对于LLM系统,这意味着需要超越简单的健康检查,去理解每个请求的完整生命周期、模型的实际行为、数据流以及资源消耗的细节。

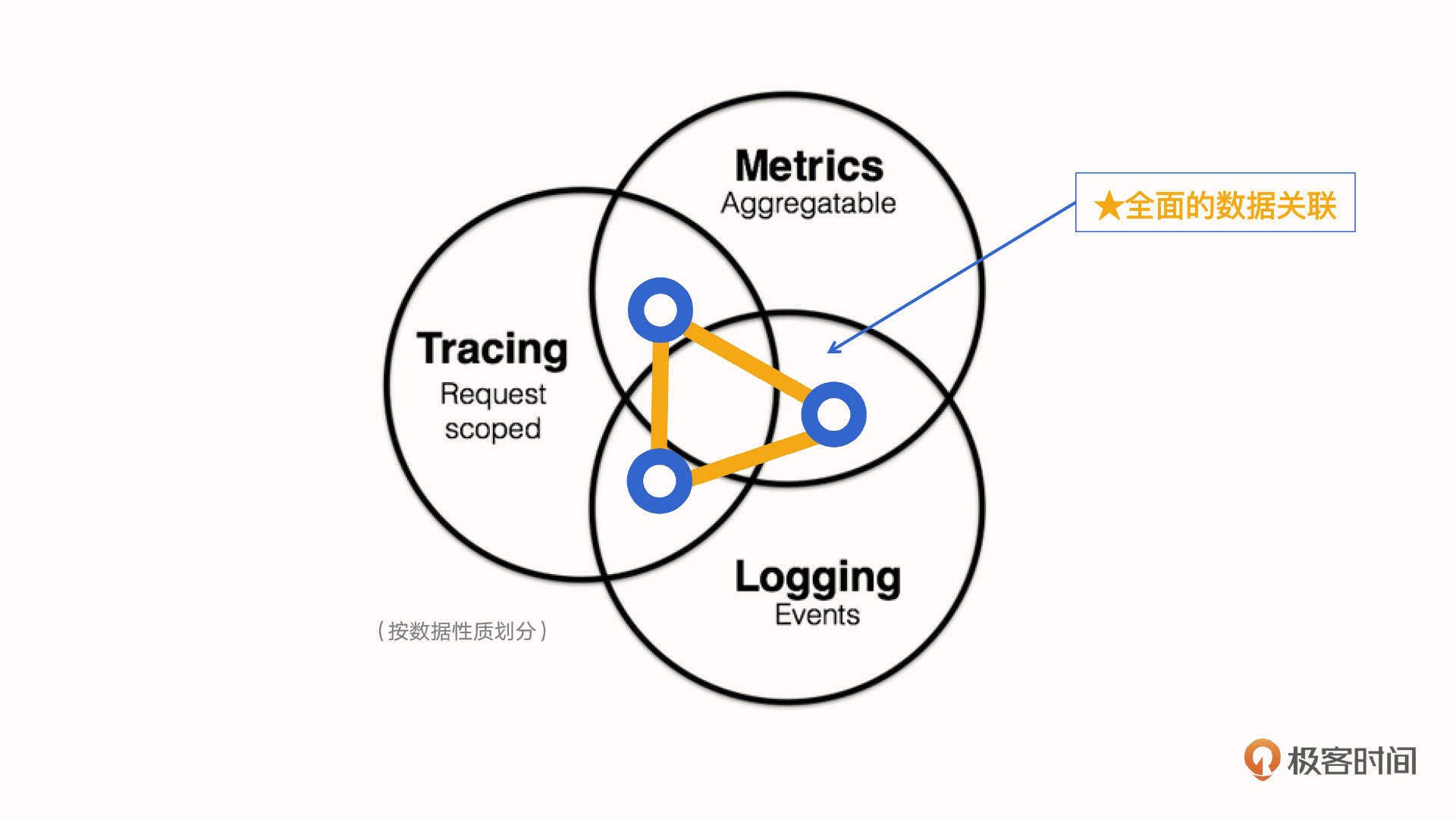

传统的软件可观测性通常基于三个核心支柱:日志(Logs)、指标(Metrics)和追踪(Traces),简称“MELT”。

-

日志 (Logs):记录系统在特定时刻发生的离散事件。对于LLM系统,日志需要捕获的关键信息包括:

- 用户输入的原始提示词

- 发送给模型的最终提示词(可能包含系统提示、历史对话、RAG上下文等)

- 模型返回的原始响应

- 应用的后处理结果

- API调用的详细信息(请求ID、时间戳、状态码)

- 错误信息和堆栈追踪

- 关键业务事件(如用户点赞/点踩、内容分享)

结构化日志(如JSON格式)能够极大提升日志的可分析性。

-

指标 (Metrics):对系统行为的聚合数值度量,随时间变化。LLM系统的指标可分为:

- 操作性指标:关注系统性能和资源效率,如:

- 延迟 (Latency):总响应时间、首个Token生成时间 (TTFT)、每Token生成时间 (TPOT)。

- 吞吐量 (Throughput):每秒请求数 (RPS)、每秒Token数 (Tokens/sec)。

- 错误率:API调用失败率、模型生成错误率。

- 资源利用率:GPU/TPU利用率、显存使用率、CPU/内存使用率。

- 功能性/质量指标:关注模型输出的质量和有效性,如:

- 幻觉率、事实一致性(需通过评估或外部知识源判断)。

- 相关性、连贯性。

- 内容安全性评分、偏见程度。

- 基于用户反馈的满意度指标(点赞率、评分)。

- 特定任务指标(如摘要的ROUGE得分、翻译的BLEU得分)。

- LLM特有指标:Token成本、提示词成功率、Embedding质量(RAG)。

- 操作性指标:关注系统性能和资源效率,如:

-

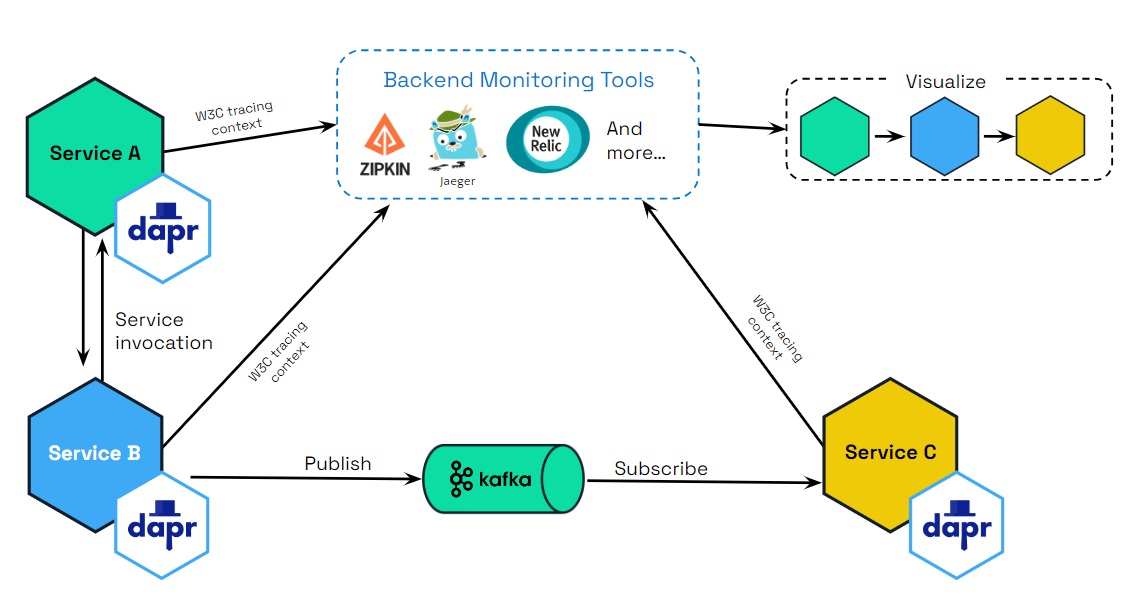

追踪 (Traces):记录单个请求从进入系统到返回响应期间,流经所有组件的完整路径和处理时间。这对于复杂的分布式LLM应用(如包含检索、排序、生成、后处理的多阶段管道)至关重要。每个追踪由一系列嵌套的跨度(Span)组成,每个Span代表一个操作或服务调用。

除了传统的MELT,LLM可观测性还必须融入用户反馈数据和模型评估结果,形成一个更全面的反馈闭环。用户反馈(显式如评分,隐式如编辑、重新生成)是衡量模型在实际使用中表现的关键信号;持续的模型评估(自动化和人工)则帮助捕捉模型漂移和性能下降。

LLM系统可观测性的特有挑战:

- “黑盒”和生成行为:难以直接查看模型内部推理过程,生成式输出的多样性和不可预测性增加了监控和评估的复杂性。

- 动态性:模型的行为会随输入、上下文甚至微小的权重更新而变化,需要持续、实时的监控来捕捉这些变化。

- 指标定义:许多质量指标(如幻觉率、相关性)难以自动化或需要人工评估,成本高昂。

- 数据量巨大:每个请求可能涉及大量Token,日志和追踪数据增长迅速。

- 多模态和复杂管道:RAG、Agent等复杂应用包含多个异构组件,追踪和理解数据流更加困难。

最佳实践包括:确保所有关键交互和中间步骤都被日志记录;定义并持续追踪操作性与功能性LLM指标;实施全链路追踪以理解复杂管道;建立用户反馈收集机制;将可观测性数据集成到开发和运营工作流中。

关键监控技术详解

全链路追踪:揭示复杂LLM管道的真相

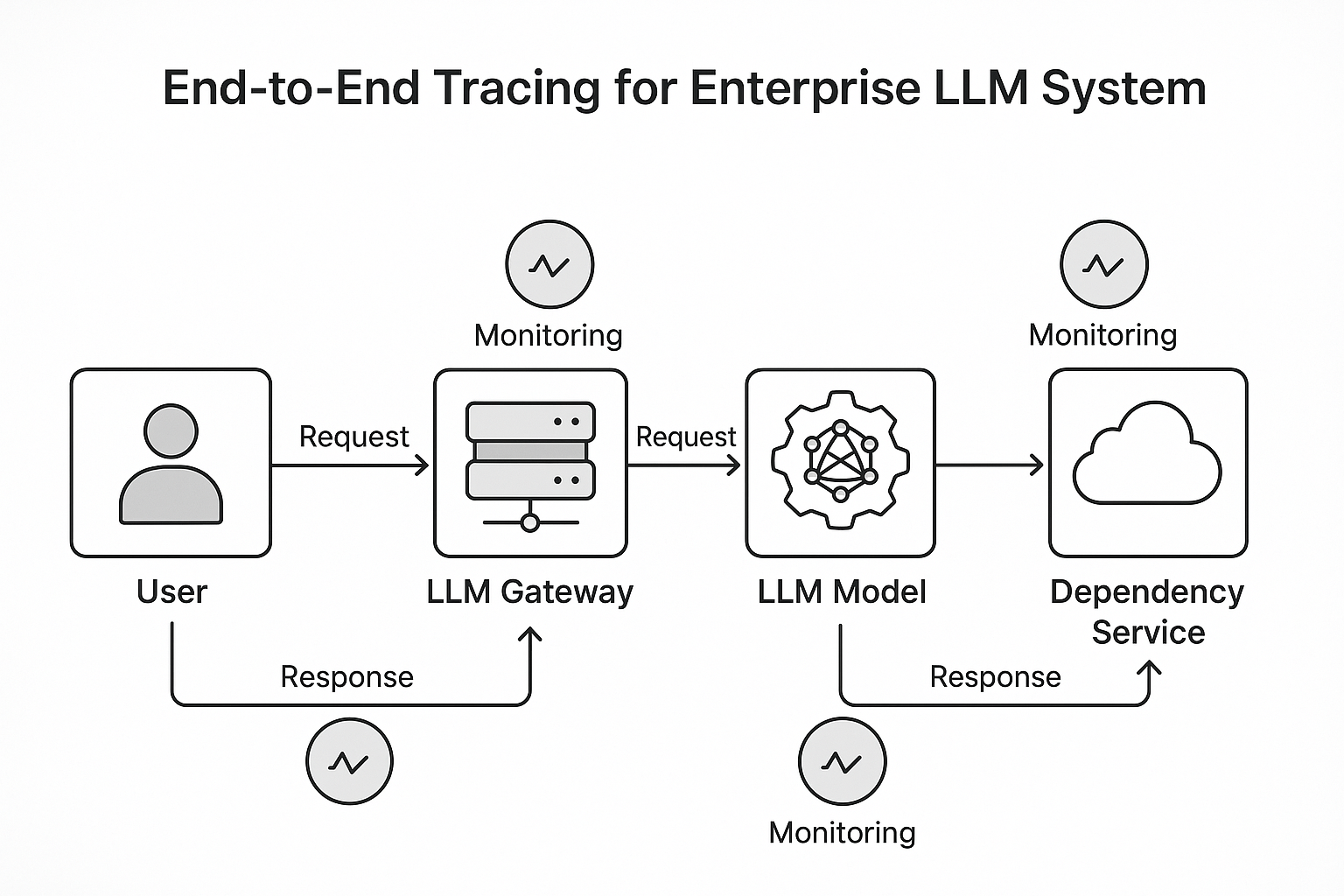

在许多企业级LLM应用中,单个用户请求会经历一个复杂的多阶段管道,例如:用户提问 -> 输入预处理 -> 检索增强(查询向量化 -> 向量数据库检索 -> 文档重排序)-> 构建提示词 -> 调用LLM -> LLM生成响应 -> 响应后处理 -> 返回用户。在这样的流程中,如果出现高延迟或错误,很难迅速 pinpoint 问题出在哪一个环节。

全链路追踪正是为了解决这个问题而生。

目的:

- 可视化和理解请求流经分布式或多组件系统的完整路径。

- 测量每个组件(Span)的处理时间,识别性能瓶颈。

- 关联不同服务和操作的日志、指标和错误,进行高效的根因分析。

- 理解LLM在接收特定输入和上下文后是如何生成响应的,增强可解释性。

在LLM管道中的工作原理:通过在代码的关键点(如服务调用、函数执行、数据库查询、LLM API调用)注入代码(Instrumentation),捕捉请求的上下文信息(Trace ID, Span ID)、输入、输出、元数据和执行时间。这些信息被发送到追踪后端进行存储和可视化。

- 预处理Span:记录原始输入、提示词模板应用、Token化过程。

- RAG Span:包括向量化调用、向量数据库查询(记录查询向量、返回文档ID、相似度)、文档读取、文档分块、重排序等子Span。

- LLM推理Span:记录发送给LLM的完整提示词、模型配置、LLM的Token流生成过程(如Prefill和Decode阶段的时间)、Token使用量、原始LLM输出。

- 后处理Span:记录输出解析、格式化、安全检查、质量评估等。

优势:显著提高复杂LLM应用的调试效率,帮助发现隐藏的性能问题和逻辑错误,支持基于真实请求路径进行模型和管道优化。

关键工具与框架:

- OpenTelemetry (OTel):行业标准的开源遥测框架,支持日志、指标、追踪的收集和导出。许多LLM相关的库和工具正积极集成OTel。

- OpenLLMetry / Traceloop:基于OpenTelemetry,专注于LLM应用遥测数据的自动捕获。

- Langfuse:开源平台,提供LLM追踪、评估和提示词管理的一体化解决方案。

- LangSmith:LangChain提供的类似平台,强调调试、测试和监控。

通过实施全链路追踪,企业能够将LLM应用从“黑盒”转变为一个更透明、更易于管理的系统。

性能监控:速度与效率的较量

LLM推理是计算密集型任务,性能(尤其是延迟和吞吐量)直接决定了用户体验和系统的运营成本。有效的性能监控能够帮助企业平衡这两者。

关键性能指标(KPIs):

- 延迟:

- Time To First Token (TTFT):用户等待首个字符出现的时间,是流式应用的关键指标。

- Time Per Output Token (TPOT):后续字符的生成速度,影响阅读流畅度。

- End-to-End Latency:完整响应所需时间。

- 吞吐量:

- Requests Per Second (RPS):系统每秒处理的请求数。

- Total Tokens Per Second (TPS):系统每秒处理的总Token数(输入+输出)。

- Output Tokens Per Second (OTPS):系统每秒生成的输出Token数,常用于衡量生成能力。

- 资源利用率:GPU/TPU、显存、CPU、内存的使用率。

影响性能的因素:

- 硬件:GPU/TPU型号、显存容量和带宽。高端GPU(如H100)提供高带宽显存,对TPOT至关重要。

- 模型:模型大小(参数量)、架构效率。

- 输入/输出长度:Token数量越多,计算量越大。

- 软件优化:

- 批处理 (Batching):将多个请求打包处理以提高硬件利用率。连续批处理 (Continuous Batching) 是现代框架(如vLLM)的关键优化,显著提高吞吐量并降低平均延迟。

- 缓存 (Caching):KV Cache 加速后续Token生成;提示词缓存避免重复计算。

- 模型量化 (Quantization):降低模型精度以减少计算和显存需求,提升速度。

- 并行技术:模型并行、管道并行处理超大模型。

- 高效的注意力机制:FlashAttention, PagedAttention 等优化算法减少内存I/O,提高计算效率。

监控与优化:通过持续监控上述指标,结合全链路追踪识别瓶颈,运用批处理、量化、缓存等软件优化技术,并根据负载模式进行资源调配,以在性能、成本和资源利用之间找到最优解。例如,通过监控请求队列长度和GPU利用率,指导自动扩缩容策略。

成本分析:管理高昂的计算开销

LLM的运营成本,尤其是计算资源成本,是企业必须精细管理的关键因素。透明和准确的成本分析是进行成本优化的第一步。

主要成本构成:

- 计算资源:GPU/TPU实例(按需、预留、竞价)、CPU实例。这是最大的开销。

- API调用:使用第三方LLM服务按Token付费(输入/输出Token费率不同)。

- 存储:模型文件、训练/评估数据、日志、遥测数据。

- 数据传输:跨区域/可用区流量。

- 向量数据库:RAG架构中向量数据库的存储和查询成本。

- 训练/微调:GPU时间、数据标注成本。

- 人力成本:MLOps、工程、数据科学团队。

自有托管 vs API 调用:

- 自有托管:控制力强,单位成本可能更低,适合大流量、稳定负载。但初期投资高,需专业运维。

- API调用:灵活便捷,按需付费,适合需求波动大、小规模或快速验证场景。成本随Token量线性增长。

隐藏成本与挑战:

- 输入/输出长度的可变性:难精确预估单次请求成本。

- 隐式Token消耗:系统提示词、RAG上下文、工具调用等都会增加Token数。

- 低效率的使用模式:冗余或重复的请求、低效的提示词。

- 缺乏细粒度成本归因:难以将成本准确分摊到用户、功能或业务线。

成本优化策略:

- 模型选择:根据任务复杂度选择最小但足够胜任的模型,或使用微调过的小模型。

- 提示词工程:优化提示词减少Token消耗。

- 批处理与缓存:提高资源利用率,减少重复计算。

- 动态模型路由/级联:根据请求复杂度分发到不同成本的模型。

- 量化:降低模型运行成本。

- 自动扩缩容:避免资源闲置。

- 持续监控与分析:按用户、功能、提示词跟踪Token使用量和成本,识别浪费点,设置预算告警。

通过全面的成本监控和数据驱动的优化策略,企业可以在控制运营成本的同时,最大化LLM应用的业务价值。

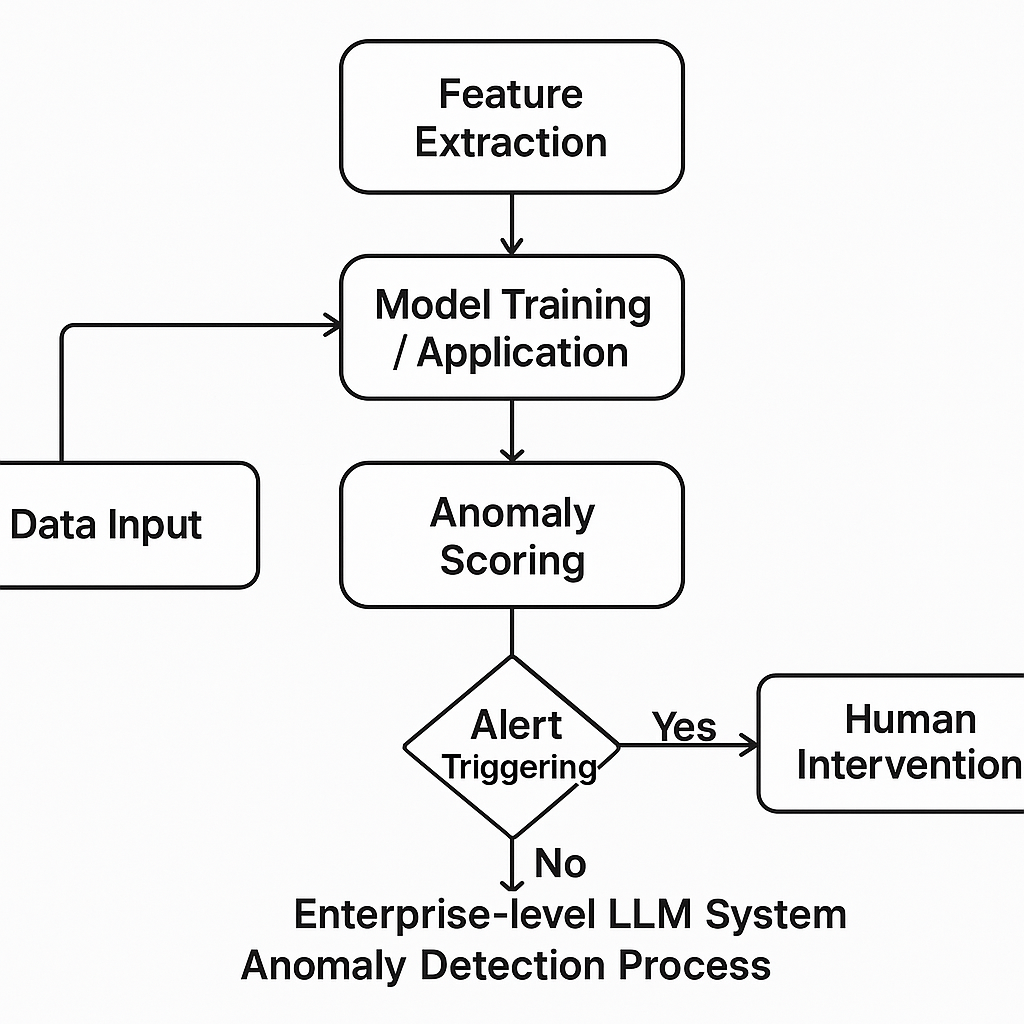

异常检测:及时发现问题与风险

LLM系统的异常可能体现在多个层面:输入数据质量问题、模型输出异常(幻觉、偏见、不安全内容)、基础设施故障或使用模式异常。及时准确地检测这些异常对于维护系统稳定性和可信度至关重要。

异常类型:

- 输入数据异常:格式错误、偏离正常分布、恶意注入(提示词攻击)。

- 模型输出异常:幻觉、事实性错误、与上下文无关、重复、不安全、偏见。

- 操作性异常:延迟/错误率突增、吞吐量骤降、资源利用异常。

- 安全异常:异常访问模式、潜在数据泄露。

检测方法:

- 传统方法:统计分析(阈值、均值方差)、机器学习算法(Isolation Forest, SVM, Autoencoders)、时间序列分析(ARIMA, Prophet)适用于数值指标或结构化数据。

- LLM驱动的异常检测:利用LLM本身的语义理解能力,识别文本数据中的异常,如:

- 通过提示工程指导LLM作为评估员,判断其输出是否符合标准或存在特定异常。

- 用于检测输入提示词中的恶意意图或越狱尝试。

- 分析模型输出的语义一致性、相关性、安全性。

- 可结合传统方法,先用传统方法筛查,再用LLM进行深度语义分析。

- 规则和启发式方法:基于预定义的规则(如关键词过滤、长度限制)进行检测。

挑战:定义“正常”行为的基线困难;异常模式多样且不断演变;误报和漏报的平衡;LLM驱动检测的计算开销。

价值:确保数据质量,提升模型可靠性,增强系统安全性,为预测性维护提供信号。

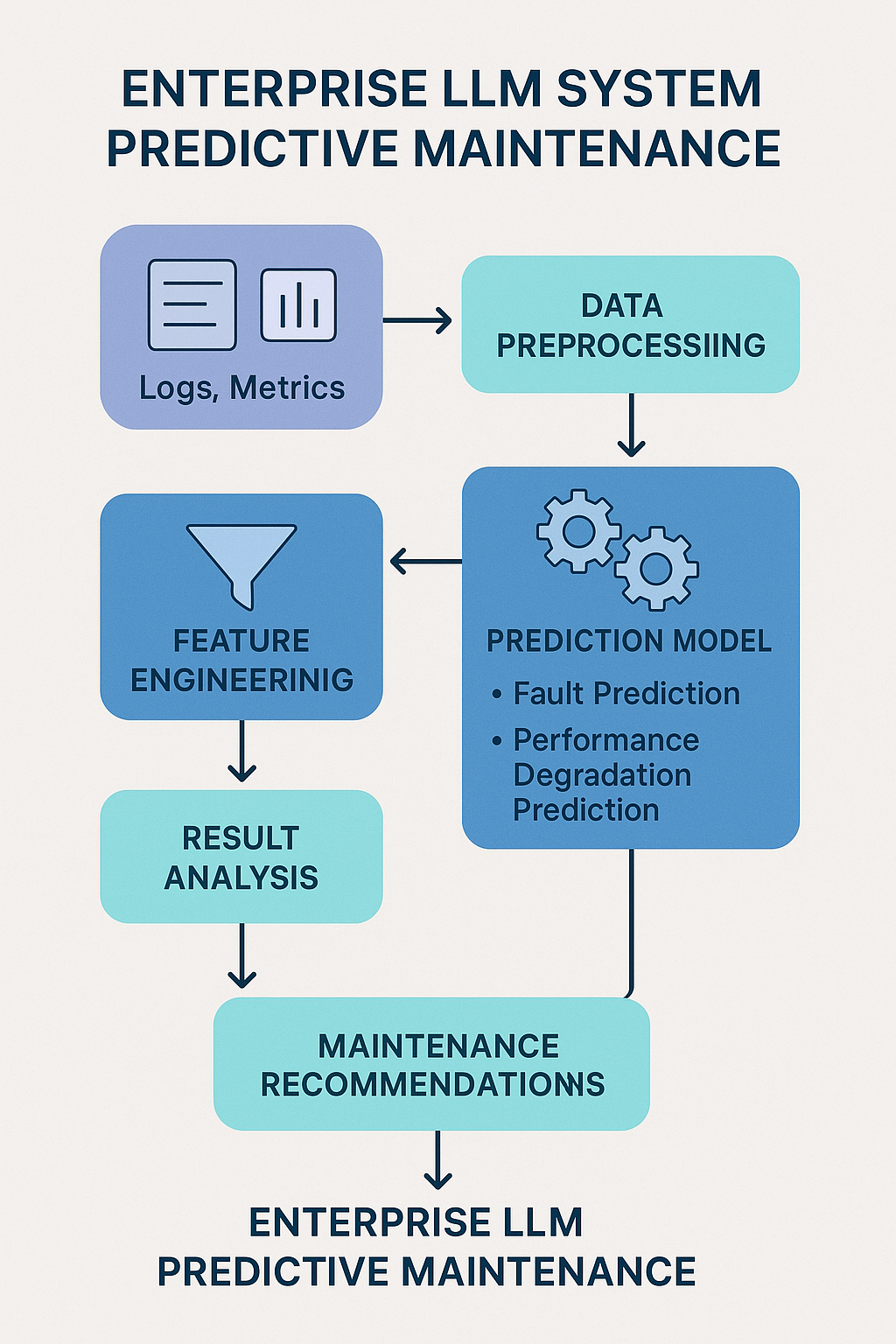

预测性维护:预见未来的风险

预测性维护利用历史和实时监控数据预测潜在的故障或性能下降,以便在问题发生前采取措施。在LLM系统中,这不仅包括基础设施的预测性维护,更重要的是对模型本身行为变化的预测(即模型漂移)。

应用领域:

- 基础设施:预测GPU故障、存储瓶颈、网络问题等,避免服务中断。

- 模型:预测模型漂移——输入数据分布、概念、或输出分布的变化,导致模型性能随时间推移而下降。

模型漂移:

- 原因:社会文化变迁、新知识、用户行为变化、上游数据改变、对抗性输入。

- 影响:准确率下降、输出不一致、用户体验差、安全隐患。

- 检测:持续监控输入/输出数据分布统计特征、关键性能指标(如准确率、用户反馈)、与基线的差异。

- 应对:主动触发模型再训练/微调、在线学习、人工干预、模型版本管理与回滚。

LLM在预测性维护中的作用:

LLM可以分析非结构化数据(如维护日志、用户反馈),结合结构化监控数据,识别复杂模式,辅助根因分析,甚至生成规范性维护建议。例如,分析用户反馈和错误日志,预测哪些类型的查询可能导致模型在未来出现问题。

通过将预测性维护集成到监控体系中,企业可以从被动响应转向主动管理,提高LLM系统的韧性和可持续性。

数据驱动优化与自动扩缩容

监控数据不仅用于发现问题,更是驱动系统持续优化的宝贵资产。基于生产环境中的真实使用数据,企业可以系统地改进LLM应用的各个方面。

数据驱动优化:让数据指引改进方向

核心理念:从静态评估转向基于实时数据的动态优化,形成“数据收集 -> 洞察提取 -> 实验验证 -> 部署推广”的反馈循环。

优化领域与策略:

- 提示词工程优化:分析不同提示词变体的性能、成本和用户满意度,进行A/B测试,持续迭代优化提示词模板。

- 模型选择与参数调优:根据真实流量下的性能、成本、质量数据,选择最合适的模型或调整推理参数(temperature, top-p, max_tokens)。通过A/B测试比较不同模型或参数配置的效果。

- 性能优化:利用延迟、吞吐量、资源利用率和追踪数据,定位瓶颈并优化批处理、缓存、资源分配等。

- 成本控制:分析Token消耗和每请求成本,指导提示词优化、模型选择和资源规划,识别并消除浪费。

- 输出质量提升:结合自动化指标、人工评估和用户反馈,识别质量问题(如幻觉),指导模型微调、RLHF 或提示词调整。

实现数据驱动优化需要定义清晰的业务与技术KPI,建立全面的日志记录和监控系统,并集成实验(A/B测试)框架。

自动扩缩容:弹性应对动态负载

LLM工作负载通常计算密集且需求波动大(如一天中的高峰期或特定营销活动)。自动扩缩容是平衡性能和成本的关键手段。

需求与目标:

- 根据实时负载动态调整计算资源(增加/减少实例)。

- 低负载时缩减资源(甚至缩减到零)以节省成本,高负载时快速扩容确保服务可用性和低延迟。

- 维持特定的性能SLA。

关键指标:

- 服务器/应用级别:队列长度(等待处理的请求数)、并发请求数、请求率(RPS)、响应时间。这些指标能更直接反映系统压力和用户体验。

- 硬件级别:GPU/TPU利用率、显存使用率。虽然常用,但可能不如应用层指标准确反映LLM工作负载的真实压力。

机制与平台:

- Kubernetes HPA:基于CPU、内存或自定义指标(如队列长度)扩缩Pod副本数。

- 云平台托管服务:AWS SageMaker、Google Vertex AI、Azure ML等提供针对LLM推理端点的自动扩缩容功能,支持GPU实例和缩减到零。

- Serverless GPU平台:提供按需、内置自动扩缩容的推理服务。

配置与调优:需要根据实际负载测试确定合适的扩缩容阈值、稳定窗口(避免频繁震荡)和扩缩容策略。挑战包括冷启动延迟、资源碎片化和成本预测。

通过自动扩缩容,企业可以显著提高LLM系统的成本效率,同时保持高可用性和响应性。

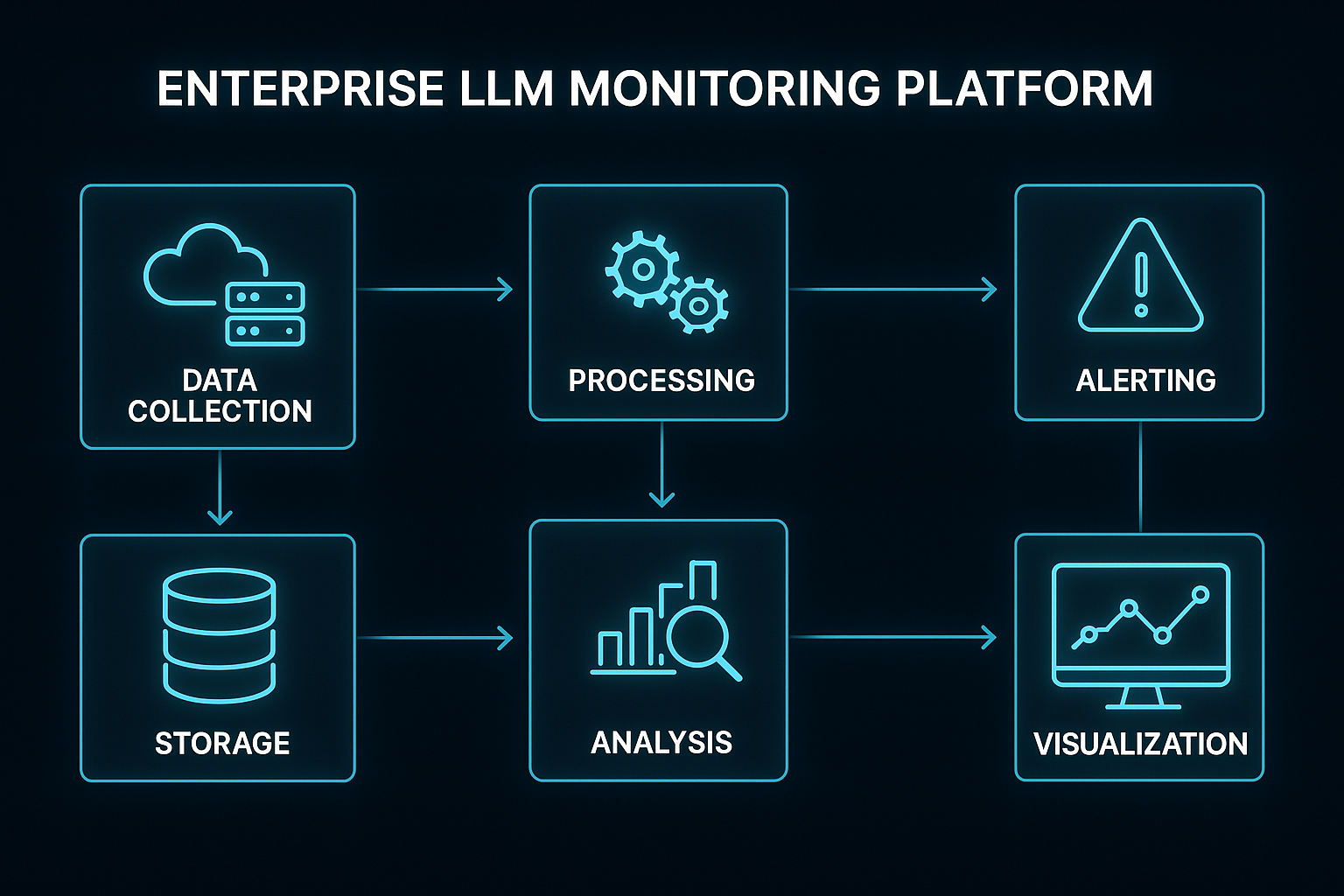

构建智能监控平台:整合与赋能

一个理想的企业级LLM监控平台需要将上述各项能力整合到一个统一的平台中,提供全面的可见性和智能化的管理功能。

核心设计理念:

- 统一视图:整合基础设施、应用、模型和用户各层面的遥测数据。

- 端到端可见性:提供从用户输入到最终输出的全链路洞察。

- 可操作的洞察:不仅展示数据,还通过分析提供解决问题的建议。

- 自动化与智能化:利用AI和ML技术进行异常检测、预测性维护、根因分析辅助和自动化操作。

- 全生命周期覆盖:支持从开发、测试到生产运营的模型和应用管理。

关键功能与特性:

- 全面的数据收集与管理:支持多源(应用、模型、API、基础设施)日志、指标、追踪的收集、规范化、存储和索引。

- 实时监控与可视化:灵活可定制的仪表盘,展示关键KPIs,支持多维度数据下钻与切片。

- 智能告警系统:基于细粒度LLM指标和异常检测结果触发告警,提供告警上下文和根因分析辅助。

- LLM特定分析工具:提示词性能分析、响应质量评估、Token消耗追踪、模型漂移检测与分析。

- 异常检测与根因分析:自动化异常检测,将异常与追踪、日志关联,提供RCA辅助。

- 预测性分析:预测负载、性能瓶颈、模型漂移等潜在风险。

- 数据驱动优化支持:集成A/B测试框架,提供优化建议,支持自动化策略调整(如动态路由)。

- 自动扩缩容集成:与底层基础设施或容器编排平台协同,根据LLM工作负载特征进行智能扩缩容。

- 安全与合规监控:恶意提示检测、安全过滤结果监控、访问审计。

- 用户反馈与评估整合:收集、分析用户反馈,支持人工评估工作流。

- 开放性与可扩展性:支持标准协议(如OpenTelemetry),提供API和SDK,易于与现有工具链集成。

当前市场上有多种工具正在努力提供LLM特定的监控能力,包括专注于LLM可观测性的Langfuse, Traceloop, Helicone, LangSmith;更广泛的AI可观测性平台如WhyLabs, Arize AI;以及云平台提供的原生监控服务。企业需要根据自身需求选择或构建合适的平台。

结论与展望

企业级LLM系统监控是一个复杂但至关重要的领域。它需要将传统的软件监控理念与LLM特有的可观测性需求相结合,构建一个多维度、系统性的框架。

核心要点回顾:

- 可观测性是基础,通过日志、指标、追踪及用户反馈,提供对LLM系统内部运行状态的深入洞察。

- 全链路追踪对于理解复杂的多阶段LLM管道至关重要,是定位性能瓶颈和调试的利器。

- 性能监控关注延迟、吞吐量和资源效率,通过软硬件优化和持续监控实现性能提升。

- 成本分析分解运营开销,指导成本优化策略,利用监控数据实现精细化成本管理。

- 异常检测保障系统稳定性和模型质量,及时发现输入/输出问题和操作异常。

- 预测性维护通过数据分析预见基础设施故障和模型漂移风险,支持主动干预。

- 数据驱动优化利用监控数据指导提示词、模型、参数的选择与调整,实现持续改进。

- 自动扩缩容确保系统在动态负载下保持可用性和成本效益。

- 智能监控平台是整合上述能力的统一平台,提供可视化、智能分析和自动化功能。

尽管仍面临如模型可解释性、复杂质量指标自动化、数据隐私等挑战,但随着技术的不断发展,LLM监控正朝着更智能、更自动化、更全面的方向演进。未来,我们将看到更强的因果分析能力、多模态LLM监控、隐私保护监控技术以及与生成式AI应用更紧密集成的监控平台。

通过积极投入LLM系统的可观测性与智能监控平台建设,企业能够显著提升其LLM应用的稳定性、性能、成本效益和可信度,从而更自信地 leveraging 这一颠覆性技术,驱动业务创新和增长。