网页版:https://idedayaq.gensparkspace.com

视频版:https://www.youtube.com/watch?v=HwLAC6dD658

音频版:https://notebooklm.google.com/notebook/5ae860f6-c37a-4836-87c7-de589089aaf8/audio

引言

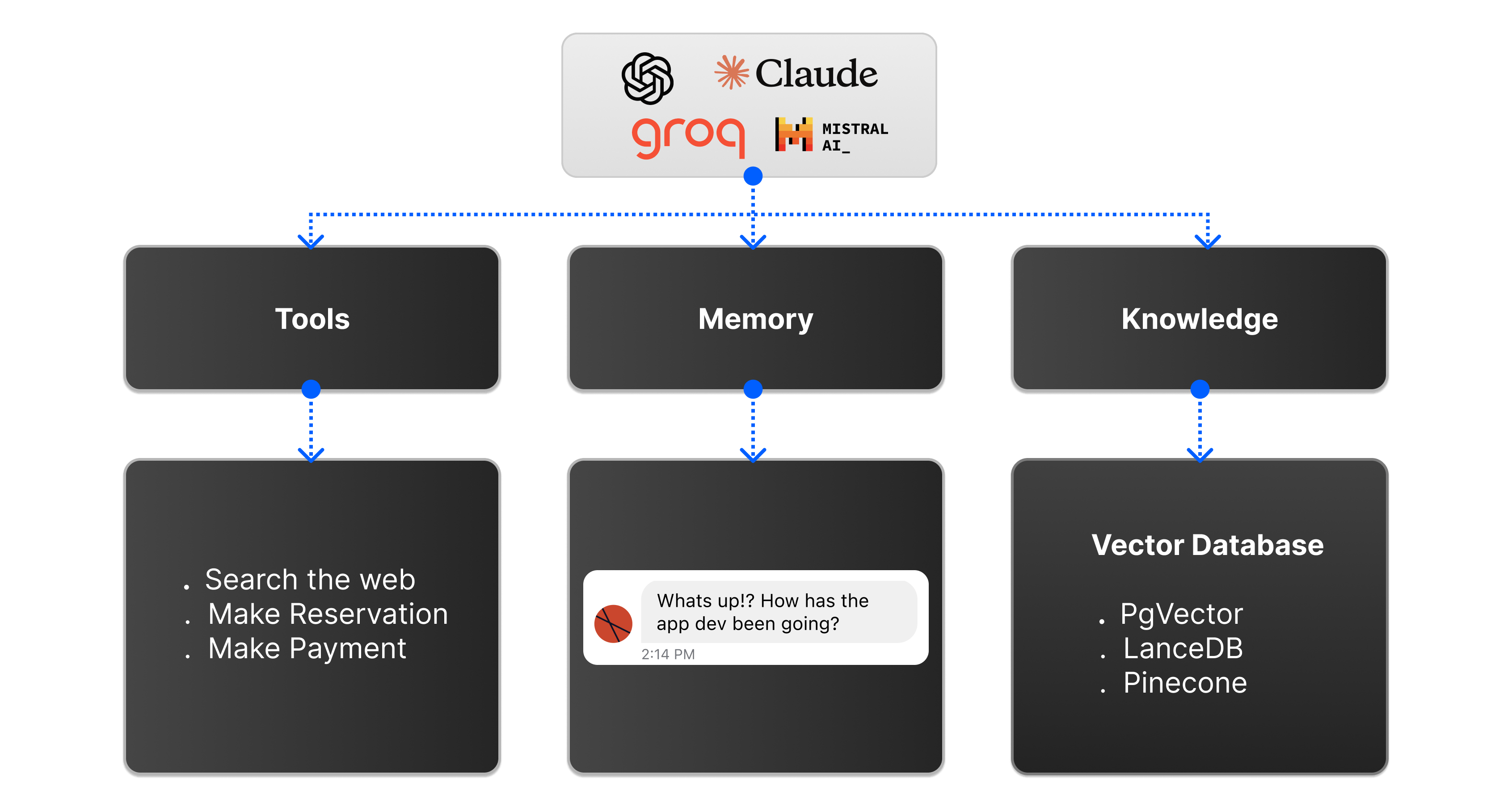

随着人工智能技术的飞速发展,基于大语言模型(LLM)的智能体(Agent)已经成为AI领域的热点话题。这些智能体不再是简单的对话系统,而是能够自主思考、规划和执行任务的复杂系统。然而,单一智能体在面对复杂任务时往往力不从心,这促使研究人员开始探索多智能体协作系统。分布式智能体系统作为一种前沿解决方案,正在彻底改变AI在企业和科研领域的应用方式。

本文将深入探讨分布式智能体系统的架构设计、状态同步机制、任务调度策略、跨地域协同方法,以及未来与量子计算的结合前景,为读者提供全面的技术视角和实践指导。

1. 分布式智能体:概念与意义

1.1 什么是分布式智能体

分布式智能体系统是指由多个自主智能体组成的网络,这些智能体分布在不同的物理或逻辑节点上,通过协作来完成复杂任务。与传统的单一智能体相比,分布式智能体系统具有更强的可扩展性、容错性和任务处理能力。

每个智能体都是一个独立的实体,具备特定的能力和知识,可以根据自身的专长处理不同类型的任务。系统通过精心设计的通信和协调机制,使这些智能体能够高效协作,实现单个智能体无法完成的复杂目标。

1.2 分布式智能体的核心优势

- 专业化分工:不同智能体可以专注于擅长的领域,例如数据分析、内容生成、代码编写等

- 并行处理能力:多个智能体可以同时处理不同子任务,大幅提高整体效率

- 系统弹性:单个智能体失效不会导致整个系统崩溃,提高了系统稳定性

- 资源优化:可以根据任务需求动态分配计算资源,实现资源的高效利用

- 跨领域协作:不同专长的智能体可以协同工作,解决跨领域复杂问题

1.3 应用场景

分布式智能体系统在多个领域展现出巨大潜力:

- 企业智能决策:多个专家型智能体协作分析市场数据、财务报表和竞争情报

- 科学研究:协作处理大规模科学数据、模拟实验和分析结果

- 软件开发:不同智能体负责需求分析、代码生成、测试和部署等环节

- 智能客服:一级智能体处理简单查询,复杂问题自动路由到专业智能体

- 网络安全:多个安全智能体协作监控、分析威胁和实施防御措施

2. 主流分布式智能体架构模式

2.1 DAWN架构:全球分布式智能体网络

DAWN (Distributed Agents in a Worldwide Network) 是一个为分布式智能体协作设计的强大框架,由研究人员于2024年提出。它解决了全球分布式智能体发现、连接和协作的关键挑战。

DAWN的核心组件

-

Principal Agent(主体智能体):

- 作为系统的中央编排器

- 解析用户请求并制定任务执行计划

- 将任务分解为可管理的子任务

- 向Gateway Agents请求所需资源

- 评估和选择最适合的资源执行任务

-

Gateway Agents(网关智能体):

- 分布于全球各地

- 维护资源(工具、智能体、应用)注册表

- 负责资源匹配、测试和提供

- 通过标准REST API暴露服务

-

Orchestration Layer(编排层):

- 支持多种操作模式(No-LLM、Copilot、Agent)

- 确保任务按预定流程顺序执行

- 管理全局状态和执行图

-

Communication Layer(通信层):

- 管理各组件之间的消息传递

- 确保消息被正确解析、解释和路由

-

Context Layer(上下文层):

- 维持系统记忆和任务相关上下文

- 包含推理草稿、消息池和长期记忆库

-

Security, Safety and Compliance Layer(安全与合规层):

- 为系统提供安全基础

- 实施传统安全措施和LLM特有安全防护

DAWN的运行模式

DAWN提供三种主要运行模式,以适应不同的任务要求:

- No-LLM模式:适用于需要高度确定性和可预测性的任务,依赖传统算法和工具

- Copilot模式:智能体作为助手,增强确定性工作流程,提供创造性输入

- LLM Agent模式:智能体完全自主运行,基于复杂推理和实时数据做出决策

这种灵活的设计使DAWN能够满足从高度确定性到完全自主的各种应用场景需求。

2.2 Microsoft AutoGen:跨进程智能体协作框架

AutoGen是微软开发的开源框架,专注于构建多智能体系统和促进智能体之间的协作。它的分布式智能体运行时是一个实验性功能,用于跨进程边界管理通信和智能体生命周期。

AutoGen分布式架构的主要组件

-

Host Service(主机服务):

- 维护与所有活动工作运行时的连接

- 促进消息传递

- 保存所有直接消息的会话

-

Worker Runtime(工作者运行时):

- 处理应用程序代码(智能体)

- 连接到主机服务

- 向主机服务广播其支持的智能体

这种架构使AutoGen能够在不同进程甚至不同机器上运行智能体,实现真正的分布式计算。

跨语言智能体协作

AutoGen的一个显著特点是支持跨语言智能体协作。为了实现这一点,所有消息类型必须使用共享的protobuf模式,这样不同编程语言实现的智能体也能无缝通信。

# 创建主机服务

from autogen_ext.runtimes.grpc import GrpcWorkerAgentRuntimeHost

host = GrpcWorkerAgentRuntimeHost(address="localhost:50051")

host.start() # 在后台启动主机服务

# 设置工作者运行时

import asyncio

from autogen_ext.runtimes.grpc import GrpcWorkerAgentRuntime

worker1 = GrpcWorkerAgentRuntime(host_address="localhost:50051")

await worker1.start()

await MyAgent.register(worker1, "worker1", lambda: MyAgent("worker1"))

worker2 = GrpcWorkerAgentRuntime(host_address="localhost:50051")

await worker2.start()

await MyAgent.register(worker2, "worker2", lambda: MyAgent("worker2"))

2.3 其他主流框架

除了DAWN和AutoGen外,还有多个开源框架支持构建分布式智能体系统:

-

LangGraph:

- 基于节点的多智能体框架

- 允许通过节点和边构建工作流

- 支持线性、层级和循环工作流

-

CrewAI:

- 提供团队协作模式的多智能体框架

- 专注于角色分配和协作策略

- 与700多个应用程序集成

-

Agno(原Phidata):

- 提供内置的智能体UI

- 支持云服务部署

- 可监控关键指标

每个框架都有其独特优势,可根据具体项目需求选择合适的技术栈。

3. 状态同步机制

分布式智能体系统中,不同节点上的智能体需要保持状态一致性,这对系统的正常运行至关重要。状态同步确保所有智能体对共享数据有一致的视图,减少冲突和错误。

3.1 状态同步的挑战

分布式环境中的状态同步面临多种挑战:

- 网络延迟:不同地理位置的节点之间通信存在延迟

- 部分失败:部分节点可能暂时不可用

- 冲突解决:并发更新可能导致状态冲突

- 一致性与可用性平衡:根据CAP理论,需要在一致性和可用性之间做出取舍

3.2 同步策略与实现方法

3.2.1 锁机制(Locks/Mutexes)

锁是基本的同步原语,确保一次只有一个进程或线程持有锁,从而限制对共享资源的访问:

# 使用Python的threading模块实现互斥锁

import threading

class DistributedAgent:

def __init__(self):

self.shared_state = {}

self.lock = threading.Lock()

def update_state(self, key, value):

with self.lock: # 获取锁

self.shared_state[key] = value

# 执行状态更新

# 释放锁

在分布式系统中,可以使用分布式锁服务如Redis、ZooKeeper或etcd实现类似功能。

3.2.2 消息传递同步

智能体通过发送和接收消息来协调活动和同步状态:

# 简化的消息传递示例

class AgentNode:

def __init__(self, node_id):

self.node_id = node_id

self.state = {}

self.message_queue = []

def send_state_update(self, recipient, key, value):

message = {

"type": "STATE_UPDATE",

"sender": self.node_id,

"key": key,

"value": value

}

# 将消息发送给接收者

recipient.receive_message(message)

def receive_message(self, message):

if message["type"] == "STATE_UPDATE":

self.state[message["key"]] = message["value"]

实际实现中通常会使用消息队列技术如RabbitMQ、Kafka或Amazon SQS。

3.2.3 两阶段提交协议(2PC)

两阶段提交是保证分布式事务原子性的经典协议,由准备和提交两个阶段组成:

- 准备阶段:协调者询问参与者是否能够执行事务,参与者锁定资源并回答准备就绪或拒绝

- 提交阶段:如果所有参与者都已准备好,协调者发送提交命令;否则发送中止命令

// Java中两阶段提交协议的简化实现

public class TransactionCoordinator {

// 发送准备请求给参与者

public List<CompletableFuture<Boolean>> sendPrepareRequestToParticipants(TransactionRef txnRef) {

var participants = getParticipants(txnRef);

return participants.stream()

.map(server -> server.prepareTransaction(txnRef))

.collect(Collectors.toList());

}

// 向参与者发送提交消息

private void sendCommitMessageToParticipants(TransactionRef txnRef) {

var participants = getParticipants(txnRef);

participants.forEach(participant -> participant.commitTransaction(txnRef));

}

}

3.2.4 三阶段提交协议(3PC)

三阶段提交协议是两阶段提交的改进版,增加了一个预提交阶段,解决了两阶段提交中的阻塞问题:

- 询问阶段(CanCommit):协调者询问参与者是否可以提交事务

- 预提交阶段(PreCommit):协调者告知参与者准备提交

- 提交阶段(DoCommit):协调者发送最终提交命令

这种设计允许参与者在协调者失效时能够集体决定事务结果。

3.3 事件驱动状态同步

事件驱动架构是分布式智能体系统中状态同步的有效方法,通过发布-订阅模式实现:

# 事件驱动状态同步示例

class EventDrivenAgent:

def __init__(self, agent_id, event_bus):

self.agent_id = agent_id

self.state = {}

self.event_bus = event_bus

# 订阅状态更新事件

self.event_bus.subscribe("STATE_CHANGED", self.handle_state_change)

def update_state(self, key, value):

self.state[key] = value

# 发布状态变更事件

self.event_bus.publish("STATE_CHANGED", {

"agent_id": self.agent_id,

"key": key,

"value": value

})

def handle_state_change(self, event):

if event["agent_id"] != self.agent_id: # 不处理自己的事件

self.state[event["key"]] = event["value"]

4. 任务调度策略

在分布式智能体系统中,任务调度涉及将任务分配给最合适的智能体,并确保这些任务高效执行。有效的任务调度对系统性能和资源利用率至关重要。

4.1 调度器-智能体-监督者模式

调度器-智能体-监督者(Scheduling Agent Supervisor)模式是分布式系统中常用的任务调度设计模式,它将任务调度与任务执行分离,提高系统的可扩展性和容错性。

核心组件

-

调度器(Scheduler):

- 管理任务队列并分配任务给可用智能体

- 基于智能体可用性、工作负载或优先级分配任务

- 确保任务按适当时间和优化方式执行

-

智能体(Agents):

- 接收调度器分配的任务并执行

- 向监督者报告成功或失败

- 可以水平扩展以处理不同工作负载

-

监督者(Supervisor):

- 监控智能体健康状况、可用性和任务进度

- 在智能体失败或遇到问题时重新分配任务

- 确保系统通过处理智能体失败或过载保持容错

-

任务队列(Task Queue):

- 临时存储等待被智能体处理的任务

- 以结构化方式管理任务,防止过载或瓶颈

4.2 实现策略

4.2.1 基于任务队列的方法

# 基于任务队列的调度实现

import queue

class TaskQueue:

def __init__(self):

self.queue = queue.PriorityQueue()

def enqueue_task(self, task, priority=0):

self.queue.put((priority, task))

def dequeue_task(self):

if not self.queue.empty():

_, task = self.queue.get()

return task

return None

class Scheduler:

def __init__(self):

self.task_queue = TaskQueue()

self.agents = []

def register_agent(self, agent):

self.agents.append(agent)

def schedule_task(self, task, priority=0):

self.task_queue.enqueue_task(task, priority)

self.assign_tasks()

def assign_tasks(self):

available_agents = [agent for agent in self.agents if agent.is_available()]

while available_agents:

task = self.task_queue.dequeue_task()

if task is None:

break

agent = self.select_best_agent(available_agents, task)

agent.assign_task(task)

available_agents.remove(agent)

4.2.2 主-工作者模型

主-工作者(Master-Worker)模型中,调度器作为主节点,智能体作为工作者:

# 主-工作者模型简单实现

class Master:

def __init__(self):

self.workers = {}

self.tasks = []

self.task_assignments = {}

def register_worker(self, worker_id, worker):

self.workers[worker_id] = worker

def add_task(self, task):

self.tasks.append(task)

def schedule_tasks(self):

for task in self.tasks[:]:

for worker_id, worker in self.workers.items():

if worker.is_available() and worker.can_handle(task):

worker.assign_task(task)

self.task_assignments[task.id] = worker_id

self.tasks.remove(task)

break

4.2.3 分布式调度与去中心化智能体

在去中心化模型中,多个分布式调度器协调任务分布,智能体通过点对点通信合作:

# 去中心化调度示例

class DistributedScheduler:

def __init__(self, scheduler_id, peer_schedulers=None):

self.scheduler_id = scheduler_id

self.peer_schedulers = peer_schedulers or []

self.local_agents = []

self.local_tasks = []

def add_peer_scheduler(self, scheduler):

self.peer_schedulers.append(scheduler)

def register_local_agent(self, agent):

self.local_agents.append(agent)

def add_task(self, task):

# 先尝试本地调度

if self.schedule_locally(task):

return True

# 本地无法处理,尝试分发给对等调度器

return self.distribute_task(task)

def schedule_locally(self, task):

for agent in self.local_agents:

if agent.is_available() and agent.can_handle(task):

agent.assign_task(task)

return True

return False

def distribute_task(self, task):

for peer in self.peer_schedulers:

if peer.add_task(task):

return True

return False

4.3 心跳机制与故障恢复

监督者通过心跳机制监控智能体状态,当智能体失败时重新分配任务:

# 简化的心跳机制

import time

import threading

class AgentSupervisor:

def __init__(self, heartbeat_timeout=30): # 超时时间(秒)

self.agents = {} # {agent_id: (agent, last_heartbeat_time)}

self.heartbeat_timeout = heartbeat_timeout

self.monitor_thread = threading.Thread(target=self.monitor_heartbeats)

self.monitor_thread.daemon = True

self.monitor_thread.start()

def register_agent(self, agent_id, agent):

self.agents[agent_id] = (agent, time.time())

def receive_heartbeat(self, agent_id):

if agent_id in self.agents:

agent, _ = self.agents[agent_id]

self.agents[agent_id] = (agent, time.time())

def monitor_heartbeats(self):

while True:

current_time = time.time()

failed_agents = []

for agent_id, (agent, last_heartbeat) in list(self.agents.items()):

if current_time - last_heartbeat > self.heartbeat_timeout:

failed_agents.append((agent_id, agent))

for agent_id, agent in failed_agents:

self.handle_agent_failure(agent_id, agent)

time.sleep(5) # 检查间隔

def handle_agent_failure(self, agent_id, agent):

print(f"Agent {agent_id} failed! Reassigning its tasks...")

# 获取失败智能体的任务并重新分配

tasks = agent.get_assigned_tasks()

for task in tasks:

self.reassign_task(task)

# 从注册表中移除失败的智能体

self.agents.pop(agent_id, None)

def reassign_task(self, task):

# 重新分配任务给其他可用智能体

for agent_id, (agent, _) in self.agents.items():

if agent.is_available() and agent.can_handle(task):

agent.assign_task(task)

return True

return False

5. 跨地域协同

随着组织的全球化扩展,分布式智能体系统需要支持跨地域协作,让位于不同地理位置的智能体能够高效协同工作。

5.1 跨地域协作的挑战

- 高延迟:不同地理位置之间的网络延迟增加

- 带宽限制:跨地域网络连接的带宽通常低于局域网

- 数据一致性:维持全球分布式系统的数据一致性更加困难

- 法规合规:不同地区的数据隐私法规可能有所不同

5.2 DAWN框架的跨地域协同方案

DAWN框架专为全球分布式智能体协作设计,提供了强大的跨地域协同功能:

- Gateway Agents网络:不同地区部署Gateway Agents,提供本地资源注册和管理

- 开放协议:使用开放协议实现不同地区Gateway Agents之间的互联

- Principal Agent编排:具有全局视角的Principal Agent协调不同地区的资源

5.3 跨地域消息传递

高效的跨地域消息传递是实现全球分布式智能体协作的关键:

# 跨地域消息传递示例

class RegionalMessageBroker:

def __init__(self, region_id, peer_brokers=None):

self.region_id = region_id

self.peer_brokers = peer_brokers or {} # {region_id: broker}

self.local_subscribers = {} # {topic: [subscriber]}

def add_peer_broker(self, region_id, broker):

self.peer_brokers[region_id] = broker

def subscribe(self, topic, subscriber):

if topic not in self.local_subscribers:

self.local_subscribers[topic] = []

self.local_subscribers[topic].append(subscriber)

def publish_local(self, topic, message):

if topic in self.local_subscribers:

for subscriber in self.local_subscribers[topic]:

subscriber.receive_message(message)

def publish_global(self, topic, message):

# 本地发布

self.publish_local(topic, message)

# 转发到其他区域的代理

for region_id, broker in self.peer_brokers.items():

# 避免消息循环

if "origin_region" not in message:

message["origin_region"] = self.region_id

elif message["origin_region"] == self.region_id:

continue

broker.publish_local(topic, message)

5.4 数据分区与复制策略

为了提高跨地域系统的性能和可用性,通常采用数据分区和复制策略:

- 数据分区:根据地理位置或其他标准将数据划分到不同区域

- 本地优先访问:智能体优先访问本地数据,减少跨区域通信

- 选择性复制:只复制频繁访问或关键数据到多个区域

- 异步复制:使用异步复制减少对应用性能的影响

# 数据分区与复制示例

class GlobalDataManager:

def __init__(self):

self.regional_data_stores = {} # {region_id: data_store}

self.data_partitions = {} # {data_key: primary_region}

self.replication_policy = {} # {data_key: [replica_regions]}

def register_region(self, region_id, data_store):

self.regional_data_stores[region_id] = data_store

def set_partition(self, data_key, primary_region):

self.data_partitions[data_key] = primary_region

def set_replication_policy(self, data_key, replica_regions):

self.replication_policy[data_key] = replica_regions

def write_data(self, data_key, value):

if data_key not in self.data_partitions:

raise KeyError(f"No partition defined for data key: {data_key}")

# 写入主区域

primary_region = self.data_partitions[data_key]

if primary_region not in self.regional_data_stores:

raise KeyError(f"Primary region not found: {primary_region}")

primary_store = self.regional_data_stores[primary_region]

primary_store.write(data_key, value)

# 异步复制到副本区域

if data_key in self.replication_policy:

for replica_region in self.replication_policy[data_key]:

if replica_region in self.regional_data_stores:

# 实际实现中应该是异步的

self.regional_data_stores[replica_region].write(data_key, value)

def read_data(self, data_key, requesting_region):

# 优先从本地读取

if requesting_region in self.regional_data_stores:

local_store = self.regional_data_stores[requesting_region]

if local_store.has_data(data_key):

return local_store.read(data_key)

# 从主区域读取

if data_key in self.data_partitions:

primary_region = self.data_partitions[data_key]

if primary_region in self.regional_data_stores:

return self.regional_data_stores[primary_region].read(data_key)

raise KeyError(f"Data not found: {data_key}")

6. 量子加速接口预留

随着量子计算技术的发展,将量子计算能力集成到分布式智能体系统中可以实现前所未有的性能提升。预留量子加速接口是为未来技术发展做准备的战略举措。

6.1 量子计算与AI的结合优势

量子计算在特定类型的问题上可以显著加速AI系统:

- 高维空间处理:量子计算机可以高效处理高维数据和复杂模式识别

- 优化问题:在规划、调度和资源分配等优化问题上表现出色

- 模拟复杂系统:可以模拟复杂的量子系统,促进新材料和药物研发

- 机器学习加速:量子机器学习算法可以显著加速训练和推理过程

6.2 量子增强分布式智能体

量子增强的分布式智能体系统可以在多个方面提升性能:

6.2.1 量子多智能体强化学习

# 量子多智能体强化学习框架示例

class QuantumEnhancedMultiAgentRL:

def __init__(self, n_agents, n_qubits_per_agent):

self.n_agents = n_agents

self.n_qubits_per_agent = n_qubits_per_agent

self.quantum_states = [None] * n_agents # 代表量子状态

self.classical_policies = [None] * n_agents # 经典策略网络

def create_quantum_circuit(self, agent_id):

"""创建量子电路接口,实际实现将依赖量子硬件"""

# 此处为接口预留

pass

def entangle_agents(self, agent_ids):

"""使特定智能体之间的量子位纠缠,促进协作"""

# 此处为接口预留

pass

def quantum_policy_optimization(self):

"""使用量子算法优化策略"""

# 此处为接口预留

pass

def quantum_enhanced_action_selection(self, agent_id, state):

"""使用量子计算增强的动作选择过程"""

# 此处为接口预留

# 实际实现可能结合经典和量子方法

return self.classical_policies[agent_id].select_action(state)

6.2.2 量子启发式搜索与规划

分布式智能体系统中的任务规划和优化可以利用量子算法获得显著加速:

# 量子启发式搜索框架示例

class QuantumEnhancedPlanner:

def __init__(self, quantum_processor_interface=None):

self.quantum_processor = quantum_processor_interface

# 如果量子处理器不可用,则使用经典算法模拟

self.use_quantum = (quantum_processor_interface is not None)

def solve_optimization_problem(self, problem_definition):

if self.use_quantum:

# 调用量子处理器接口

return self.quantum_processor.solve_qubo(self.convert_to_qubo(problem_definition))

else:

# 使用经典算法

return self.solve_classically(problem_definition)

def convert_to_qubo(self, problem_definition):

"""将问题转换为二次无约束二元优化(QUBO)格式"""

# 此处为接口预留

pass

def solve_classically(self, problem_definition):

"""使用经典算法求解"""

# 经典回退实现

pass

6.3 接口设计与实现策略

为了确保分布式智能体系统能够无缝集成未来的量子计算能力,需要采用适当的接口设计策略:

6.3.1 抽象接口层

创建一个抽象接口层,将量子特定实现与系统其余部分隔离:

# 量子加速接口抽象层

class QuantumAccelerator:

"""量子加速器的抽象接口"""

def optimize_function(self, objective_function, constraints=None):

"""优化给定的目标函数"""

raise NotImplementedError

def sample_distribution(self, distribution_params):

"""从给定分布中采样"""

raise NotImplementedError

def solve_linear_system(self, matrix_A, vector_b):

"""求解线性方程组Ax=b"""

raise NotImplementedError

def is_available(self):

"""检查量子加速器是否可用"""

raise NotImplementedError

class ClassicalFallbackAccelerator(QuantumAccelerator):

"""使用经典算法实现量子加速器接口的回退实现"""

def optimize_function(self, objective_function, constraints=None):

# 使用经典优化算法

pass

def sample_distribution(self, distribution_params):

# 使用经典采样方法

pass

def solve_linear_system(self, matrix_A, vector_b):

# 使用经典线性代数

import numpy as np

return np.linalg.solve(matrix_A, vector_b)

def is_available(self):

return True

class QuantumHardwareAccelerator(QuantumAccelerator):

"""连接实际量子硬件的实现"""

def __init__(self, provider, device_id=None):

self.provider = provider

self.device_id = device_id

self._initialize_connection()

def _initialize_connection(self):

# 初始化与量子硬件的连接

pass

def optimize_function(self, objective_function, constraints=None):

# 使用量子算法优化

pass

def sample_distribution(self, distribution_params):

# 使用量子硬件采样

pass

def solve_linear_system(self, matrix_A, vector_b):

# 使用量子线性系统算法(HHL)

pass

def is_available(self):

# 检查量子硬件连接状态

pass

6.3.2 适配器模式

使用适配器模式将不同的量子计算库和服务集成到系统中:

# 量子计算库适配器

class QiskitAdapter(QuantumAccelerator):

"""IBM Qiskit量子计算库的适配器"""

def __init__(self, backend_name=None):

# 初始化Qiskit

try:

from qiskit import Aer, IBMQ

if backend_name and IBMQ.active_account():

provider = IBMQ.get_provider()

self.backend = provider.get_backend(backend_name)

else:

# 使用本地模拟器作为后备

self.backend = Aer.get_backend('qasm_simulator')

self._available = True

except ImportError:

self._available = False

def is_available(self):

return self._available

# 其他方法的具体实现...

6.4 渐进式量子集成策略

考虑到量子计算技术仍在发展中,采用渐进式集成策略是明智的:

- 混合经典-量子方法:开始时将量子算法用于特定计算密集型子任务

- 可变精度方法:根据任务需求动态调整是否使用量子计算

- 功能等价性:确保所有功能都有经典算法实现作为后备

- 性能基准测试:持续评估量子解决方案相对于经典方法的性能增益

# 混合经典-量子处理器

class HybridProcessor:

def __init__(self):

self.quantum_accelerator = self._initialize_quantum_accelerator()

self.classical_processor = ClassicalFallbackAccelerator()

def _initialize_quantum_accelerator(self):

# 尝试初始化不同的量子加速器

accelerators = [

lambda: QiskitAdapter(),

lambda: PennyLaneAdapter(),

lambda: AwsQuantumAdapter(),

# 添加更多适配器...

]

for create_accelerator in accelerators:

try:

accelerator = create_accelerator()

if accelerator.is_available():

return accelerator

except Exception:

continue

# 如果没有可用的量子加速器,返回None

return None

def process_task(self, task, force_classical=False):

"""处理给定任务,可选择强制使用经典处理"""

# 决定是否使用量子加速

use_quantum = (

not force_classical and

self.quantum_accelerator is not None and

self.is_quantum_suitable(task)

)

if use_quantum:

try:

return self.process_with_quantum(task)

except Exception:

# 量子处理失败时回退到经典处理

return self.process_with_classical(task)

else:

return self.process_with_classical(task)

def is_quantum_suitable(self, task):

"""评估任务是否适合量子处理"""

# 基于任务特性、规模、期望精度等因素决定

pass

def process_with_quantum(self, task):

"""使用量子加速器处理任务"""

pass

def process_with_classical(self, task):

"""使用经典处理器处理任务"""

pass

7. 案例研究与实践指南

7.1 分布式智能体系统实现示例:跨地域协作数据分析

以下是一个简化的跨地域协作数据分析系统实现示例:

# 跨地域数据分析系统示例

# 定义区域智能体

class RegionalAnalysisAgent:

def __init__(self, region_id, data_source):

self.region_id = region_id

self.data_source = data_source

self.local_results = {}

def perform_local_analysis(self, analysis_task):

"""执行本地数据分析"""

data = self.data_source.get_data()

# 执行分析...

results = self.analyze_data(data, analysis_task)

self.local_results[analysis_task.id] = results

return results

def analyze_data(self, data, task):

"""根据任务类型分析数据"""

# 实际实现根据不同分析类型处理...

return {"region": self.region_id, "summary": "分析结果..."}

# 定义协调智能体

class GlobalCoordinatorAgent:

def __init__(self):

self.regional_agents = {}

self.global_results = {}

def register_regional_agent(self, region_id, agent):

self.regional_agents[region_id] = agent

def coordinate_global_analysis(self, analysis_task):

"""协调全球分析任务"""

all_results = []

# 分发任务给所有区域智能体

for region_id, agent in self.regional_agents.items():

regional_result = agent.perform_local_analysis(analysis_task)

all_results.append(regional_result)

# 聚合和综合区域结果

global_result = self.aggregate_results(analysis_task, all_results)

self.global_results[analysis_task.id] = global_result

return global_result

def aggregate_results(self, task, regional_results):

"""聚合各区域结果"""

# 实际实现根据任务类型进行聚合...

return {

"task_id": task.id,

"regional_results": regional_results,

"global_summary": "全球分析结论..."

}

# 使用量子加速的数据分析示例

class QuantumEnhancedAnalysis:

def __init__(self, quantum_accelerator=None):

self.quantum_accelerator = quantum_accelerator or ClassicalFallbackAccelerator()

def pattern_recognition(self, data):

"""使用量子增强模式识别"""

if self.quantum_accelerator.is_available():

# 使用量子算法

return self.quantum_pattern_recognition(data)

else:

# 回退到经典算法

return self.classical_pattern_recognition(data)

def quantum_pattern_recognition(self, data):

"""量子增强模式识别算法"""

# 接口预留

pass

def classical_pattern_recognition(self, data):

"""经典模式识别算法"""

# 经典实现

pass

7.2 部署与运维最佳实践

成功部署和运维分布式智能体系统需要遵循一系列最佳实践:

- 智能体隔离:使用容器技术(如Docker)隔离每个智能体,确保独立运行

- 监控与可观测性:实施全面监控,包括智能体状态、消息流和资源使用

- 自动扩展:根据负载动态调整智能体实例数量

- 版本控制:实施智能体版本控制策略,确保兼容性

- 灾难恢复:制定完善的备份和恢复策略

# Docker Compose示例配置

version: '3'

services:

principal-agent:

image: distributed-agents/principal-agent:latest

ports:

- "8080:8080"

environment:

- CONFIG_PATH=/app/config/principal.yaml

volumes:

- ./config:/app/config

depends_on:

- gateway-agent-1

- gateway-agent-2

gateway-agent-1:

image: distributed-agents/gateway-agent:latest

ports:

- "8081:8080"

environment:

- REGION=us-east

- CONFIG_PATH=/app/config/gateway-us.yaml

volumes:

- ./config:/app/config

gateway-agent-2:

image: distributed-agents/gateway-agent:latest

ports:

- "8082:8080"

environment:

- REGION=asia-east

- CONFIG_PATH=/app/config/gateway-asia.yaml

volumes:

- ./config:/app/config

monitoring:

image: prometheus:latest

ports:

- "9090:9090"

volumes:

- ./monitoring/prometheus.yml:/etc/prometheus/prometheus.yml

visualization:

image: grafana/grafana:latest

ports:

- "3000:3000"

volumes:

- ./monitoring/grafana:/var/lib/grafana

depends_on:

- monitoring

7.3 性能优化技巧

提高分布式智能体系统性能的几个关键技巧:

- 消息批处理:批量处理多个消息而非单独处理每条消息

- 本地缓存:在智能体本地缓存频繁访问的数据

- 异步通信:使用异步通信模式减少等待时间

- 负载均衡:均匀分配工作负载,避免某些智能体成为瓶颈

- 资源隔离:确保关键智能体获得足够的计算资源

8. 未来展望与挑战

8.1 技术发展趋势

分布式智能体系统的几个主要发展趋势:

- 自组织智能体网络:更高度的自主性和自我管理能力

- 人类-智能体混合团队:智能体作为团队成员与人类协同工作

- 专用硬件加速:针对AI和智能体优化的专用硬件

- 多模态智能体:能够处理文本、图像、音频等多种模态数据的智能体

- 联邦智能体学习:保护隐私的分布式学习方法

8.2 持续挑战

尽管前景光明,分布式智能体系统仍面临多项挑战:

- 安全与隐私:确保系统安全性和用户数据隐私

- 可解释性:提高智能体决策的可解释性和透明度

- 伦理考量:解决与自主智能体相关的伦理问题

- 系统复杂性:管理分布式系统固有的复杂性

- 能源效率:降低大规模分布式智能体系统的能源消耗

结论

分布式智能体系统代表了AI领域的重要发展方向,通过多智能体协作解决复杂问题。本文深入探讨了分布式智能体的架构设计、状态同步机制、任务调度策略、跨地域协同方法和量子加速接口预留,为读者提供了全面的技术视角和实践指导。

随着技术的不断进步,特别是量子计算的发展,分布式智能体系统将具备更强大的能力,应用范围也将不断扩大。面向未来的系统设计应当保持灵活性和可扩展性,为新兴技术的集成做好准备。通过DAWN、AutoGen等框架的不断发展和完善,构建强大的分布式智能体系统将变得更加简单和高效。

希望本文能为研究人员和开发者提供有价值的参考,促进分布式智能体技术的创新和应用。