想象一下,如果机器也能像人类一样"看见"这个世界,会发生什么样的变化?这不再是科幻小说里的情节,而是正在我们身边发生的现实。计算机视觉,这个让机器拥有"眼睛"的技术,正在以前所未有的速度改变着我们的生活。

网页版:https://www.genspark.ai/api/page_private?id=piafdpfp

视频版:https://www.youtube.com/watch?v=956ssFVm8VQ

从你早上刷短视频时的智能推荐,到出门开车时的辅助驾驶系统,再到医院里帮助医生诊断疾病的AI助手,计算机视觉就像一个无形的魔法师,在各个角落施展着它的魔法。今天,让我们一起踏上这趟奇妙的探索之旅,深入了解计算机视觉的九大核心任务。

第一章:图像分类 – 给世界贴标签的艺术

还记得小时候玩的"你比我猜"游戏吗?图像分类就像是让计算机玩这个游戏。给它看一张照片,它需要告诉你这是猫还是狗,是苹果还是橘子。

图像分类是计算机视觉的基础任务,也是最容易理解的一个。它的工作原理很直观:把一整张图片输入给AI系统,系统会输出这张图片属于哪个类别。听起来简单,但背后的技术却相当复杂。

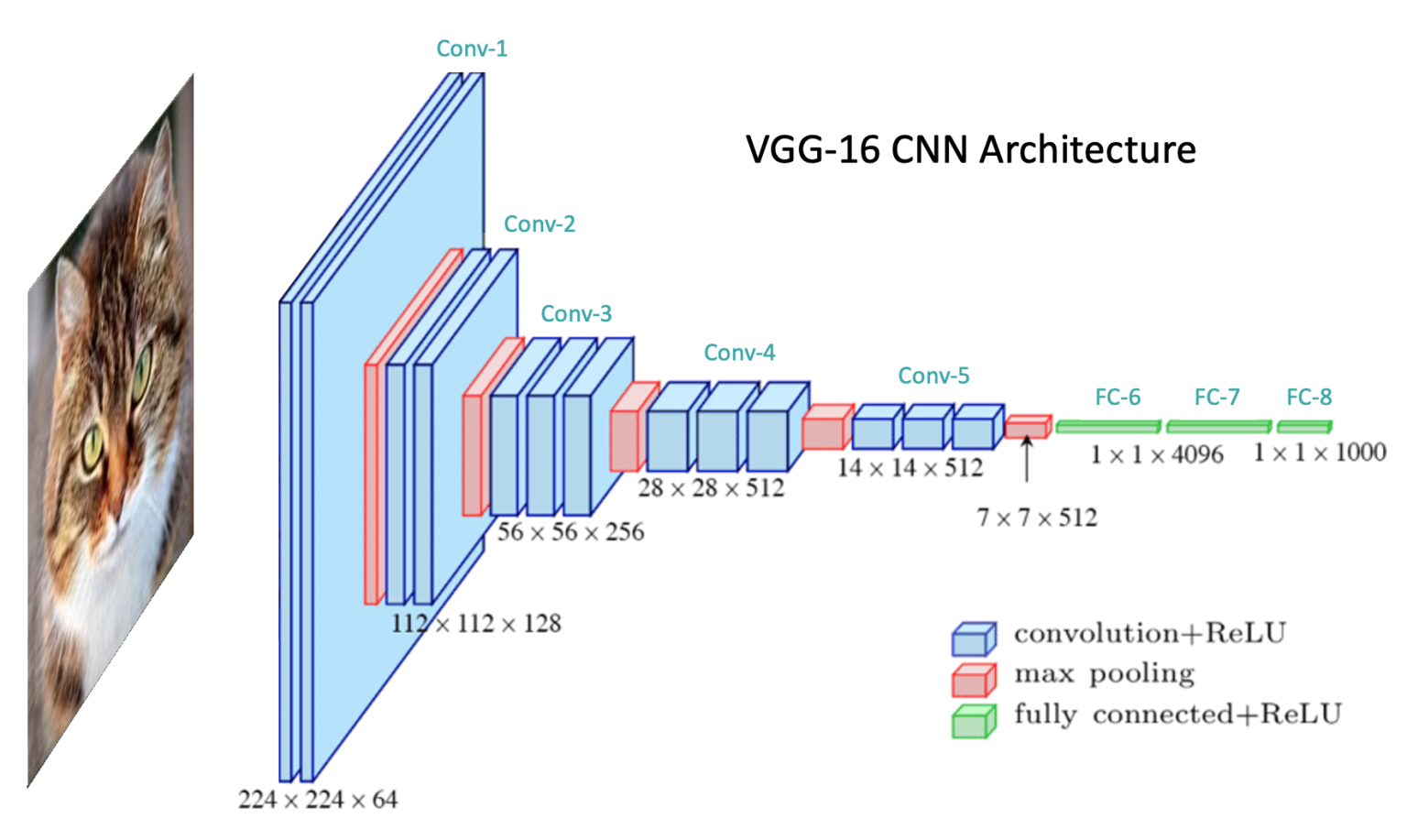

现代的图像分类主要依赖卷积神经网络(CNN)。其中,ResNet架构是一个重要的里程碑。在2012年,AlexNet在ImageNet挑战赛上取得突破性成绩,错误率仅为15.3%,远超传统方法的26%。到了2015年,ResNet-152的错误率降到了3.57%,甚至超越了人类的5.1%错误率。

在实际应用中,图像分类被广泛用于医疗诊断。比如在医疗影像分析中,AI可以帮助识别肺癌、皮肤癌等疾病。Google的研究显示,他们的AI系统在识别糖尿病视网膜病变方面,准确率达到了90%以上,超过了许多专业医生的水平。

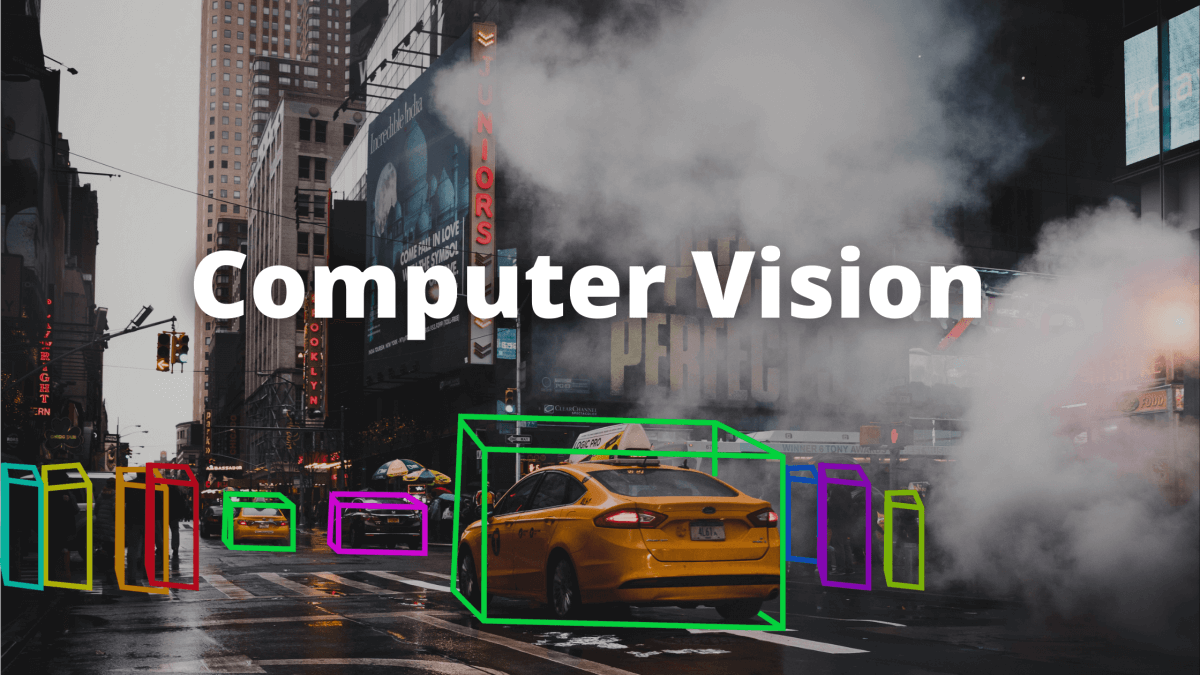

第二章:目标检测 – 在人海中找到你

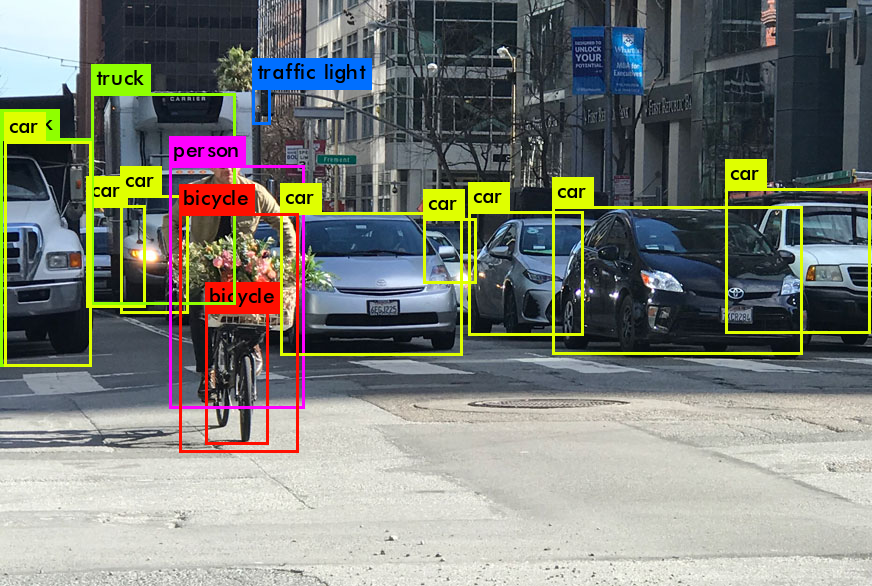

如果说图像分类是"这是什么",那么目标检测就是"什么在哪里"。它不仅要识别图片中的物体,还要准确定位它们的位置。

目标检测算法主要分为两大流派:单阶段检测器和双阶段检测器。YOLO(You Only Look Once)系列是单阶段检测器的代表,因其快速的推理速度而闻名。最新的YOLOv7在COCO数据集上达到了惊人的性能:在相同精度下,推理速度比YOLOv4快了88%,每秒可以处理286帧图像。

另一边,Faster R-CNN等双阶段检测器虽然速度稍慢,但在精度上有优势。它们先生成候选区域,再进行分类和定位,这种"两步走"的策略让检测结果更加准确。

在自动驾驶领域,目标检测是核心技术。特斯拉的Autopilot系统需要同时检测行人、车辆、交通标志等多种目标。据统计,特斯拉的神经网络每秒需要处理约36万亿次运算,才能实现实时的环境感知。

第三章:图像分割 – 像素级别的精雕细琢

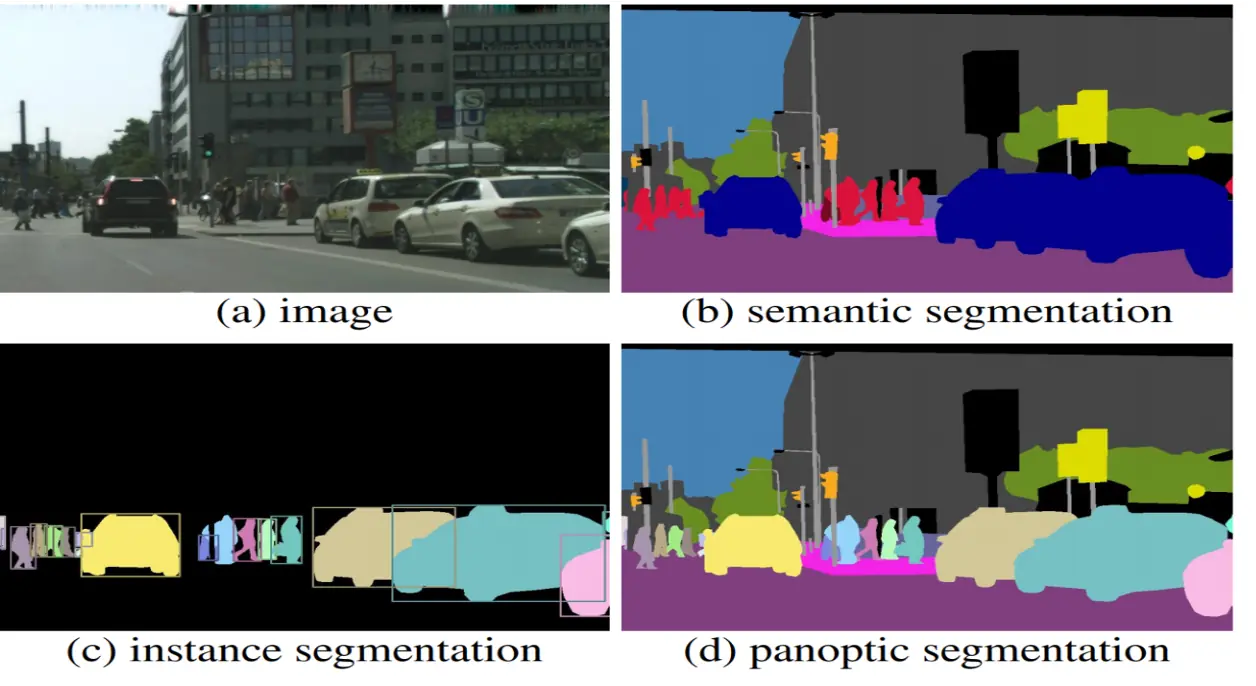

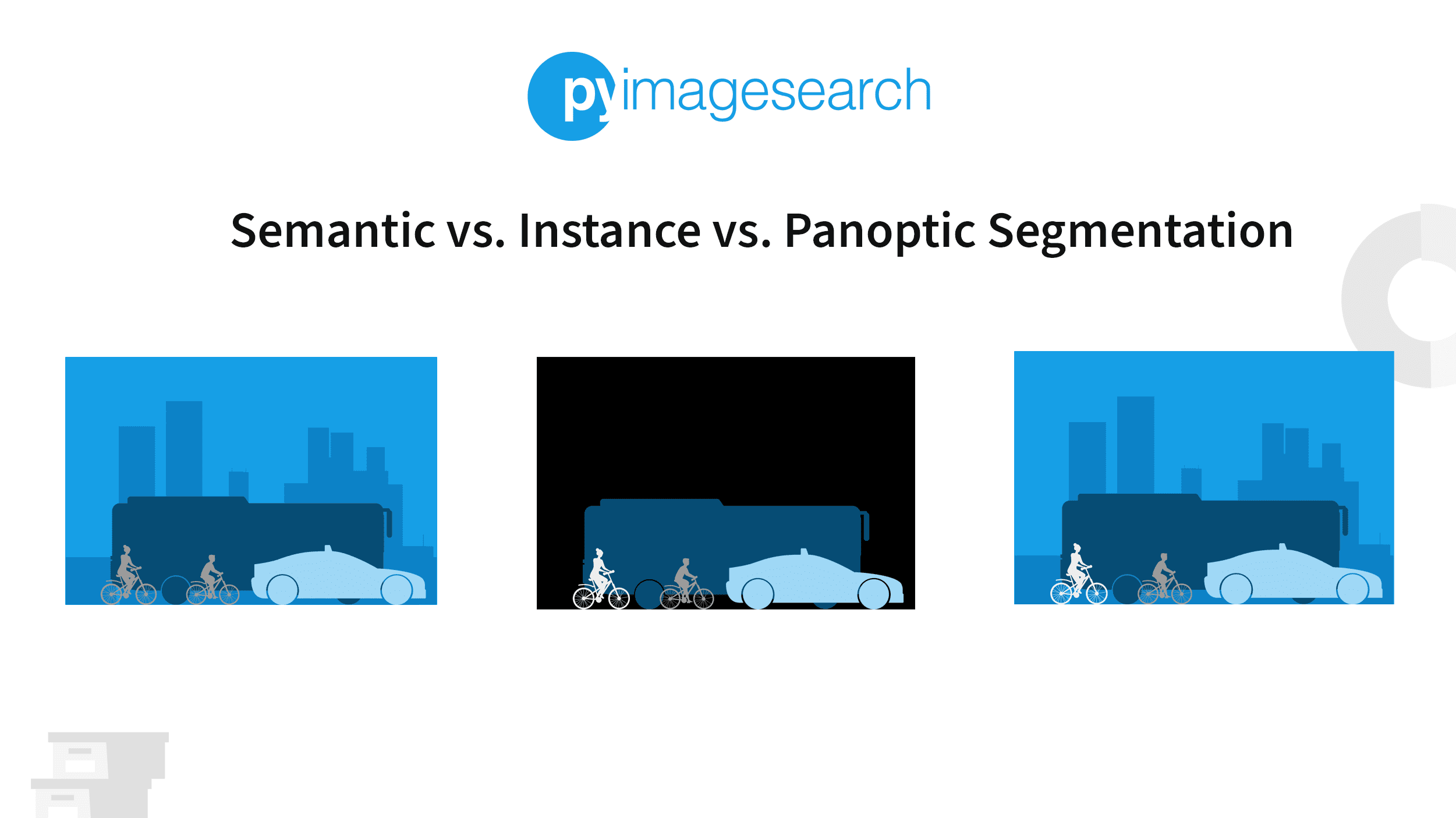

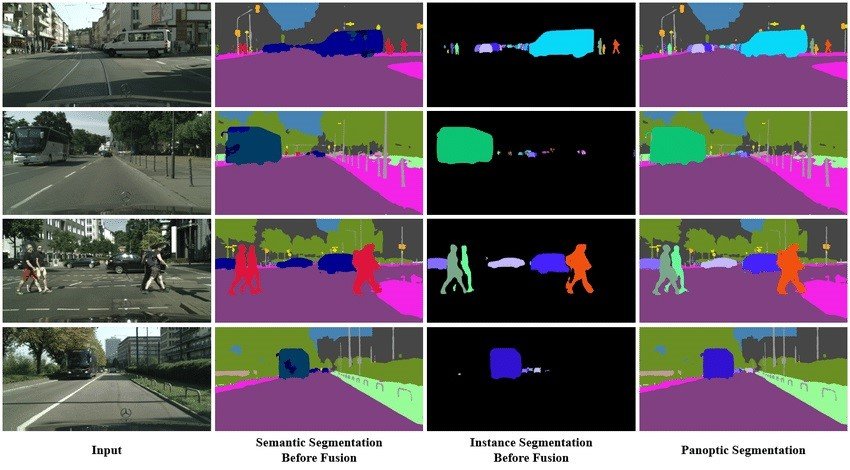

图像分割把目标检测的粗犷风格推向了精细化的极致。它不满足于简单的方框标注,而是要在像素级别上精确划分每个物体的边界。

图像分割分为三个层次:语义分割、实例分割和全景分割。语义分割给每个像素分配类别标签;实例分割不仅要分类,还要区分同类的不同个体;全景分割则是两者的结合,追求最完整的场景理解。

Mask R-CNN是实例分割领域的明星算法,它在Faster R-CNN的基础上添加了一个分支来预测物体的精确轮廓。而最近Meta AI发布的Segment Anything Model (SAM)更是革命性的突破,它可以在没有训练的情况下分割任何物体,真正实现了"万物皆可分割"。

在医疗领域,图像分割的价值尤为突出。放射科医生需要在CT或MRI图像中精确标记病变区域,传统手工标注一个案例可能需要几个小时,而AI辅助的自动分割可以将时间缩短到几分钟,准确率还能达到95%以上。

第四章:图像生成 – 无中生有的创造力

图像生成让计算机拥有了"创造"的能力。从早期的GAN(生成对抗网络)到现在火热的扩散模型,AI不仅能看懂图片,还能画出令人惊叹的作品。

生成对抗网络的工作原理很有趣:两个神经网络相互博弈,一个负责生成假图片(生成器),另一个负责识别真假(判别器)。通过不断的对抗训练,生成器最终能够产生以假乱真的图像。

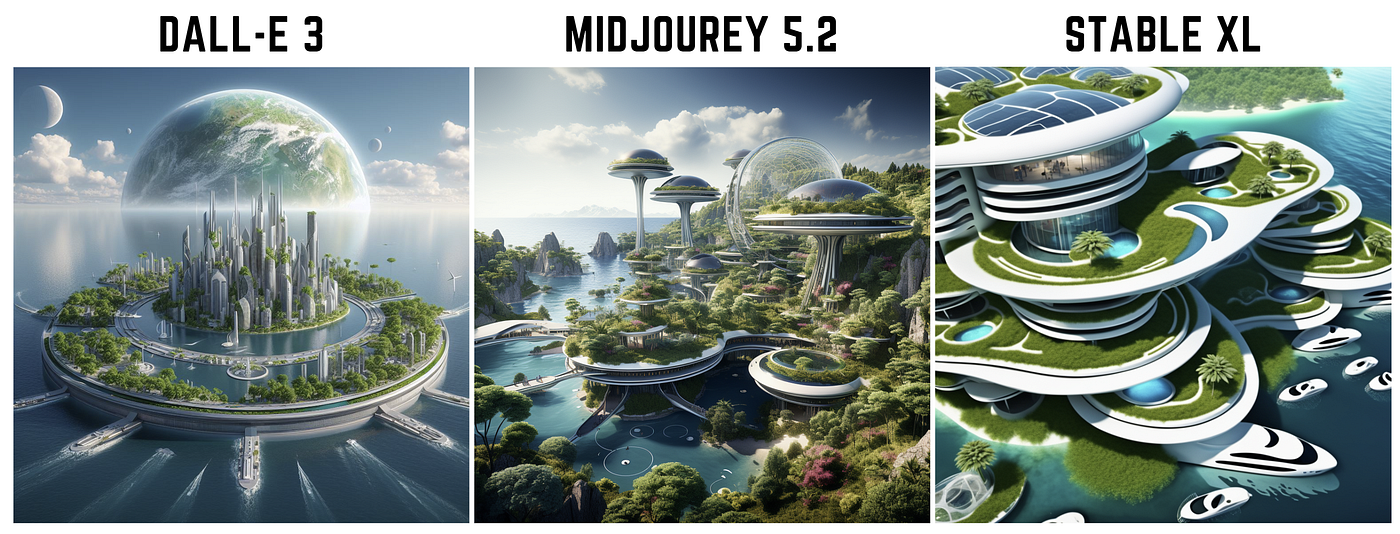

但真正引爆全球的是扩散模型,特别是DALL-E、Midjourney和Stable Diffusion。这些系统能够根据文字描述生成高质量的图像。Stable Diffusion的参数量达到8.6亿个,训练数据集包含50亿张图片,生成一张1024×1024的图片只需要几秒钟。

更令人惊喜的是,这些模型的创意能力有时甚至超越了人类。在2022年的美国科罗拉多州博览会艺术比赛中,一幅由Midjourney生成的作品《太空歌剧院》获得了数字艺术组第一名,引发了关于AI创作的广泛讨论。

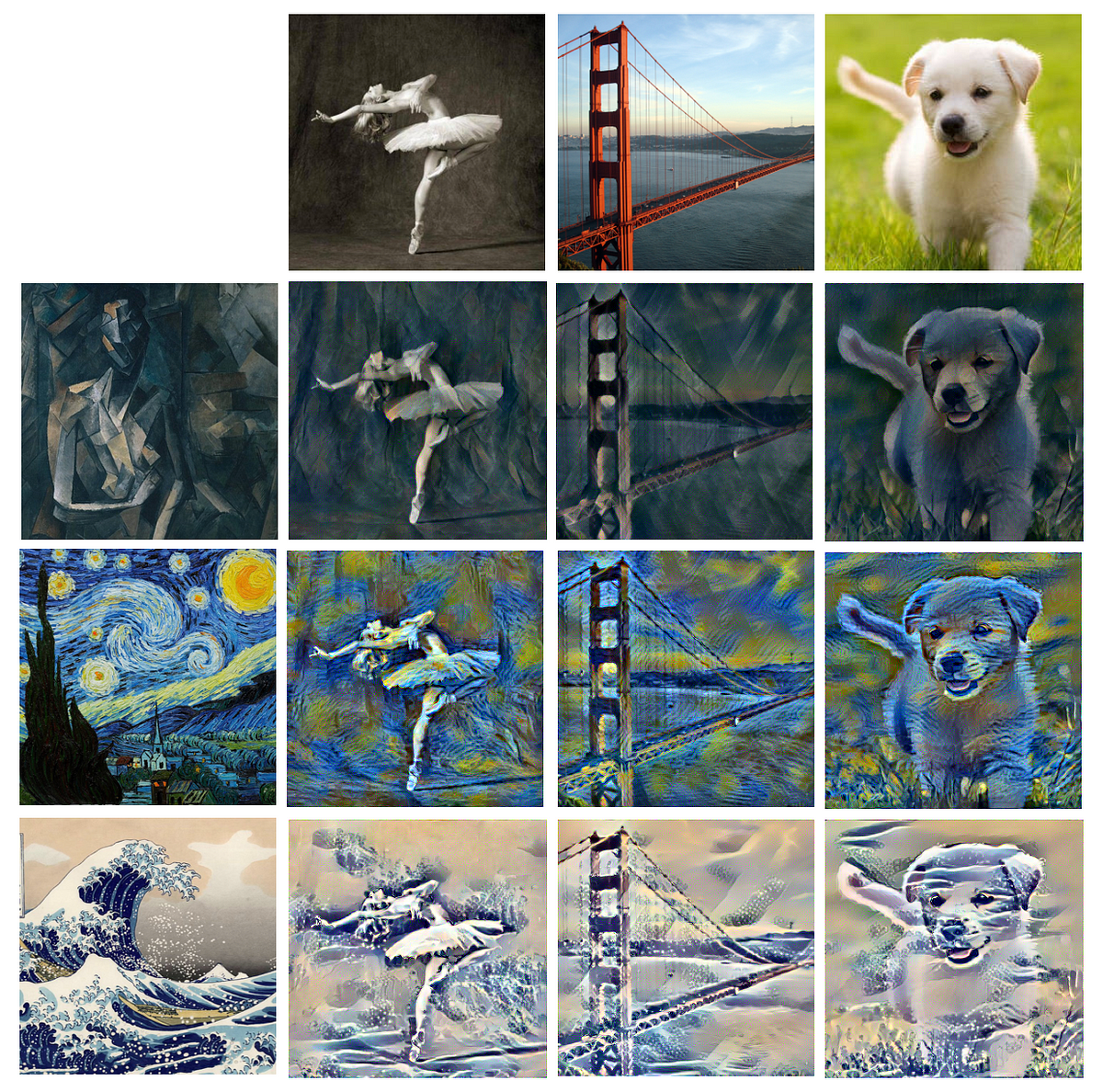

第五章:图像风格迁移 – 艺术大师的数字化身

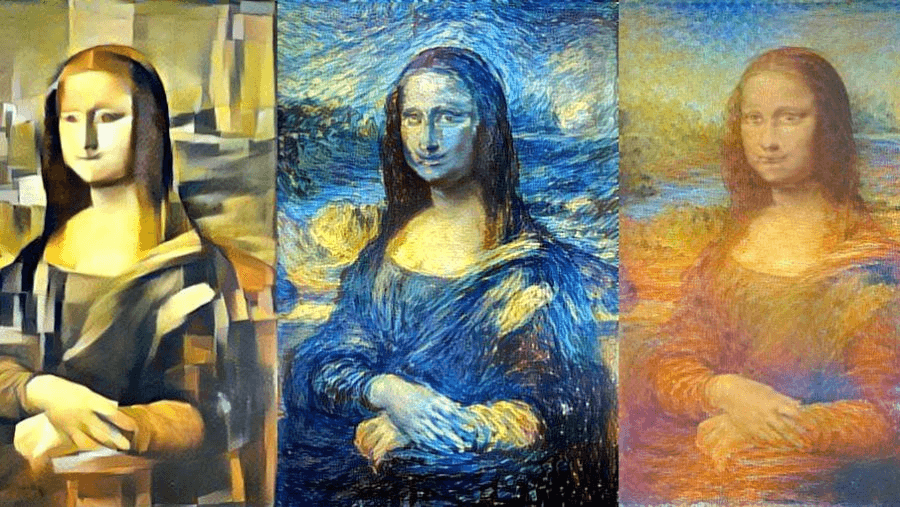

图像风格迁移让普通照片瞬间拥有了艺术大师的笔触。这项技术能够将一幅画作的艺术风格应用到另一张图片上,比如让你的自拍照拥有梵高《星夜》的风格。

早期的神经风格迁移需要对每种风格进行单独训练,效率较低。后来出现的CycleGAN解决了这个问题。它可以在没有配对训练数据的情况下,学习两个不同领域之间的映射关系。比如,它可以学会将照片转换成莫奈风格的画作,同时也能反向操作。

有趣的是,风格迁移不仅仅是艺术娱乐工具。在电影制作中,它可以快速生成不同风格的概念图;在游戏开发中,它能够批量生成具有统一艺术风格的素材;甚至在数据增强中,它也能为机器学习模型提供更丰富的训练样本。

第六章:图像超分辨率 – 让模糊变清晰的魔法

图像超分辨率技术就像是给图片施展了"清晰化咒语"。它能够将低分辨率的模糊图像转换成高清晰度的图片,在某种程度上"无中生有"地增加了图像的细节。

传统的插值方法只是简单地扩大图像,结果往往是模糊的放大版。而深度学习方法如SRCNN(超分辨率卷积神经网络)和ESRGAN(增强型超分辨率生成对抗网络)则能够智能地推断和重建图像细节。

ESRGAN的效果令人印象深刻:它可以将64×64像素的图片放大到512×512像素,不仅保持了清晰度,还增加了许多原本不存在的细节。在定量评估中,ESRGAN在Peak Signal-to-Noise Ratio (PSNR)指标上比传统方法提升了2-3dB,在感知质量上的提升更是显著。

这项技术在实际应用中价值巨大。在安防监控中,它能够增强模糊的监控录像,帮助识别嫌疑人;在医疗影像中,它可以提升旧设备拍摄的低分辨率图像质量,为诊断提供更多信息;在卫星图像分析中,它能够从低分辨率卫星图片中提取更多地理信息。

第七章:视频分类 – 理解动态世界的节奏

如果说图像分类是理解静态世界,那么视频分类就是理解动态世界。它需要从连续的帧序列中提取时间信息,识别出正在发生的动作或事件。

3D卷积神经网络(3D CNN)是视频分类的核心技术。与2D CNN不同,3D CNN在空间维度之外还增加了时间维度,能够同时捕获空间和时间特征。C3D网络是早期的代表,它使用3x3x3的卷积核,在UCF-101数据集上达到了85.2%的准确率。

更先进的方法包括双流网络(Two-Stream Networks),它分别处理RGB图像和光流信息,然后融合两个流的特征。这种设计充分利用了视频的外观信息和运动信息,在动作识别任务上取得了突破性进展。

在实际应用中,视频分类被广泛用于体育分析、智能监控、人机交互等领域。YouTube使用视频分类技术来自动标记视频内容,每天处理超过500小时的视频上传;TikTok的推荐算法也依赖视频分类来理解视频内容,为用户提供个性化推荐。

第八章:视频生成 – 创造动态的视觉盛宴

视频生成是计算机视觉领域最具挑战性的任务之一。与静态图像生成相比,视频生成不仅要保证每一帧的质量,还要确保帧与帧之间的时间一致性。

早期的视频生成方法主要基于循环神经网络(RNN)或长短期记忆网络(LSTM),但效果有限。近年来,基于扩散模型的视频生成方法取得了突破性进展。Runway的Gen-2、Pika Labs的视频生成模型以及OpenAI的Sora都展现了令人惊叹的效果。

时间一致性是视频生成的核心挑战。研究者们提出了多种解决方案,包括时间自注意力机制、时间卷积层以及专门的时间一致性损失函数。这些技术确保生成的视频在时间维度上保持连贯性,避免了闪烁和跳跃等问题。

视频生成技术正在改变内容创作的方式。广告公司可以快速生成概念视频,电影制作者可以预览特效场景,教育工作者可以创建生动的教学材料。据统计,使用AI视频生成工具可以将视频制作成本降低60-80%,制作时间缩短到原来的10-20%。

第九章:视频风格迁移 – 让时光拥有艺术气质

视频风格迁移将图像风格迁移的魔法延伸到了时间维度。它不仅要保持每一帧的艺术风格,还要确保整个视频的时间连贯性,避免出现闪烁或不一致的风格变化。

最大的挑战是时间一致性问题。如果简单地对每一帧独立进行风格迁移,结果往往是风格在帧间剧烈跳跃,观看体验很差。为了解决这个问题,研究者们开发了多种技术,包括光流约束、时间损失函数以及循环一致性约束。

实时视频风格迁移是这个领域的热点研究方向。传统方法需要对整个视频序列进行离线处理,而实时方法则可以在视频播放的同时进行风格转换。这种技术在直播、视频会议、增强现实等应用中具有巨大潜力。

一个有趣的应用案例是艺术电影制作。导演可以使用视频风格迁移技术来创造独特的视觉效果,比如将整部电影渲染成梵高的绘画风格,或者让不同的场景拥有不同艺术家的风格特征。

技术实现的深度解析

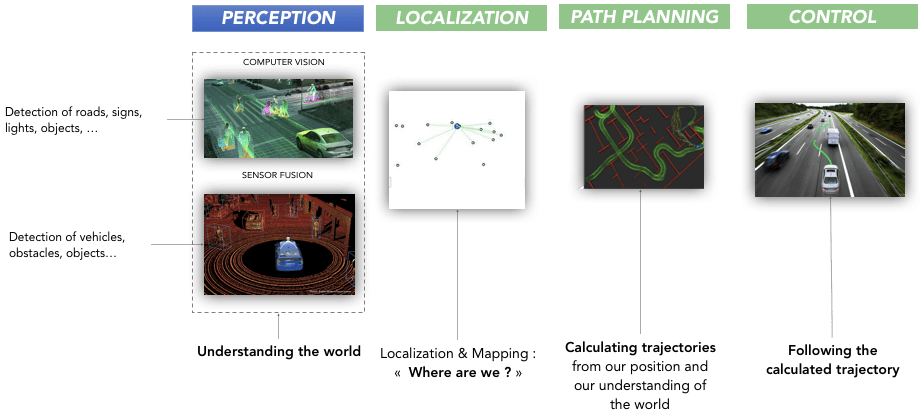

计算机视觉在医疗和自动驾驶中的应用

![]()

在医疗影像分析中,计算机视觉正在成为医生的得力助手。Google的DeepMind开发的AI系统可以在50多种眼部疾病的诊断中达到专家级别的准确性,在某些疾病的识别上甚至超过了人类医生。

更令人振奋的是,AI不仅能识别疾病,还能预测疾病的发展趋势。研究人员开发的深度学习模型可以从视网膜照片中预测心血管疾病的风险,准确率达到70%以上,为早期预防提供了新的可能。

在自动驾驶领域,计算机视觉面临着生死攸关的挑战。系统需要在各种天气条件、光照环境下准确识别行人、车辆、交通标志等目标。特斯拉的FSD(Full Self-Driving)系统使用了8个摄像头,通过神经网络实时处理视觉信息,做出驾驶决策。

据统计,自动驾驶汽车每天生成约4TB的数据,其中视觉数据占70%以上。这些数据的处理和分析对计算资源提出了极高要求,也推动了专用AI芯片的发展。

PyTorch vs TensorFlow:选择合适的深度学习框架

在实现这些计算机视觉任务时,选择合适的深度学习框架至关重要。PyTorch以其动态计算图和Pythonic的API设计而受到研究者的青睐,而TensorFlow则以其工业级的部署能力和丰富的生态系统著称。

PyTorch的优势在于调试便利和模型开发的灵活性。你可以像写普通Python代码一样构建神经网络,动态地修改网络结构。这对于研究新算法和快速原型验证非常有价值。而TensorFlow的优势则体现在模型部署和大规模训练上,TensorFlow Serving和TensorFlow Lite使得模型从研究到生产的转换更加seamless。

数据增强:提升模型性能的秘密武器

数据增强是提升计算机视觉模型性能的重要技术。通过对原始数据进行几何变换、颜色调整、噪声添加等操作,可以人工扩展训练数据集的规模和多样性。

常用的数据增强技术包括:

- 几何变换:旋转、翻转、缩放、裁剪

- 颜色空间变换:调整亮度、对比度、饱和度

- 噪声注入:高斯噪声、椒盐噪声

- 混合技术:Mixup、CutMix

研究表明,适当的数据增强可以将模型性能提升2-5个百分点。在ImageNet分类任务中,使用RandAugment等自动数据增强策略的ResNet-50模型,Top-1准确率从76.3%提升到了79.1%。

模型架构的演进:从CNN到Transformer

计算机视觉模型架构经历了从传统CNN到现代Transformer的演进过程。CNN通过卷积操作捕获局部特征,池化操作实现平移不变性;而Vision Transformer(ViT)则将图像切分成patches,使用自注意力机制建模全局依赖关系。

不同架构的性能对比显示了技术进步的轨迹:

- AlexNet (2012): ImageNet Top-1 错误率 15.3%

- ResNet-152 (2015): 错误率 3.57%

- EfficientNet-B7 (2019): 错误率 2.0%

- Vision Transformer-H/14 (2020): 错误率 1.28%

实际应用中的挑战与机遇

工业质检:精益求精的智能制造

在制造业中,计算机视觉正在革命性地改变质量控制流程。传统的人工检测不仅效率低下,还容易出现疲劳导致的误判。而AI视觉检测系统可以24小时不间断工作,检测精度达到99.9%以上。

富士康在iPhone生产线上部署的AI视觉检测系统,每分钟可以检测数百个零件,检测速度比人工快10倍,缺陷检出率提升了30%。这不仅提高了产品质量,还大大降低了生产成本。

计算机视觉的未来展望

多模态融合:感知的全维度拓展

未来的计算机视觉系统将不再局限于纯视觉信息,而是会融合语音、文本、传感器数据等多种模态信息。OpenAI的GPT-4V就是一个很好的例子,它可以同时理解图像和文本,进行跨模态的推理和生成。

Edge AI:将智能推向边缘

随着5G和边缘计算技术的发展,计算机视觉应用正在从云端向边缘设备迁移。这不仅能减少延迟,提高响应速度,还能保护用户隐私,降低数据传输成本。苹果的神经引擎、华为的达芬奇架构都是这一趋势的体现。

绿色AI:可持续发展的智能技术

随着环保意识的提升,如何降低AI模型的能耗成为重要课题。研究者们正在开发更高效的模型架构和训练方法,比如知识蒸馏、模型剪枝、量化等技术,在保持性能的同时显著降低计算需求。

计算机视觉的这场革命还在继续。从简单的图像识别到复杂的场景理解,从静态图片到动态视频,从2D平面到3D空间,技术的边界在不断拓展。每一个新的突破都在重新定义可能性的边界,每一次应用的成功都在改变我们的生活方式。

在这个AI与人类智慧交融的时代,计算机视觉不仅仅是一门技术,更是连接数字世界与物理世界的桥梁。它让机器拥有了"眼睛",也让人类的视野变得更加广阔。这场视觉革命的序幕才刚刚拉开,未来的精彩还在后头。