当我第一次接触深度学习时,我被一个简单的问题困惑了:为什么叫"深度"学习。直到我看到一个56层的网络竟然比20层网络表现更差时,我才意识到,这个"深度"背后隐藏着多么复杂的科学问题。

网页版:https://www.genspark.ai/api/page_private?id=mcdeunch

视频版:https://www.youtube.com/watch?v=nUbbD4_OcT8

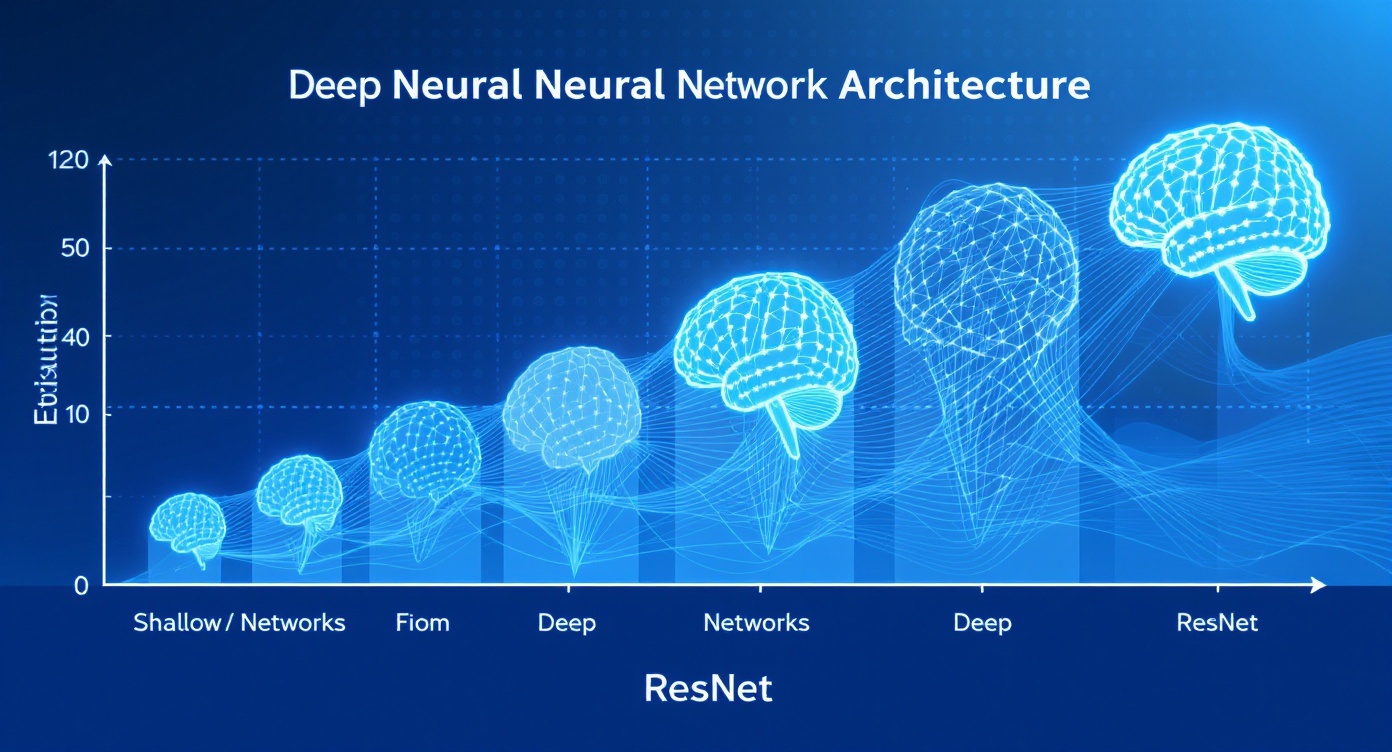

深度的悖论:更深却更差

想象你正在建造一座摩天大楼。按理说,楼层越多,能容纳的功能就越丰富。但在深度学习的世界里,研究者们却发现了一个令人困惑的现象:当网络从20层增加到56层时,训练误差不仅没有降低,反而变得更高。

这个现象被称为"网络退化问题"(degradation problem)。更令人不解的是,这不是过拟合造成的,因为连训练数据上的表现都变差了。这就像是你请了更多的老师来教学生,结果学生的成绩反而下降了。

梯度消失:深度网络的阿喀琉斯之踵

要理解这个问题,我们必须深入到反向传播的数学本质。在神经网络训练中,梯度需要从输出层一路传播到输入层,这个过程涉及大量的乘法运算。

在数学上,这个过程可以用链式法则来描述。假设我们有一个10层的网络,每层的梯度都是0.9,那么经过10层后,梯度就变成了0.9^10 ≈ 0.35。而对于50层的网络,梯度会变成0.9^50,这个数字小到几乎可以忽略不计。

这就是梯度消失问题的数学本质:在深层网络中,梯度会随着层数的增加而指数式衰减,导致前面的层几乎学不到任何东西。

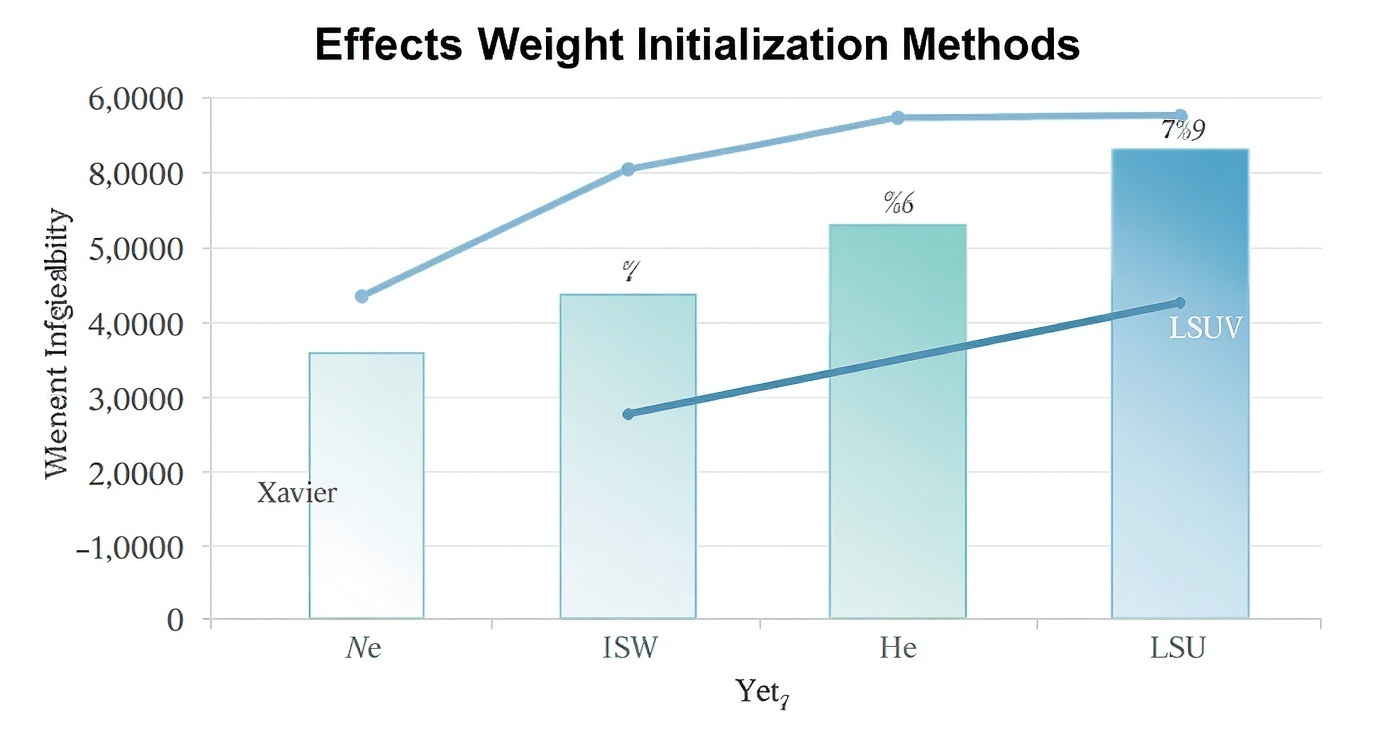

权重初始化:微妙平衡的艺术

在深度学习的早期,人们对权重初始化的重要性认识不足。最初的做法是将所有权重初始化为零,但这样做会导致所有神经元学到相同的特征,完全失去了网络的表达能力。

Xavier初始化:寻求完美平衡

2010年,Xavier Glorot和Yoshua Bengio提出了一个优雅的解决方案。Xavier初始化的核心思想是保持每层输出的方差为1,同时保持梯度的方差也为1。

数学上,Xavier初始化要求权重从均值为0、方差为1/n_in的分布中采样,其中n_in是输入的维度。这个简单的公式背后蕴含着深刻的统计学原理:它确保了信号在前向传播和反向传播过程中都能保持适当的强度。

He初始化:为ReLU量身定制

但Xavier初始化有一个问题:它是为sigmoid和tanh等对称激活函数设计的。当ReLU激活函数成为主流后,研究者们发现Xavier初始化不再有效。

原因很直观:ReLU函数会将所有负值置零,这意味着大约一半的神经元输出为零,方差也随之减半。何凯明等人在2015年提出的He初始化,将方差调整为2/n_in,正好补偿了ReLU带来的方差损失。

LSUV:数据驱动的智慧

LSUV初始化代表了一种更加实用的方法。它不依赖理论假设,而是用实际数据来逐层调整权重。

LSUV的工作流程很有趣:首先将权重初始化为正交矩阵,然后用一个小批量数据进行前向传播,根据实际输出的方差来调整权重的缩放因子。这种方法往往比纯理论方法效果更好,因为它考虑了实际数据的分布特征。

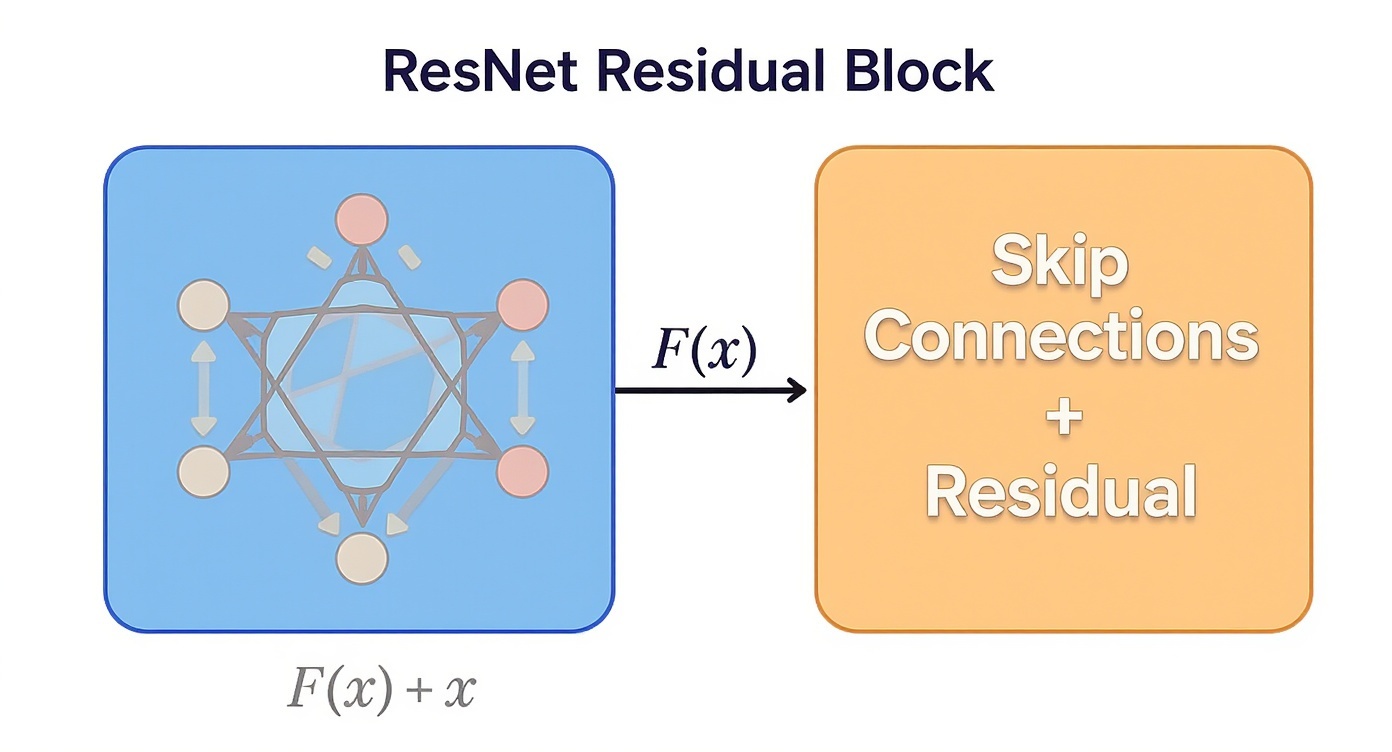

ResNet:跳跃连接的革命

2015年,何凯明等人提出了一个看似简单但实际上革命性的想法:在网络中添加跳跃连接(skip connections)。这个想法彻底改变了深度学习的发展轨迹。

残差学习的哲学思考

ResNet的核心创新是残差学习的概念。传统网络试图学习从输入x到输出y的直接映射H(x)=y,而ResNet让网络学习残差函数F(x)=H(x)-x,最终输出变为F(x)+x。

这个想法的巧妙之处在于数学上的简化:如果最优映射确实接近恒等映射,那么网络只需要将F(x)学习为接近零的函数即可。这比让网络直接学会复杂的恒等映射要容易得多。

梯度高速公路的建立

从梯度传播的角度看,跳跃连接提供了一条"梯度高速公路"。在数学上,如果我们有跳跃连接y=F(x)+x,那么对输入x的梯度就是:

∂y/∂x = ∂F(x)/∂x + 1

注意这里的"+1"项:即使F(x)的梯度很小,总梯度至少还有1,永远不会完全消失。这就是跳跃连接解决梯度消失问题的数学原理。

ResNet-50的精妙设计

ResNet-50的架构设计展现了工程艺术的美感。它使用了bottleneck设计:1×1卷积降维→3×3卷积处理→1×1卷积升维。这种设计在保持表达能力的同时,大大降低了计算复杂度。

完整的ResNet-50架构包含49层卷积层和1层全连接层,通过巧妙的残差块设计,让如此深的网络不仅可以训练,而且性能卓越。

正则化技术:防过拟合的智慧盾牌

随着网络变得越来越复杂,正则化技术变得越来越重要。这些技术就像是给网络戴上了"智能约束手套",防止它过分拟合训练数据。

Dropout:随机化的力量

Dropout可能是最优雅的正则化技术。它的思想简单而有效:在训练过程中随机将一些神经元的输出设为零。

这种随机性的力量在于强迫网络不能过分依赖某些特定的神经元。从信息论的角度看,Dropout增加了网络的冗余性,提高了鲁棒性。从集成学习的角度看,每次训练实际上都在训练一个略有不同的子网络,最终模型相当于这些子网络的平均。

L1和L2正则化:权重约束的艺术

L1和L2正则化通过在损失函数中添加权重的惩罚项来控制模型复杂度。L2正则化鼓励权重值较小且分布均匀,而L1正则化则鼓励稀疏的权重分布。

有趣的是,从贝叶斯的角度看,L2正则化等价于在权重上施加高斯先验,而L1正则化等价于拉普拉斯先验。这种连接为正则化技术提供了深刻的理论基础。

Batch Normalization:不只是标准化

Batch Normalization(BN)最初是为了解决内部协变量偏移问题而提出的,但后来发现它还有强大的正则化效果。

BN的正则化效果来自于它引入的噪声:每个mini-batch的统计量都略有不同,这种噪声起到了隐式正则化的作用。更重要的是,BN使网络对初始化和学习率的选择更加鲁棒,大大简化了训练过程。

实践中的经验与智慧

经过多年的发展,深度学习社区积累了丰富的实践经验:

设计原则与最佳实践

- 深度优先原则:在相同参数量下,优先增加深度而非宽度

- 残差连接必需:对于超过20层的网络,几乎总是需要残差连接

- 初始化至关重要:选择适合激活函数的初始化方法

- 正则化组合使用:通常需要结合多种正则化技术

- 数据决定架构:让数据复杂度指导网络复杂度的选择

现代架构的演进脉络

从ResNet开始,深度学习架构经历了快速演进:

- DenseNet引入了密集连接,让每层都能直接访问前面所有层的特征

- EfficientNet通过复合缩放找到了深度、宽度和分辨率的最佳平衡

- Vision Transformer完全颠覆了卷积的范式,证明了注意力机制的强大

- MobileNet系列专注于移动端优化,探索了深度可分离卷积的可能性

但无论架构如何变化,ResNet引入的残差学习思想始终是现代深度学习的基石。

未来展望:架构设计的新方向

深度网络架构设计仍然是一个充满活力的研究领域:

自动化架构搜索

神经架构搜索(NAS)正在自动化架构设计过程。通过强化学习或进化算法,NAS可以在巨大的架构空间中搜索最优设计,有时能发现人类设计师想不到的创新架构。

可解释性驱动的设计

随着对模型可解释性要求的提高,研究者们开始从可解释性的角度来设计架构。这包括设计能够提供中间表示解释的网络,以及能够可视化决策过程的架构。

多模态统一建模

未来的架构设计趋势是构建能够同时处理文本、图像、音频等多种模态的统一模型。这要求架构设计师重新思考如何在单一框架内有效地融合不同类型的信息。

结语:深度的真正含义

回到最初的问题:为什么叫"深度"学习。现在我们知道,这个"深度"不仅仅指网络的层数,更代表了对复杂模式的深层理解能力。

ResNet的成功告诉我们,真正的创新往往来自于对基本问题的重新思考。跳跃连接这个看似简单的想法,解决了困扰整个社区的根本问题,开启了深度学习的新纪元。

深度网络架构设计的故事还在继续书写。每一个新的想法,每一次突破,都可能成为下一个时代的起点。而我们,作为这个激动人心时代的见证者和参与者,有幸能够亲历人工智能历史上最重要的变革。