在这个数据驱动的时代,你是否曾经好奇过为什么股票价格会如此起伏不定,为什么天气预报有时会让我们措手不及,或者为什么电商平台总能在双十一前准确预测销售量?这些看似神秘的现象背后,都隐藏着一门令人着迷的学问——时间序列预测。

网页版: https://yatyklba.gensparkspace.com/

视频版:https://www.youtube.com/watch?v=j5tJzQgs2Ew

今天,让我带你踏上一场奇幻的数据探索之旅,从经典的统计模型到最前沿的深度学习技术,我们将一起揭开时间序列预测的神秘面纱。

时间序列数据:时光中的密码

想象一下,你每天早上都会记录下当天的体重数据。一个月后,当你把这些数字按时间顺序排列时,你会发现一个有趣的现象:这些数字并不是随机分布的,它们之间存在着某种微妙的关联。也许周末的数值总是偏高(因为聚餐),也许有一个整体的下降趋势(因为你在坚持锻炼)。这就是时间序列数据的魅力所在。

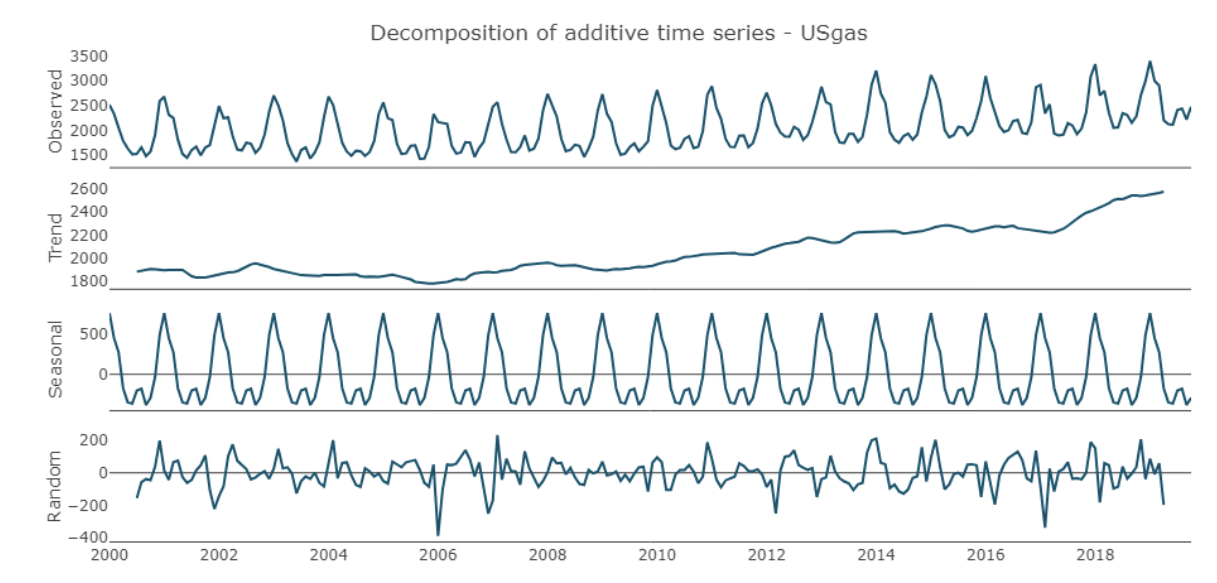

时间序列数据有着独特的"性格"。根据TensorFlow官方教程的介绍,它具有三个核心特征:趋势(长期的上升或下降模式)、季节性(固定周期的重复模式)和噪声(随机的波动)。就像人的性格一样,理解这些特征是进行准确预测的关键。

更有趣的是,时间序列数据还有一个叫做平稳性的概念。研究表明,平稳的时间序列就像一个性格稳定的朋友——它的统计特性(均值、方差、自相关结构)不会随时间发生显著变化。而非平稳的时间序列则像一个情绪多变的人,需要特殊的"心理治疗"(差分处理)才能稳定下来。

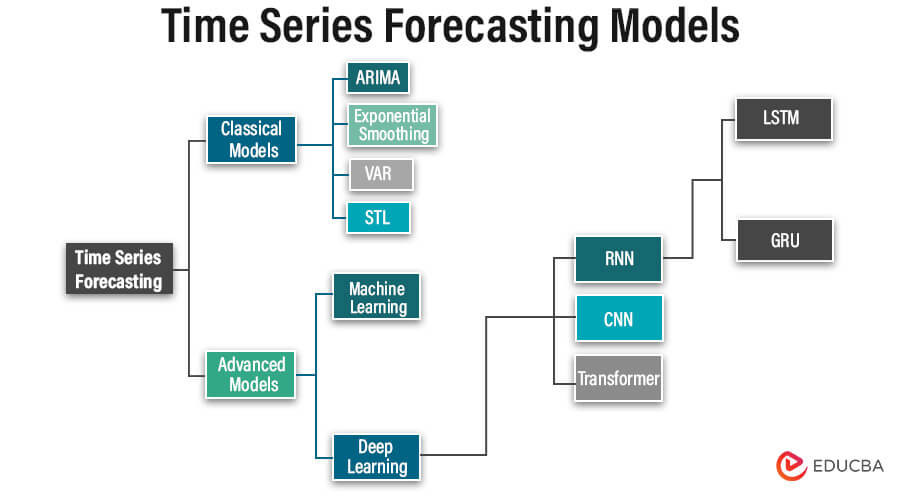

经典模型的智慧:从AR到SARIMA的演进故事

AR模型:简单而优雅的开始

让我们从最简单的自回归(AR)模型开始这个故事。AR模型的核心思想非常朴素:今天的你很大程度上取决于昨天的你。在数学上,这被表达为AR(p)模型,其中p代表回望的时间步数。

想象你在预测明天的股票价格,AR模型会告诉你:"看看过去3天的价格,它们的加权组合就是明天价格的最佳预估。"这种思路虽然简单,但却蕴含着深刻的智慧。

MA模型:从错误中学习

移动平均(MA)模型则采用了另一种思路。它不是直接从历史数值中学习,而是从历史的预测误差中学习。这就像一个善于反思的学生,通过分析自己的错误来改进未来的表现。

ARMA:两全其美的结合

当我们将AR和MA的智慧结合起来,就诞生了ARMA模型。这就像是一个既能从历史中学习,又能从错误中反思的智者。实验数据显示,ARMA模型在处理平稳时间序列时表现出色,但面对有趋势的数据时往往力不从心。

ARIMA:引入差分的革新

ARIMA模型的出现解决了ARMA无法处理非平稳数据的问题。通过引入差分(Integrated)项,ARIMA能够"驯服"那些桀骜不驯的非平稳时间序列。这个"I"看似简单,实际上代表了时间序列分析的一个重大突破。

研究表明,在处理带有明显趋势的数据时,ARIMA模型的均方根误差(RMSE)相比ARMA模型显著降低,从6.56降至4.35,这是一个令人印象深刻的改进。

SARIMA:季节性的终极解决方案

最后登场的是SARIMA模型,它在ARIMA的基础上加入了季节性组件。如果说ARIMA是处理趋势的专家,那么SARIMA就是处理周期性模式的大师。它能够同时捕捉长期趋势和季节性变化,AIC值进一步从1528.48降低到1277.41。

深度学习的革命:神经网络的时间记忆

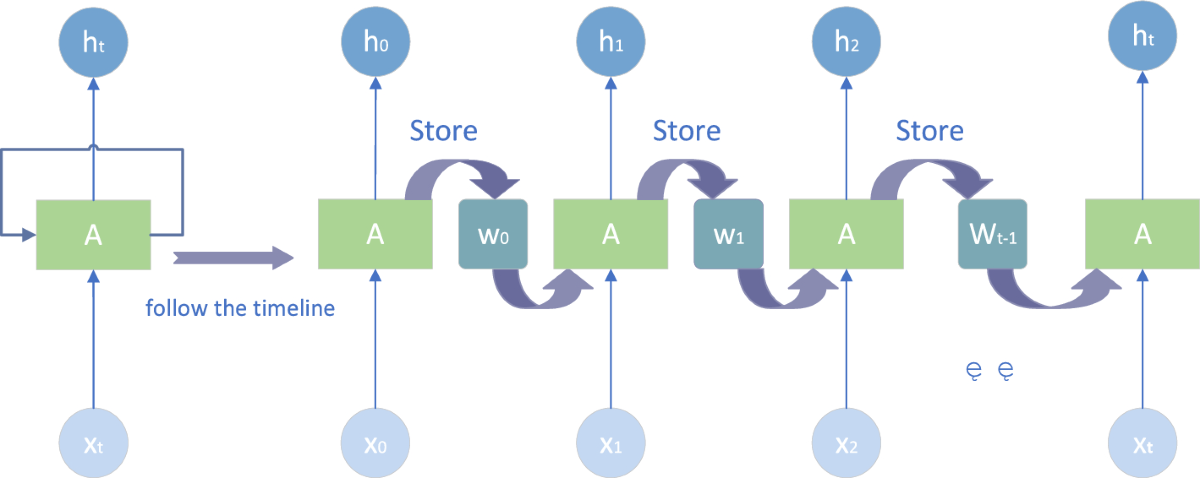

RNN:记忆的萌芽

当我们进入深度学习的领域时,循环神经网络(RNN)为时间序列预测带来了革命性的变化。RNN就像一个拥有短期记忆的大脑,能够记住之前看到的信息并将其应用到当前的预测中。

研究显示,RNN的核心优势在于其能够处理变长的序列数据,这使它在处理不规则时间间隔的数据时特别有用。然而,传统的RNN面临着一个致命的问题:梯度消失。这就像一个人的记忆会随着时间的推移而模糊,越久远的信息越难以准确回忆。

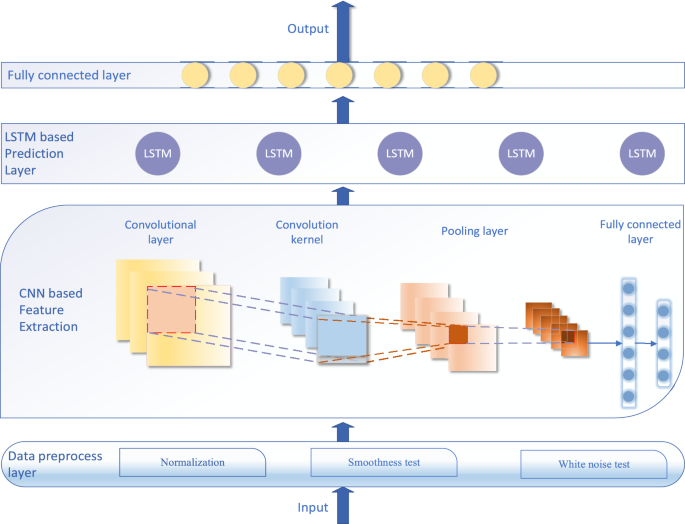

LSTM:长期记忆的奇迹

长短期记忆网络(LSTM)的出现彻底解决了RNN的记忆问题。LSTM就像一个拥有完美记忆系统的大脑,它有三个神奇的"门":输入门、遗忘门和输出门。这些门协同工作,决定哪些信息需要记住,哪些需要忘记,哪些需要输出。

在实际应用中,LSTM在电力消费预测任务中展现出了强大的能力。虽然在复杂的实际应用中仍存在挑战(如案例研究中显示的RMSE、MAE和MAPE指标需要进一步优化),但其在捕捉长期依赖关系方面的优势是不可否认的。

GRU:简化的智慧

门控循环单元(GRU)可以看作是LSTM的简化版本。它只有两个门:重置门和更新门。GRU的哲学是"简单即美"——用更少的参数实现与LSTM相似的性能,同时减少计算复杂度。

Transformer:注意力机制的时代

注意力的力量

当Transformer模型横空出世时,它带来了一个全新的概念:注意力机制。如果说LSTM是通过记忆来处理序列,那么Transformer则是通过"注意力"来处理序列。

研究表明,注意力机制让模型能够同时关注序列中的所有位置,而不是像RNN那样按顺序处理。这就像一个人能够同时看到整个画面,而不是只能从左到右逐一观察。

并行处理的革命

Transformer的另一个革命性特征是其并行处理能力。传统的RNN必须按时间步骤逐一处理,而Transformer能够同时处理整个序列。这大大提高了训练效率,使得处理长序列成为可能。

在股票价格预测、温度预测和销售预测等任务中,基于Transformer的模型展现出了卓越的性能,特别是在捕捉长期依赖关系方面。

实战应用:理论照进现实

股票价格预测的挑战

在金融领域,时间序列预测面临着前所未有的挑战。股票价格不仅受到历史数据的影响,还会受到新闻事件、政策变化、市场情绪等多种外部因素的冲击。最新研究提出了专门针对股票预测的"Stockformer"模型,这是一个基于Transformer的多变量时间序列预测模型。

温度预测的季节性模式

天气预测是另一个经典的时间序列应用场景。温度数据具有明显的日周期和年周期特征,这使得SARIMA和带有注意力机制的深度学习模型在这个领域特别有效。TensorFlow的官方案例使用德国马克斯·普朗克研究所的天气数据,展示了如何构建多变量时间序列预测模型。

销售预测的商业价值

在电子商务领域,销售预测直接关系到库存管理、供应链优化和营收规划。现代的预测模型需要同时考虑多个SKU(库存单位)、多个销售渠道,以及各种促销活动的影响。PyTorch Forecasting的Temporal Fusion Transformer在这方面展现出了强大的能力。

模型选择的艺术:没有万能的银弹

数据特征决定模型选择

选择合适的时间序列预测模型就像选择合适的工具一样,需要根据具体的任务特征来决定。对于短期、相对稳定的时间序列,传统的ARIMA模型可能就足够了。对于长期、复杂的多变量时间序列,深度学习模型则更有优势。

计算资源与精度的权衡

在实际应用中,我们还需要考虑计算资源的限制。LSTM和GRU虽然强大,但训练时间较长。Transformer模型虽然效果出色,但需要大量的计算资源。因此,在资源受限的环境中,简单的ARIMA模型可能是更好的选择。

可解释性的重要性

在某些关键应用场景中,模型的可解释性比预测精度更重要。传统的统计模型在这方面具有天然的优势,而深度学习模型则相对"黑盒"。近年来,注意力可视化等技术为深度学习模型的可解释性提供了新的途径。

未来的展望:预测的预测

多模态融合的趋势

未来的时间序列预测模型将不仅仅依赖于历史数值数据,还会融合文本、图像、音频等多模态信息。例如,在股票预测中融合新闻文本情感分析,在天气预测中融合卫星图像数据。

自适应学习的进化

随着在线学习和概念漂移检测技术的发展,未来的预测模型将能够自动适应数据分布的变化,实现真正的自适应预测。

因果推理的整合

传统的时间序列预测主要基于相关性,而未来的模型将更多地整合因果推理,从而提供更加可靠和可解释的预测结果。

结语:时间的艺术与科学

时间序列预测既是一门科学,也是一门艺术。科学的部分在于严谨的数学理论和算法设计,艺术的部分在于对数据特征的深刻理解和模型的巧妙选择。

从最初的AR模型到最新的Transformer架构,我们见证了这个领域的快速发展。每一个模型的诞生都是为了解决前一代模型的局限性,每一次创新都让我们离"准确预测未来"的目标更进一步。

在这个数据驱动的时代,掌握时间序列预测技术不仅是技术人员的必修课,也是理解这个世界运行规律的重要工具。毕竟,在某种意义上,我们每个人都是时间序列中的一个数据点,而生活本身就是一个巨大的预测问题。

当你下次看到股票价格的波动、天气预报的更新,或者电商平台的推荐时,不妨想想这些看似简单的数字背后隐藏着多么复杂而精妙的数学世界。这就是时间序列预测的魅力——它让我们能够从过去的经验中学习,对未来做出智慧的判断。