你有没有想过,计算机是怎么学会区分猫和狗的照片,或者垃圾邮件和正常邮件的?今天我们来聊聊机器学习中的一个"明星"算法——支持向量机(SVM),它就像一个超级智能的分拣员,能够准确地把不同类型的数据分开。

网页版: https://lcyhfemi.gensparkspace.com/

视频版:https://www.youtube.com/watch?v=CuCrma1dxBs

音频版:https://notebooklm.google.com/notebook/9b5f069a-2475-4378-9eea-fc31e8e9f7ae/audio

什么是SVM?用生活中的例子来理解

想象你是一个水果店的老板,桌上放着一堆苹果和橘子混在一起。你需要把它们分开放到不同的篮子里。最简单的方法是什么?在桌子中间放一根绳子,把苹果和橘子分别放在绳子的两边。

但这里有个关键问题:这根绳子应该放在哪里?

如果你很聪明,你会把这根绳子放在离两种水果都尽可能远的地方,这样即使有人不小心碰到桌子,水果稍微移动一下,你也能准确判断它是苹果还是橘子。

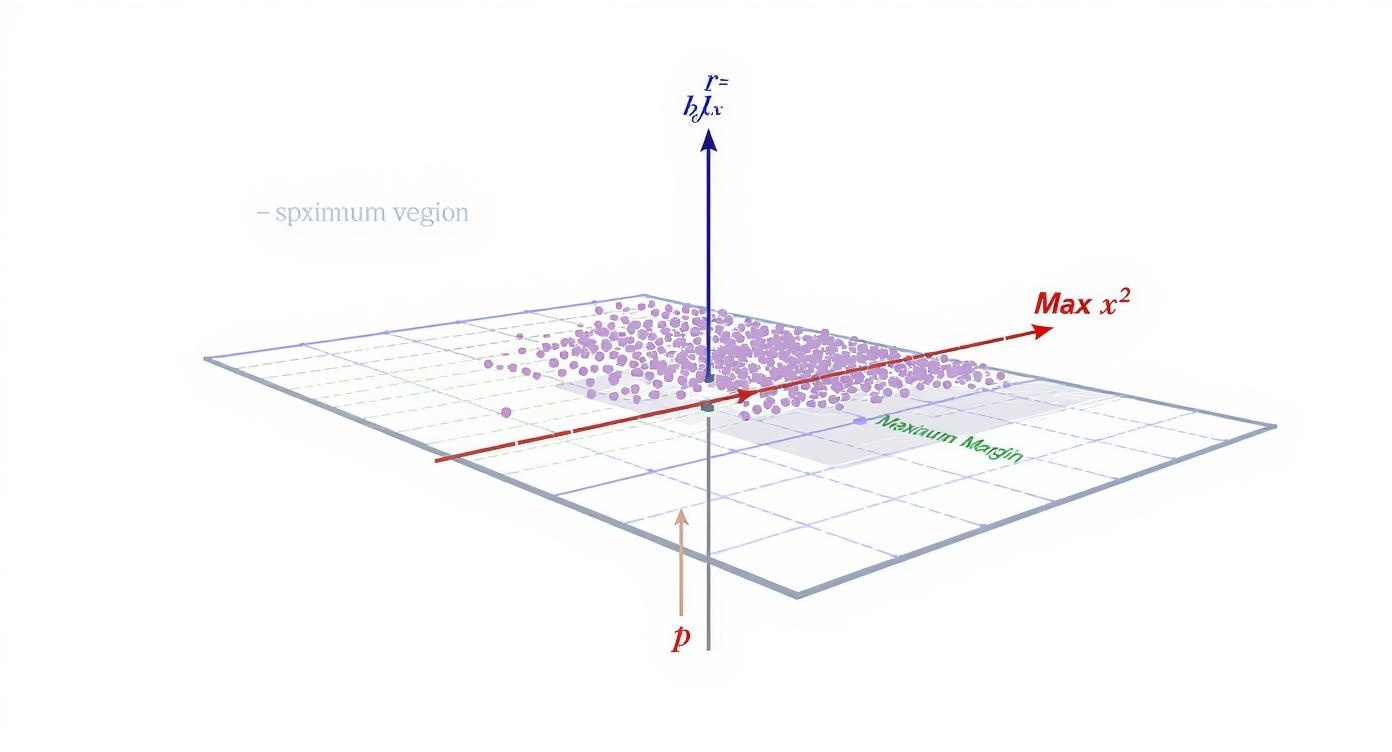

这就是SVM的核心思想!在数学世界里,这根绳子叫做分隔超平面,而那些离绳子最近的水果叫做支持向量。

SVM的三个核心概念,用大白话解释

1. 最大间隔:给分界线留点"缓冲区"

还是水果店的例子。假设你有很多种方法在苹果和橘子之间画线,但SVM选择的是那条让两边"安全距离"最大的线。

就像在高速公路上开车,你总是希望离左右两边的车都远一点,这样最安全。SVM也是这个道理——选择最安全的分界线。

2. 支持向量:关键的"哨兵"

在你的水果桌上,只有那些最靠近分界线的苹果和橘子才真正重要——它们决定了这条线应该画在哪里。这些关键的水果就是"支持向量"。

有趣的是,即使你拿走桌上其他所有的水果,只留下这些支持向量,分界线的位置也不会改变。这就是为什么它们这么重要!

3. 软间隔:允许"不听话"的水果

现实生活中,总有一些"不听话"的水果。比如有个橘子可能滚到了苹果那边。SVM很聪明,它允许少数几个水果在"错误"的一边,但会对它们进行"罚分"。

这个宽容度由一个叫做C参数的东西控制。C越大,SVM越严格,不允许任何错误;C越小,SVM越宽容,允许一些小错误存在。

核技巧:当问题变复杂时的"魔法"

现实问题:水果不总是乖乖分开的

想象现在桌上的情况变了:红苹果在中间,绿苹果围绕在外面。这时候,无论你怎么画直线,都没法把它们完美分开。

这就是核技巧登场的时候!

三种常用的"魔法"方式

1. 线性核:简单直接的直线

- 就像用尺子画直线

- 适合那些本来就能用直线分开的问题

- 在文本分类(比如垃圾邮件检测)中效果很好

2. 多项式核:优雅的曲线

- 像用圆规画弧线

- 能处理稍微复杂一点的分布

- 常用于图像识别,比如手写数字识别

3. RBF核:万能的橡皮泥

- 像橡皮泥一样,可以捏成任何形状

- 能处理最复杂的数据分布

- 是最常用的核函数,适用于大部分问题

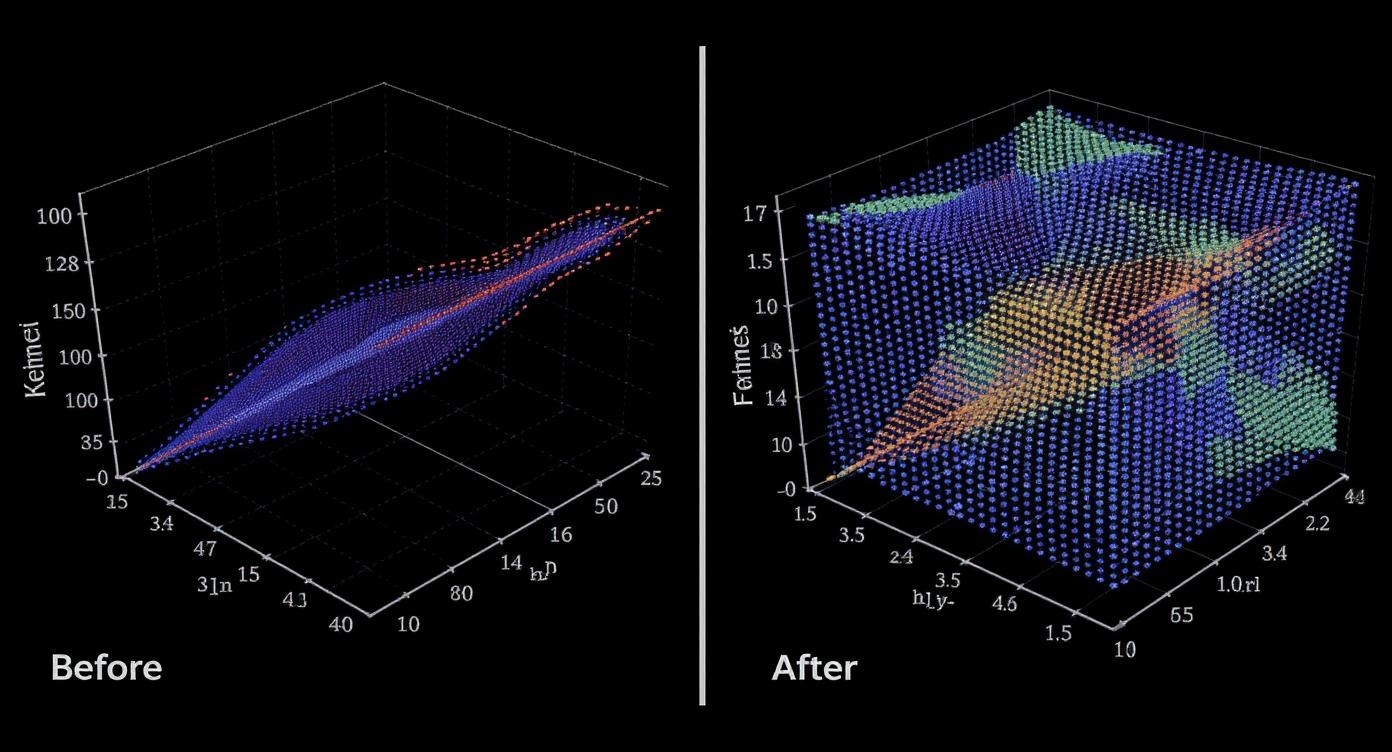

从上面的可视化图可以看出:

- 线性核只能画直线,对复杂的同心圆数据无能为力(准确率只有63%)

- 多项式核能画曲线,但还是不够灵活(准确率59%)

- RBF核最厉害,能完美处理复杂模式(准确率100%)

参数调优:找到最佳设置

SVM有几个重要参数需要调节,就像调节收音机找到最清晰的电台一样:

C参数:严格程度控制器

- C大 = 严格老师,不允许任何错误,但可能过于苛刻

- C小 = 宽松老师,允许一些错误,但可能不够精确

gamma参数(对RBF核):影响范围控制器

- gamma大 = 每个数据点只影响很小的范围,决策边界很复杂

- gamma小 = 每个数据点影响较大范围,决策边界比较平滑

最佳的参数组合通常需要通过网格搜索来找到,就像试验不同的收音机频率,直到找到最清楚的那个。

实战案例1:手写数字识别

让我们看看SVM如何识别手写数字。MNIST数据集包含6万张手写数字图片,每张图片是8×8像素的黑白图像。

# 简化版的手写数字识别代码

from sklearn import datasets, svm

from sklearn.model_selection import train_test_split

# 加载数据

digits = datasets.load_digits()

X = digits.data # 图片数据(已经展平成64维向量)

y = digits.target # 标签(0-9的数字)

# 分割训练集和测试集

X_train, X_test, y_train, y_test = train_test_split(X, y, test_size=0.3)

# 创建SVM分类器

clf = svm.SVC(kernel='rbf', gamma='scale')

# 训练模型

clf.fit(X_train, y_train)

# 预测并计算准确率

accuracy = clf.score(X_test, y_test)

print(f"准确率: {accuracy:.2%}")

结果分析:

- SVM在手写数字识别上能达到97%以上的准确率

- RBF核表现最好,因为手写数字的特征分布比较复杂

- 关键在于参数调优,特别是gamma参数的选择

实战案例2:垃圾邮件过滤

垃圾邮件过滤是SVM的另一个经典应用。邮件文本需要先转换成数字特征,这里用到TF-IDF技术。

# 垃圾邮件分类示例

from sklearn.feature_extraction.text import TfidfVectorizer

from sklearn.svm import LinearSVC

# 示例邮件数据

emails = [

"恭喜中奖100万,点击领取",

"明天的会议推迟到下午3点",

"免费送iPhone,限时优惠",

"项目进度报告已发送"

]

labels = [1, 0, 1, 0] # 1=垃圾邮件,0=正常邮件

# 文本向量化

vectorizer = TfidfVectorizer(max_features=1000)

X = vectorizer.fit_transform(emails)

# 训练SVM

clf = LinearSVC(C=1.0)

clf.fit(X, labels)

# 预测新邮件

new_email = ["限时优惠,买一送一"]

prediction = clf.predict(vectorizer.transform(new_email))

print("预测结果:", "垃圾邮件" if prediction[0] == 1 else "正常邮件")

为什么用线性核?

- 文本特征通常维度很高(几千到几万维)

- 在高维空间中,很多问题变成线性可分

- 线性核训练快,内存占用小,适合大规模文本处理

多分类:当选择不止两个时

现实中的分类问题往往不是简单的"是"或"否",而是要从多个选项中选择。比如识别手写数字时,要从0-9这10个数字中选择。

SVM原本只能处理二分类,但聪明的科学家想出了两种策略:

一对一策略:擂台赛模式

- 让每两个类别都比试一场

- 比如识别0-9的数字,需要进行45场比赛(10×9÷2)

- 最后看哪个类别赢得最多场比赛

一对多策略:车轮战模式

- 让每个类别对抗所有其他类别

- 比如"0 vs 非0"、"1 vs 非1",总共10场比赛

- 看哪个分类器最有信心

在实际应用中,scikit-learn会自动选择合适的策略,用户不需要担心这些细节。

SVM的优点和缺点

优点:

✅ 高维数据处理能力强:即使特征数量比样本数量还多也能工作

✅ 内存效率高:只需要存储支持向量,通常只占训练数据的一小部分

✅ 泛化能力好:不容易过拟合

✅ 灵活性强:通过不同核函数适应各种数据分布

缺点:

❌ 大数据集训练慢:时间复杂度在O(n²)到O(n³)之间

❌ 对参数敏感:需要仔细调优C、gamma等参数

❌ 需要特征缩放:对数据的尺度很敏感

❌ 不提供概率估计:只给出分类结果,不告诉你有多确定

实用建议:让SVM为你更好地工作

1. 数据预处理很重要

from sklearn.preprocessing import StandardScaler

# 数据标准化(让所有特征都在相似的尺度上)

scaler = StandardScaler()

X_scaled = scaler.fit_transform(X)

2. 从简单开始

- 先试试线性核,如果效果不好再考虑RBF核

- 大部分情况下,RBF核是一个安全的选择

3. 用网格搜索找最佳参数

from sklearn.model_selection import GridSearchCV

# 定义参数范围

param_grid = {

'C': [0.1, 1, 10, 100],

'gamma': ['scale', 'auto', 0.001, 0.01, 0.1, 1]

}

# 网格搜索

grid_search = GridSearchCV(svm.SVC(), param_grid, cv=5)

grid_search.fit(X_train, y_train)

print("最佳参数:", grid_search.best_params_)

4. 处理类别不平衡问题

# 如果某个类别的样本特别少

clf = svm.SVC(class_weight='balanced')

总结:SVM的智慧

SVM就像一个经验丰富的分拣员,它不是简单地划一条线,而是要找到最安全、最稳定的分界线。通过核技巧,它还能处理复杂的分布模式,就像变形金刚一样灵活多变。

虽然现在深度学习很热门,但SVM在很多场景下仍然是首选:

- 小数据集:当你只有几百或几千个样本时

- 高维稀疏数据:比如文本分类

- 需要可解释性:当你需要理解模型为什么这样分类时

- 资源受限:当你的计算资源有限时

记住,机器学习不是魔法,而是工具。选择合适的工具解决合适的问题,才是真正的智慧。SVM就是这样一个既强大又实用的工具,值得每个数据科学爱好者掌握。