想象一下,如果计算机能够像人类一样理解关系,会发生什么。不是简单的数字或像素,而是朋友之间的友谊、分子中原子间的化学键、或者论文之间的引用关系。这就是图神经网络(Graph Neural Networks,GNN)所要解决的核心问题——让机器学会理解这个充满连接的世界。

网页版: https://lbjbcntb.gensparkspace.com/

视频版:https://www.youtube.com/watch?v=eH4uAXaWy1w

当我第一次听说图神经网络时,脑海中浮现的是一个令人着迷的画面:无数个节点通过边连接,就像星座图中的星星通过想象的线条连接成美丽的图案。但与星座不同的是,这些连接是真实的,承载着信息,诉说着故事。

从图的本质说起:扎卡里空手道俱乐部的故事

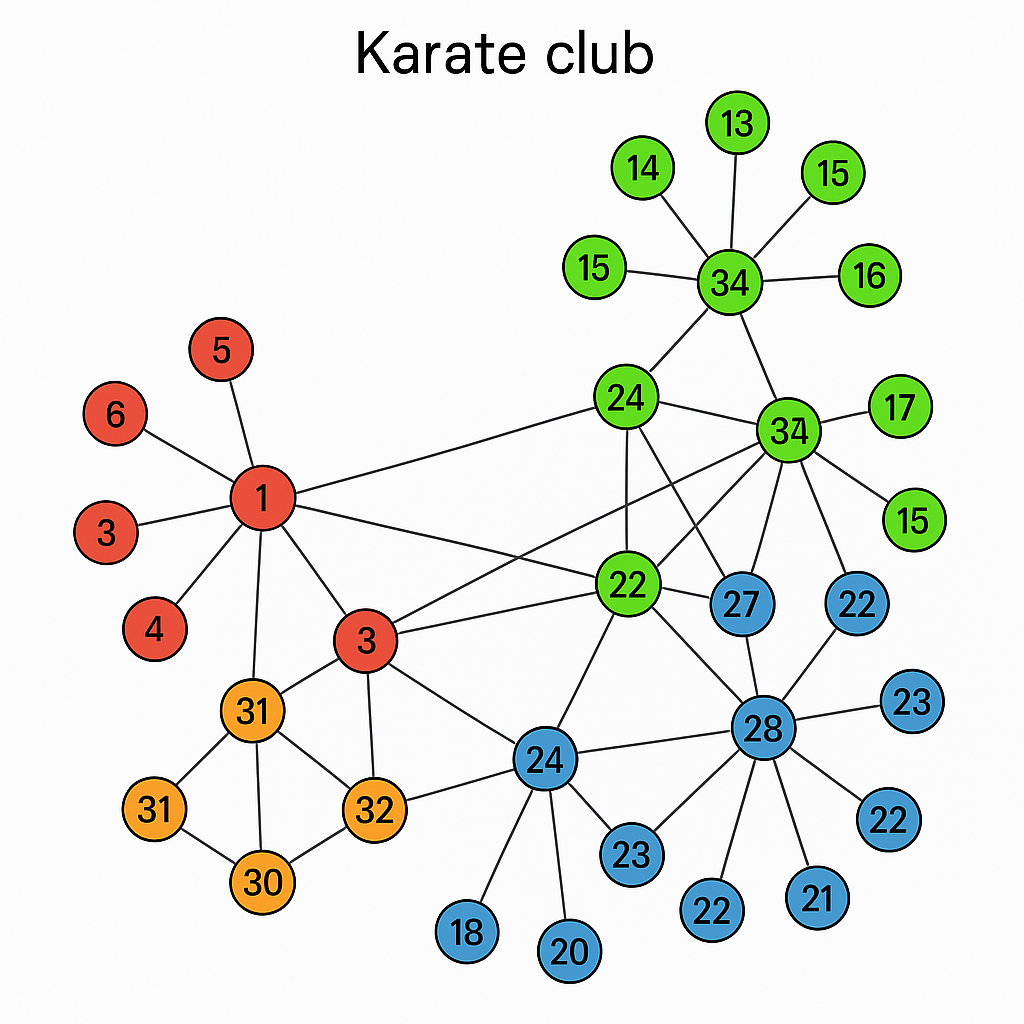

让我先给你讲一个有趣的故事。在1970年代,韦恩·扎卡里(Wayne Zachary)在观察一个空手道俱乐部时,无意中创造了机器学习历史上最著名的数据集之一。这个俱乐部因为教练和管理员之间的分歧而分裂,34名成员最终分成了不同的阵营。

扎卡里将每个成员视为一个节点,将他们之间的互动关系用边连接起来。这个简单的图结构竟然能够预测成员最终会选择哪个阵营——这就是关系的力量,也是图神经网络的魅力所在。

在数学上,图G被定义为一个包含节点集合V和边集合E的元组:G = (V, E)。但这个冰冷的定义背后,隐藏着无穷的可能性。每个节点可以是一个人、一个原子、一篇论文,或者任何可以被抽象的实体。而边则代表着这些实体之间的关系——友谊、化学键、引用关系等等。

图卷积网络:关系中的学习

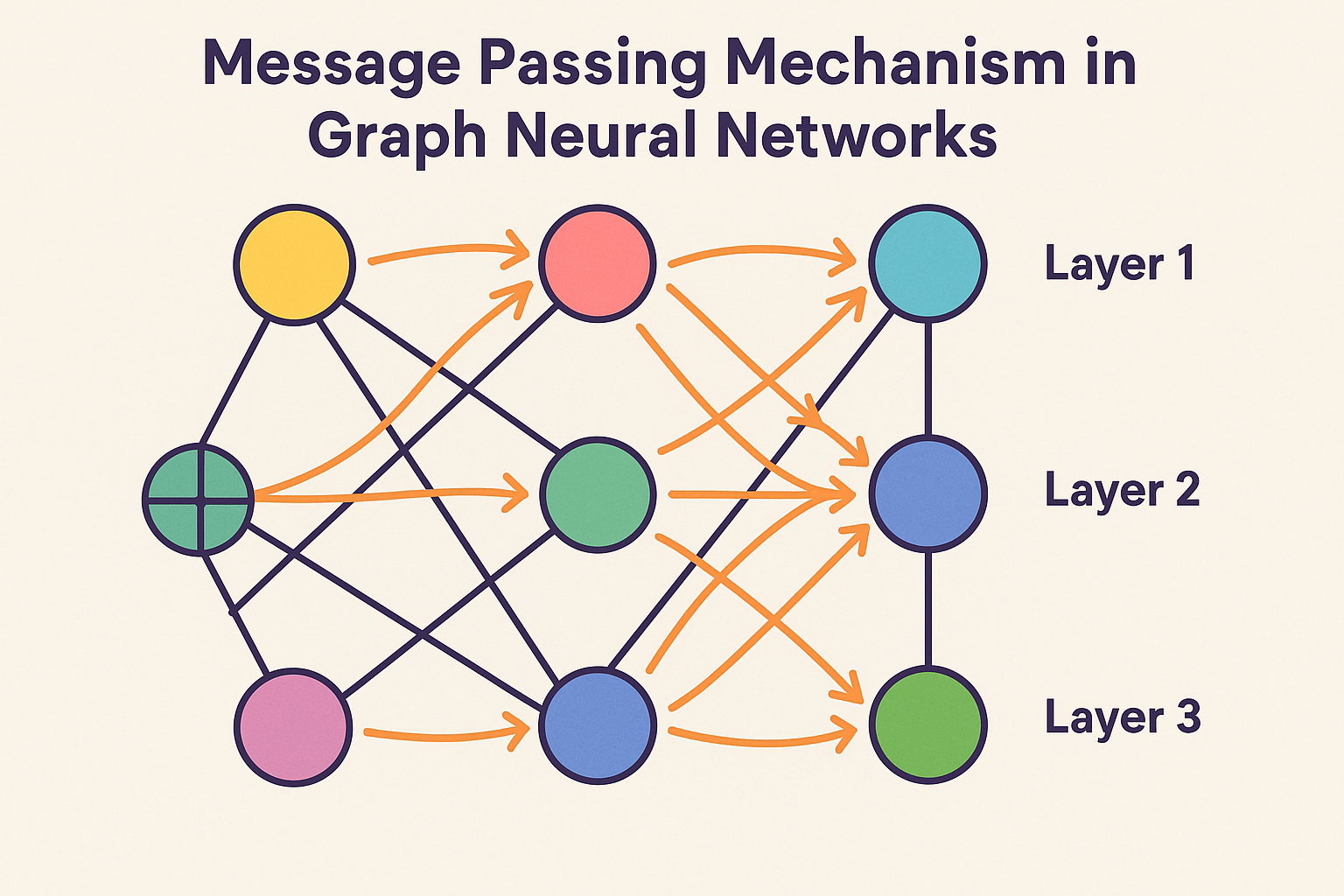

传统的卷积神经网络(CNN)在处理图像时表现出色,因为图像有着规整的网格结构。但当面对图数据时,这种规整性消失了——有些节点可能只有一个邻居,而另一些可能有数百个邻居。这就像试图在一个形状不规则的拼图上应用统一的模板,显然行不通。

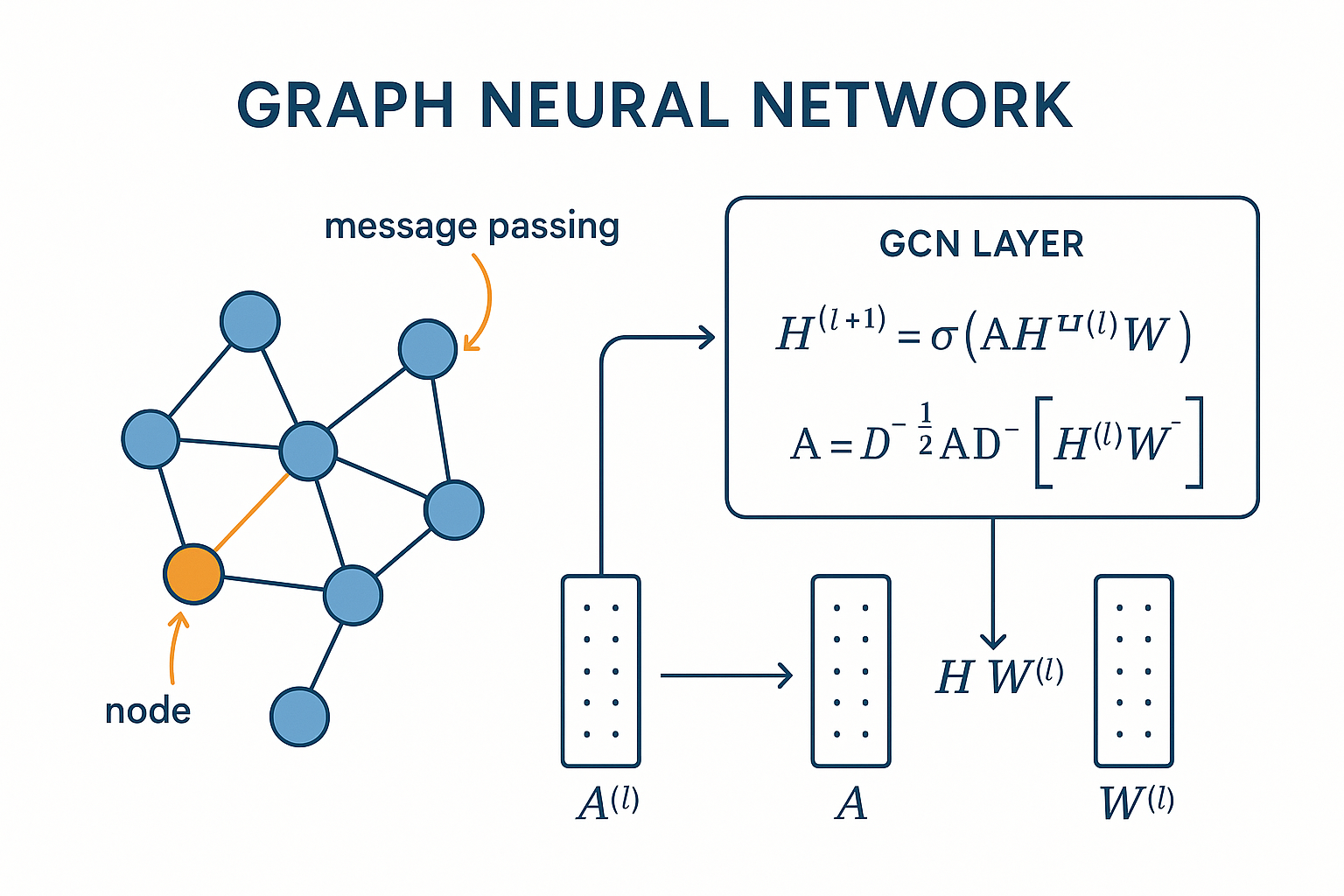

托马斯·基普夫(Thomas Kipf)在2016年提出的图卷积网络(GCN)巧妙地解决了这个问题。GCN的核心思想是:每个节点不仅要关注自己的特征,还要聚合邻居节点的信息。

想象一下社交网络中的信息传播:你的观点会受到朋友们的影响,而你的观点也会影响朋友。GCN正是模拟了这种信息传播机制。对于节点v,它会收集所有邻居节点的特征向量,取平均值,然后通过一个可学习的变换矩阵W进行处理:

H^(l+1) = σ(D^(-1/2)AD^(-1/2)H^(l)W^(l))

这个公式看起来复杂,但理解起来很直观。H^(l)是第l层的节点特征,A是邻接矩阵,D是度矩阵,σ是激活函数。本质上,这是在说:"每个节点的新表示是其邻居特征的加权平均,权重由网络结构决定。"

注意力机制的引入:GAT的智慧

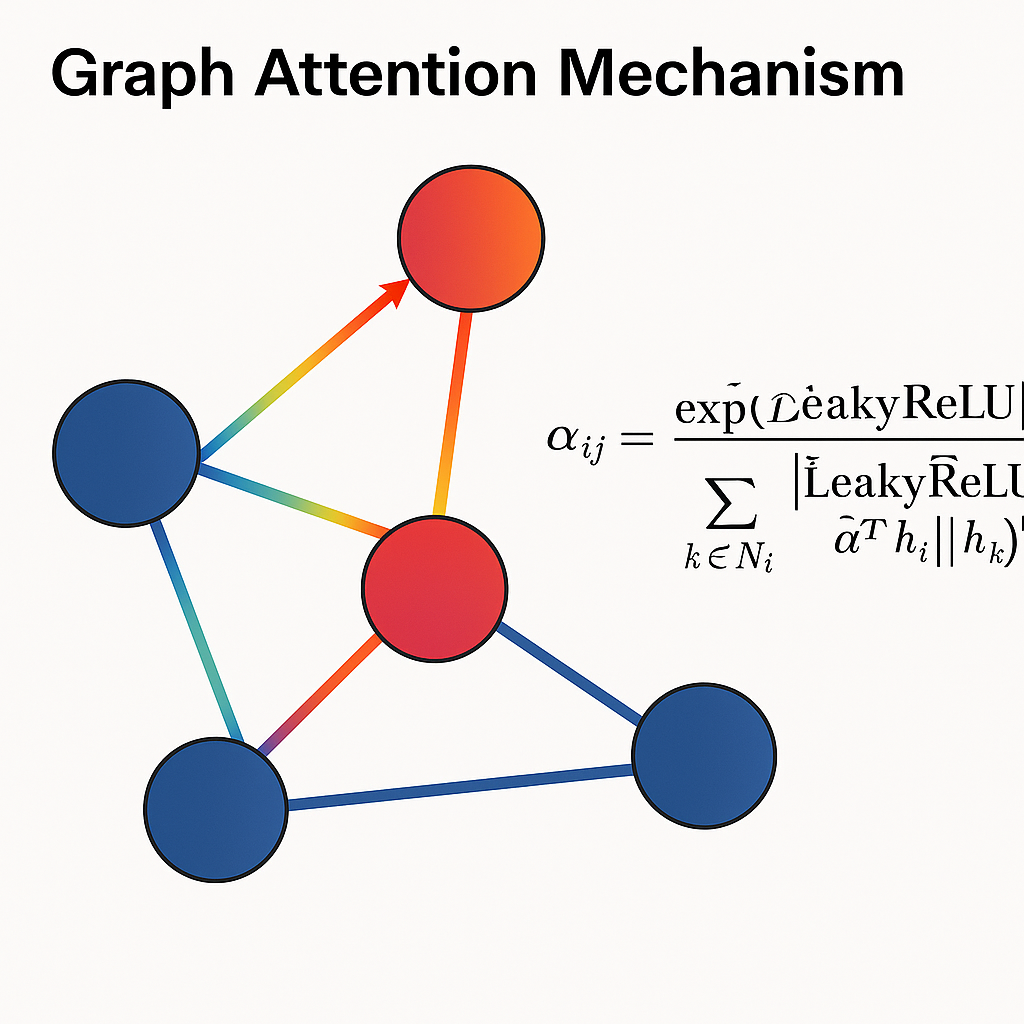

虽然GCN表现出色,但它有一个明显的限制:所有邻居节点被平等对待。在现实世界中,这显然不合理。在学术网络中,来自顶级期刊的引用应该比普通期刊的引用更有价值;在社交网络中,密友的影响应该比点头之交更大。

Petar Veličković等人在2017年提出的图注意力网络(GAT)引入了注意力机制来解决这个问题。GAT的核心创新是为每对相邻节点学习一个注意力权重,动态地决定每个邻居的重要性。

GAT的注意力计算过程像是一场精密的舞蹈:

- 首先,节点i和节点j通过权重矩阵W变换后拼接

- 通过注意力函数计算原始注意力得分

- 使用LeakyReLU激活函数增加非线性

- 通过softmax归一化得到最终的注意力权重

这个过程让每个节点能够"选择性地倾听"不同邻居的"声音",就像在嘈杂的聚会中专注于重要对话一样。

GNN架构的全景对比

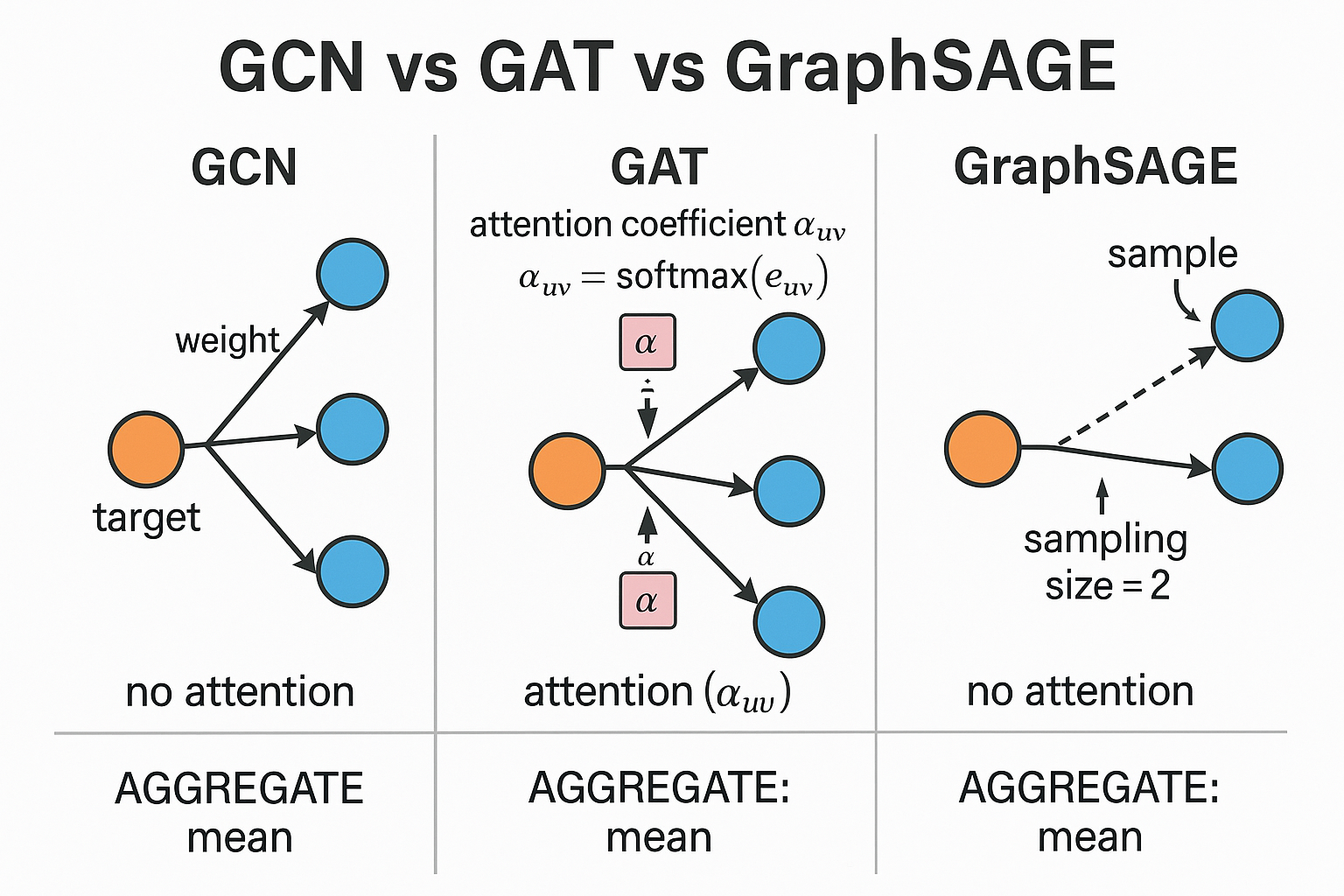

当我们把主流的图神经网络架构放在一起比较时,每种方法的独特之处就变得清晰了:

**GCN(图卷积网络)**是基础架构,通过简单的邻居聚合实现信息传递。它就像是村庄里的消息传递——每个人都会听取所有邻居的意见,然后取个平均值。

**GAT(图注意力网络)**引入了选择性倾听的能力,通过注意力权重决定哪些邻居更重要。这就像是一个善于社交的人,知道在什么时候应该更多地倾听哪些朋友的建议。

GraphSAGE则采用了采样策略,不是听取所有邻居的意见,而是随机选择一些代表性的邻居。这种方法在大规模网络中特别有用,就像是在繁忙的聚会中,你不可能和每个人都深入交流,只能选择性地与一些人深谈。

GraphSAGE:采样与聚合的艺术

当图变得非常大时,传统的GNN方法面临计算瓶颈。想象一下Facebook的社交图谱,有数十亿个节点和边——即使是最强大的计算机也难以处理如此规模的完整图结构。

斯坦福大学的研究团队提出的GraphSAGE(Graph Sample and Aggregate)巧妙地解决了这个问题。它的核心思想是采样和聚合:不是使用所有邻居,而是随机采样固定数量的邻居,然后通过聚合函数(如均值、最大值或LSTM)来组合邻居信息。

GraphSAGE的优雅之处在于它的归纳学习能力。传统的GCN在训练时需要看到所有节点,而GraphSAGE可以泛化到未见过的节点——这就像学会了游泳的原理后,即使换到新的游泳池也能游得很好。

图池化:从局部到全局的抽象

在计算机视觉中,池化层帮助CNN逐步抽象图像特征,从边缘检测到对象识别。在图神经网络中,我们同样需要这种分层抽象能力,这就是图池化层的作用。

图池化面临的挑战比图像池化复杂得多。图像有规整的网格结构,而图是不规则的。研究者们提出了多种创新的解决方案:

- 全局池化:简单地对所有节点特征求和或平均

- 层次池化:递归地合并相似的节点,构建层次结构

- 可学习池化:使用神经网络学习如何合并节点

每种方法都有其独特的优势和适用场景,就像不同的艺术技法适合表现不同的主题。

图嵌入:高维空间中的降维魔法

图嵌入是将图中的节点映射到低维向量空间的技术,这些向量保持了原图中的结构信息。想象一下,如果我们能够将复杂的社交网络压缩成几百维的向量,每个人都变成了高维空间中的一个点,而关系密切的人在这个空间中彼此靠近。

Node2Vec和DeepWalk等方法通过随机游走来学习节点表示。它们就像在图中进行随机漫步,记录经过的路径,然后使用类似Word2Vec的技术学习节点的向量表示。这种方法的巧妙之处在于,它将图结构问题转换为了序列处理问题。

实际应用:从理论到实践的桥梁

让我告诉你一些令人兴奋的应用故事。在药物发现领域,研究人员使用GNN来预测分子的性质。他们将分子表示为图——原子是节点,化学键是边——然后训练GNN来预测毒性、溶解度等重要性质。

分子性质预测:DeepMind的AlphaFold2在蛋白质结构预测上的突破,部分归功于图神经网络对氨基酸残基间相互作用的精确建模。

推荐系统:Pinterest使用了一个名为PinSage的GNN来理解用户行为和物品之间的复杂关系。他们构建了一个包含数十亿节点的图,其中用户、图片、兴趣标签都是节点,它们之间的交互构成了边。

学术网络分析:研究人员使用GNN分析引用网络,预测论文的影响力,发现研究趋势,甚至检测学术不端行为。每篇论文都是一个节点,引用关系构成了边,GNN能够从这些关系中学习到丰富的语义信息。

社交网络分析:在反欺诈系统中,GNN可以识别可疑的账户集群,因为欺诈账户往往表现出特定的连接模式。

实现之路:PyTorch Geometric的实践魅力

当理论遇到实践时,PyTorch Geometric成为了桥梁。这个库将复杂的图操作封装成简洁的API,让研究人员能够专注于模型设计而不是底层实现。

让我们看一个简单的例子。假设我们要在Zachary空手道俱乐部数据集上进行节点分类:

import torch

import torch.nn.functional as F

from torch_geometric.nn import GCNConv

from torch_geometric.datasets import KarateClub

# 加载数据

dataset = KarateClub()

data = dataset[0]

# 定义模型

class GCN(torch.nn.Module):

def __init__(self):

super().__init__()

self.conv1 = GCNConv(dataset.num_features, 16)

self.conv2 = GCNConv(16, dataset.num_classes)

def forward(self, x, edge_index):

x = self.conv1(x, edge_index)

x = F.relu(x)

x = self.conv2(x, edge_index)

return F.log_softmax(x, dim=1)

# 训练循环

model = GCN()

optimizer = torch.optim.Adam(model.parameters(), lr=0.01)

for epoch in range(200):

optimizer.zero_grad()

out = model(data.x, data.edge_index)

loss = F.nll_loss(out, data.y)

loss.backward()

optimizer.step()

这段代码的美妙之处在于其简洁性。短短几行代码就定义了一个完整的图神经网络,能够学习节点之间的复杂关系模式。

可视化的力量:理解黑盒中的奥秘

图神经网络的一大挑战是可解释性。当我们看到模型做出预测时,很难理解它是如何得出结论的。幸运的是,研究人员开发了各种可视化技术来窥探这个黑盒。

GNNExplainer是一个受欢迎的工具,它能够识别对预测最重要的子图结构。想象一下,当GNN预测某个分子有毒时,GNNExplainer能够高亮显示导致毒性的关键原子和化学键——这对于药物设计具有重要意义。

注意力可视化是另一个强大的工具。在GAT中,我们可以直接可视化注意力权重,看到每个节点对邻居的关注程度。这就像是能够读取模型的"思维",理解它认为哪些关系更重要。

挑战与机遇:未来的地平线

尽管GNN取得了巨大成功,但仍面临诸多挑战:

**过度平滑(Over-smoothing)**是一个关键问题:当网络层数过多时,所有节点的表示会趋于相同,失去区分性。这就像是信息在传播过程中逐渐模糊,最终变得无法区分。

异构图处理是另一个前沿领域。现实世界的图通常包含多种类型的节点和边——比如学术网络中的作者、论文、会议等不同类型实体。如何有效地处理这种异构性是一个活跃的研究方向。

动态图学习也备受关注。现实中的图是不断变化的——新的朋友关系建立,旧的联系消失。如何让GNN适应这种动态变化是一个有趣的挑战。

计算可扩展性仍然是实际应用中的瓶颈。虽然GraphSAGE等方法提供了解决方案,但在真正的大规模图(如包含数十亿节点的社交网络)上进行实时推理仍然具有挑战性。

工程实现的智慧

在实际部署中,GNN面临着独特的工程挑战。图数据的不规则性使得批处理变得复杂——不同的图有不同的大小和结构,如何高效地打包成批次需要巧妙的设计。

Mini-batch训练是一个关键技术。FastGCN和GraphSAINT等方法通过采样子图来实现高效的批处理,使得在大规模图上训练成为可能。

分布式训练是另一个前沿。当图太大无法放入单机内存时,需要将图分割到多个机器上。如何在保持图结构完整性的同时实现高效的分布式计算是一个活跃的研究领域。

GPU优化也很重要。图操作的不规则内存访问模式对GPU并行计算提出了挑战。专门的CUDA内核和稀疏矩阵优化技术使得GNN能够充分利用现代硬件的并行性。

理论基础的深入

从理论角度看,GNN的表达能力是一个核心问题。Weisfeiler-Lehman测试为理解GNN的理论限制提供了框架。简单来说,如果两个图无法通过WL测试区分,那么基于消息传递的GNN也无法区分它们。

这一发现催生了更强大的GNN架构。**Graph Isomorphism Network(GIN)**被证明与WL测试等价,达到了消息传递GNN的理论上限。而更新的方法如高阶GNN和基于谱方法的GNN试图超越这一限制。

持久同调和代数拓扑的引入为GNN提供了新的理论工具。通过分析图的拓扑性质,这些方法能够捕获传统GNN忽略的结构信息,如环和高维结构。

走向未来:图神经网络的明天

站在今天的视角回望,图神经网络在短短几年内就从一个小众研究领域发展成为深度学习的重要分支。它的成功不仅在于技术本身,更在于它为人工智能提供了一种全新的思维范式——理解关系和结构的重要性。

自适应图构建技术可能让模型能够自动发现数据中的潜在关系结构。想象一个系统能够自动识别看似无关的数据点之间的隐藏联系。

多模态图学习将整合文本、图像、语音等不同模态的信息。未来的GNN可能能够理解一张图片中对象之间的关系,同时结合相关的文本描述和语音注释。

神经符号学习可能将逻辑推理与图学习结合。这种方法可以让GNN不仅学习模式,还能进行逻辑推理,在知识图谱和专家系统中具有巨大潜力。

量子图神经网络是一个极具前景的方向。量子计算的并行性可能为大规模图处理带来指数级的加速。虽然目前还处于初期阶段,但其潜力不容小觑。

结语:关系的未来

当我们凝视星空时,看到的不仅仅是孤立的星点,更是星座间的连接和宇宙的结构。图神经网络教会我们用同样的眼光看待数据——不仅关注个体,更要理解它们之间的关系。

在这个万物互联的时代,理解关系变得前所未有的重要。从社交网络到生物网络,从知识图谱到供应链,图无处不在。而图神经网络,正是我们解读这个关系世界的钥匙。

也许有一天,当人工智能真正理解了关系的本质,它就能像人类一样思考,甚至超越人类的认知边界。而那时,我们回望今天的图神经网络,或许会感叹这是一切的开始——关系的时代,才刚刚拉开序幕。

图神经网络不仅是一种技术,更是一种认识世界的新方式。它告诉我们,在这个复杂的世界中,孤立的个体并不能完整地描述现实,只有理解了个体之间的关系,我们才能真正把握事物的本质。这种洞察,或许正是人工智能迈向真正智能的关键一步。